Introduction

Cette publication fait suite à un premier ouvrage (Évaluation : fondements, controverses, perspectives) publié fin 2021 aux éditions Science et bien commun (ESBC) avec l’appui du Laboratoire interdisciplinaire d’évaluation des politiques publiques (LIEPP), compilant une série d’extraits de textes fondamentaux et contemporains en évaluation (Delahais et al. 2021). Bien qu’une partie de ce livre soit dédiée à la diversité des approches paradigmatiques, nous avions choisi de ne pas rentrer dans le détail de la présentation des méthodes au motif que celle-ci mériterait au moins un ouvrage à part entière. C’est l’objet de ce volume. Cette publication s’inscrit doublement dans le projet collectif du LIEPP, par l’articulation proposée entre recherche et évaluation, et par l’ouverture d’un dialogue entre méthodes quantitatives et qualitatives.

Des méthodes entre recherche et évaluation

La plupart des définitions de l’évaluation de programmes[1] articulent trois dimensions, décrites par Alkin et Christie comme les trois branches de « l’arbre des théories en évaluation » (Alkin et Christie 2012) : la mobilisation de méthodes de recherche (l’évaluation prend appui sur une démarche d’investigation empirique systématique), le rôle joué par les valeurs, au fondement des critères à partir desquels on va porter un jugement sur l’intervention étudiée, et l’attention prêtée à l’utilité de l’évaluation.

Le fait de recourir à des méthodes systématiques d’investigation empirique constitue donc un des fondements de la pratique de l’évaluation. C’est ce en quoi l’évaluation au sens de recherche évaluative se distingue du simple jugement subjectif que peut par ailleurs désigner le terme « évaluation » dans son sens commun (Suchman 2021). L’évaluation est d’abord une pratique de recherche appliquée et, à ce titre, elle a emprunté toute une série de techniques d’enquête, aussi bien quantitatives que qualitatives, initialement développées en recherche fondamentale (ex. questionnaires, analyses quantitatives sur des bases de données, méthodes expérimentales, entretiens semi-directifs, observations, étude de cas, etc.). Au-delà des techniques, l’emprunt concerne aussi les modalités d’analyse et la conception des designs de recherche. En dépit de ce fort lien méthodologique, l’évaluation ne se réduit pas à une pratique de recherche (Wanzer 2021), comme le suggèrent les deux autres dimensions précédemment identifiées (souci des valeurs et de l’utilité). De fait, le développement de l’évaluation de programmes a donné lieu à une pluralité de pratiques par une diversité d’acteurs publics et privés (administrations publiques, consultant·e·s, O.N.G, etc.), pratiques au sein desquelles les enjeux méthodologiques ne sont pas nécessairement centraux et où la rigueur méthodologique peut être très variable.

Parallèlement, la pratique de l’évaluation est restée faiblement et très inégalement institutionnalisée à l’université (Cox 2021), où elle souffre notamment d’une fréquente dévalorisation des pratiques de recherche appliquée, de soupçons de complaisance vis-à-vis des commanditaires, ou encore de difficultés liées à son caractère interdisciplinaire (cf infra) (Jacob 2021). Ainsi, bien qu’elle ait développé ses revues et ses conférences professionnelles, l’évaluation fait encore l’objet de peu de programmes doctoraux et de recrutements dédiés. Pratiquée à des degrés divers par différentes disciplines universitaires (la santé publique, l’économie et le développement sont aujourd’hui particulièrement impliqués), et parfois qualifiée de « transdiscipline » sur le plan de sa portée épistémologique (Scriven 2021), l’évaluation est encore loin de constituer une discipline universitaire au sens institutionnel du terme. Sur le plan épistémologique, on peut se féliciter de cette non- (ou faible) disciplinarisation de l’évaluation à l’Université. Il n’en demeure pas moins que celle-ci induit des fragilités. Une des conséquences de cette situation est un fréquent défaut de formation des chercheurs et chercheuses en évaluation : notamment concernant les dimensions non méthodologiques de cette pratique (questions des valeurs et de l’utilité), mais aussi quant à certaines méthodes plus spécifiquement issues de l’évaluation.

En effet, si l’évaluation a largement emprunté aux méthodes de sciences sociales, elle a réciproquement été le creuset d’un certain nombre d’innovations méthodologiques. C’est ainsi à partir de la démarche d’évaluation, initialement en éducation dans les années 1920 puis dans les politiques sociales, la santé et d’autres domaines à partir des années 1960, que l’usage de méthodes expérimentales a pris son essor dans les sciences sociales (Campbell et Stanley 1963). Le rapprochement avec la médecine occasionné par l’emprunt du modèle de l’essai clinique (les notions « d’essai » et de « traitement » ayant ainsi été transposées à l’évaluation) a ensuite favorisé le transfert des sciences médicales à l’évaluation d’une autre méthode, les revues systématiques de littérature, consistant à se doter d’un protocole systématique pour rechercher les publications existantes sur une (ou des) question(s) évaluative(s) donnée(s) et dresser une synthèse de leurs apports (Hong et Pluye 2018; Belaid et Ridde 2020). Sans en être le seul lieu de déploiement, l’évaluation de programmes a aussi fortement contribué au développement et à la théorisation des méthodes mixtes, consistant à articuler des techniques d’enquêtes et/ou démarches d’analyse qualitatives et quantitatives dans une même recherche (Baïz et Revillard 2022; Greene, Benjamin, et Goodyear 2001; Burch et Heinrich 2016; Mertens 2017). De façon similaire, du fait de sa préoccupation centrale vis-à-vis de l’utilisation des savoirs, l’évaluation a été un lieu privilégié du développement des recherches participatives et de leur théorisation (Brisolara 1998; Cousins et Whitmore 1998; Patton 2018).

Si ces méthodes (méthodes expérimentales, revues systématiques de littérature, méthodes mixtes, recherche participative) sont immédiatement applicables à d’autres domaines que l’évaluation de programmes, d’autres approches et outils méthodologiques ont été plus spécifiquement développé·e·s à cette fin[2]. C’est notamment le cas des évaluations basées sur la théorie (Weiss 1997; Rogers et Weiss 2007), incluant une diversité d’approches (évaluation réaliste, analyse de contribution, récolte d’incidence…) qui seront décrites ci-dessous (Pawson et Tilley 1997; Mayne 2012; Wilson-Grau 2018). En dehors de quelques disciplines au sein desquelles elles sont plus diffusées, comme la santé publique ou le développement (Ridde et Dagenais 2009; Ridde et al. 2020), ces approches restent encore peu connues des chercheurs et chercheuses ayant suivi des formations classiques en méthodes de recherche… Y compris de celles et ceux pouvant être amené·e·s à s’impliquer dans des projets d’évaluation.

Un dialogue a donc besoin d’être renoué entre évaluation et recherche : selon la dynamique réciproque de l’emprunt initial aux méthodes de recherche par l’évaluation, une plus grande diversité de milieux en recherche fondamentale gagne aujourd’hui à mieux connaître les méthodes et approches spécifiques développées à partir de la pratique de l’évaluation. C’est une des vocations du LIEPP, qui promeut un renforcement des échanges entre chercheur·e·s et praticien·ne·s de l’évaluation. Le LIEPP organise ainsi depuis 2020 un séminaire mensuel sur les méthodes et approches en évaluation (METHEVAL) alternant des présentations de chercheur·e·s et de praticien·ne·s, et réunissant une diversité de public[3]. C’est également une des motivations à l’origine de l’ouvrage Évaluation : fondements, controverses, perspectives, publié en 2021, qui visait notamment à sensibiliser les chercheur·e· aux aspects non méthodologiques de l’évaluation (Delahais et al. 2021). La présente publication vient compléter la démarche en facilitant l’appropriation d’approches développées en évaluation telle que l’évaluation basée sur la théorie, l’évaluation réaliste, l’analyse de contribution et la récolte d’incidence (outcome harvesting).

Mais réciproquement, le LIEPP fait le pari que l’évaluation gagne à davantage s’ouvrir à des outils méthodologiques plus fréquemment mobilisés dans la recherche fondamentale et dont elle est moins familière, notamment du fait du ciblage du questionnement à l’échelle de l’intervention. En effet, l’évaluation prend classiquement pour objet une intervention ou un programme, à une échelle le plus souvent locale, régionale ou nationale, et dans un périmètre de questionnement suffisamment ciblé pour permettre de tirer des conclusions quant aux conséquences de l’intervention étudiée. Si nous parlons d’évaluation des politiques publiques plutôt que d’évaluation de programmes au sens strict, c’est pour inclure la possibilité d’une réflexion à une échelle plus macro au sens à la fois géographique et temporel, en intégrant des réflexions sur l’historicité des politiques publiques, sur l’agencement de différentes interventions dans un contexte plus large d’action publique (tel ou tel régime d’État-providence par exemple), et en s’appuyant plus systématiquement sur des démarches de comparaison internationale. Il s’agit donc de relier l’évaluation à une démarche d’analyse des politiques publiques, comme le défendaient déjà dans les années 1990 les promoteur·e·s d’une « évaluation à la française » (Duran, Monnier, et Smith 1995; Duran, Erhel, et Gautié 2018). C’est ce que permettent par exemple l’analyse historique comparée et les comparaisons de niveau macro, présentées dans cet ouvrage. Un autre implicite important de l’évaluation de programme est la focalisation du questionnement sur l’intervention étudiée. En décentrant le regard, de nombreuses pratiques de recherche fondamentale peuvent apporter des compléments de réflexion très utiles de façon plus prospective, en aidant à la compréhension des problèmes sociaux ciblés par les interventions. Toutes les recherches thématiques menées en sciences sociales apportent à cet égard des éclairages très utiles aux pratiques d’évaluation (Rossi, Lipsey, et Freeman 2004). Parmi les méthodes présentées dans cet ouvrage, des approches expérimentales comme l’expérimentation en laboratoire ou les démarches de testing, non nécessairement centrées sur les interventions en tant que telles, permettent d’illustrer cet apport plus prospectif de la recherche à l’évaluation.

Un dialogue entre approches qualitatives et quantitatives

En empruntant aux sciences sociales ses méthodes, l’évaluation des politiques publiques a hérité des controverses méthodologiques et épistémologiques associées. Bien que les appels à la réconciliation soient nombreux, que l’évaluation mette plus volontiers en avant son pragmatisme méthodologique (la question évaluative guide le choix des méthodes), et qu’elle ait joué un rôle moteur dans le développement des méthodes mixtes, dans la pratique, en évaluation comme en recherche, le dialogue entre traditions quantitative et qualitative (surtout dans leur dimension épistémologique) n’est pas toujours simple.

Articuler différentes approches disciplinaires et méthodologiques pour évaluer les politiques publiques est l’ambition fondatrice du LIEPP. Les difficultés de ce dialogue, notamment sur le plan épistémologique (opposition entre positivisme et constructivisme) ont été identifiées dès la création du laboratoire (Wasmer et Musselin 2013). Au fil des années, le LIEPP s’est efforcé de surmonter ces obstacles en organisant le dialogue entre différentes méthodes et disciplines pour enrichir l’évaluation : par le développement de six axes de recherche coanimés par des chercheurs et chercheuses de différentes disciplines, par la conduite de projets menés par des équipes interdisciplinaires, mais aussi par la mise en discussion régulière de projets issu d’une discipline ou famille de méthodes par des spécialistes d’autres disciplines ou méthodes. C’est aussi au fil de ces échanges qu’a émergé le besoin de supports didactiques permettant de faciliter la compréhension des méthodes quantitatives par les spécialistes de méthodes qualitatives, et vice-versa, compréhension qui devient de plus en plus difficile dans un contexte de technicisation croissante des méthodes. Cet ouvrage vient répondre à ce besoin, en prenant fortement appui sur le collectif de chercheuses et de chercheurs ouvert·e·s à l’interdisciplinarité et au dialogue entre méthodes qui s’est ainsi constitué au LIEPP au fil des années : sur les 25 autrices et auteurs de cet ouvrage, neuf sont affilié·e·s au LIEPP et huit autres ont eu l’occasion de présenter leurs travaux lors de séminaires organisés par le LIEPP.

Cet ouvrage a donc été conçu comme un moyen de favoriser le dialogue entre méthodes, au LIEPP et au-delà. L’objectif n’est pas nécessairement de promouvoir le développement de recherches par méthodes mixtes, même nous décrivons les atouts de ces démarches (Partie III). Il s’agit d’abord de favoriser une compréhension mutuelle entre les différentes approches méthodologiques, de faire en sorte que les praticiennes et praticiens de méthodes qualitatives comprennent en quoi consiste l’apport complémentaire des méthodes quantitatives, leur portée et leurs limites, et réciproquement. Ce faisant, la démarche vise aussi à favoriser une plus grande réflexivité dans chaque pratique méthodologique, grâce à une meilleure prise de conscience de ce pour quoi une méthode est la plus adaptée et des questions pour lesquelles d’autres méthodes sont plus pertinentes. Tout en évitant une technicité excessive, il s’agit de rentrer dans le fonctionnement de chaque méthode pour comprendre concrètement ce qu’elle permet et ce qu’elle ne permet pas de faire. Nous faisons le pari que cette approche pratique aidera à dépasser certains obstacles au dialogue entre méthodes liés à de grandes oppositions épistémologiques (positivisme versus constructivisme par exemple) qui ne se retrouvent pas nécessairement dans la pratique quotidienne de la recherche. Pour les étudiant·e·s et pour un public non universitaire (notamment chez des responsables publics ou associatifs qui peuvent avoir recours à des évaluations de programmes), il s’agit par ailleurs de favoriser une compréhension plus globale des apports et limites des différentes méthodes.

Loin de prétendre à l’exhaustivité, l’ouvrage se propose de présenter quelques exemples de trois grandes familles de méthodes ou approches : les méthodes quantitatives, les méthodes qualitatives, et les méthodes mixtes et approches transversales en évaluation[4]. Dans ce qui suit, nous présentons l’organisation générale de l’ouvrage et les différents chapitres en les intégrant dans une réflexion plus globale sur la distinction entre approches quantitatives et qualitatives. À un niveau très général, méthodes quantitatives et qualitatives se distinguent par la densité et l’étendue du type d’information qu’elles produisent : alors que les méthodes quantitatives permettent de produire une information limitée sur un grand nombre de cas, les méthodes qualitatives fournissent une information plus dense et contextualisée sur un nombre restreint de cas. Mais au-delà de ces caractéristiques descriptives, les deux familles de méthodes se distinguent aussi tendanciellement dans leur conception de la causalité. Il s’agit là d’une question centrale pour l’évaluation des politiques publiques qui, sans se restreindre à cette interrogation[5], s’est fondée autour d’un questionnement sur l’impact des interventions publiques : dans quelle mesure peut-on imputer tel changement observé à l’effet de telle intervention ? – Soit une question causale (peut-on établir une relation de cause à effet entre l’intervention et le changement observé ?). Pour comprendre les apports complémentaires des méthodes quantitatives et qualitatives pour l’évaluation, il importe donc de saisir leurs différentes façons d’aborder cette question centrale de la causalité.

Méthodes quantitatives

Les méthodes quantitatives expérimentales et quasi-expérimentales reposent sur une conception contrefactuelle de la causalité. Selon cette conception, pour prouver que A est cause de B, il faut montrer que toutes choses égales par ailleurs, si A est absent, B est absent (Woodward 2003). Appliquée à l’évaluation de l’impact des politiques publiques, cette logique invite à prouver qu’une intervention provoque un impact donné en montrant qu’en l’absence de cette intervention, toutes choses égales par ailleurs, cet impact ne se produit pas (Desplatz et Ferracci 2017). Toute la difficulté consiste alors à approximer du mieux possible ces situations « toutes choses égales par ailleurs » : que se serait-il passé en l’absence d’intervention, toutes les autres caractéristiques de la situation étant identiques ? C’est ce souhait de comparer des situations avec et sans intervention « toutes choses égales par ailleurs » qui a donné lieu au développement des méthodes expérimentales en évaluation (Campbell et Stanley 1963; Rossi, Lipsey, et Freeman 2004).

La plupart des expérimentations menées en évaluation des politiques publiques sont des expérimentations de terrain (field experiments), au sens où elles étudient l’intervention en situation, telles qu’elle se déploie effectivement. Les essais (ou expérimentations) contrôlés randomisés (ECR, souvent désignés par l’acronyme RCT correspondant à la désignation anglophone de randomised controlled trials) (Cf. Chapitre 1) comparent ainsi un groupe expérimental (recevant l’intervention) et un groupe témoin en visant une équivalence de caractéristiques entre les deux groupes grâce à l’assignation aléatoire des participant·e·s à l’un ou l’autre groupe. Ce type d’approche est particulièrement adapté aux interventions par ailleurs désignées sous le terme « d’expérimentations » dans l’action publique (Devaux-Spatarakis 2014), c’est-à-dire des interventions que les pouvoirs publics lancent dans un nombre restreint de territoires ou d’organisations (ce qui permet l’existence de groupes témoins) pour en tester les effets[6]. Lorsque ce type d’expérimentation directe n’est pas possible, les évaluatrices et évaluateurs peuvent avoir recours à plusieurs méthodes quasi-expérimentales, visant à reconstituer des groupes de comparaisons à partir de situations et de données déjà existantes (donc sans manipulation du réel de leur part, contrairement aux protocoles expérimentaux) (Fougère et Jacquemet 2019). La méthode des doubles différences (couramment appelée « diff-in-diff » pour difference-in-differences) utilise un marqueur temporel à partir duquel un des deux groupes étudiés reçoit l’intervention et l’autre non, et mesure l’impact de l’intervention en comparant les résultats avant et après ce moment (Cf Chapitre 2). La régression sur discontinuité (Cf. Chapitre 3), quant à elle, reconstitue un groupe cible et un groupe de contrôle en comparant les situations de part et d’autre d’un seuil d’éligibilité fixé par la politique étudiée (par exemple, éligibilité à l’intervention à partir de tel âge, de tel seuil de revenu, etc.). Enfin, l’appariement (Cf. Chapitre 4) consiste à comparer les situations de bénéficiaires d’une intervention à celle de non bénéficiaires aux caractéristiques les plus proches possibles.

Parallèlement à ces méthodes qui prennent appui sur des données en situation réelle, d’autres démarches d’étude d’impact quantitatives prennent appui sur des simulations informatiques ou des expériences en laboratoire. La microsimulation (Cf. Chapitre 5), dont le développement a été favorisé par l’amélioration de la puissance de calcul informatique, consiste à estimer ex ante l’impact attendu d’une intervention en prenant en considération une grande variété de données relatives aux individus cibles et en simulant des changements de situation (par exemple, vieillissement, évolution du marché de l’emploi, politiques fiscales, etc.). Elle permet également d’étudier finement ex post la diversité des effets de politiques publiques sur les individus concernés. Mais l’évaluation des politiques publiques peut aussi prendre appui sur des expérimentations en laboratoire (Cf. Chapitre 6), permettant de mesurer de façon précise le comportement des individus, et notamment de mettre au jour des biais non conscients. De telles analyses peuvent par exemple être précieuses pour aider à la conception des politiques antidiscriminatoires, dans une démarche d’évaluation ex ante. C’est aussi dans le contexte de la réflexion sur ces politiques qu’a été développée la méthode d’études par correspondance, ou testing (Cf. Chapitre 7), permettant de mesurer les discriminations par l’envoi de candidatures fictives en réponse à des offres réelles (par exemple des offres d’emploi). Mais l’évaluation cherche aussi à mesurer l’efficience des interventions, au-delà de leur impact. Ceci suppose de comparer les résultats obtenus au coût de la politique étudiée et à ceux de politiques alternatives, dans une démarche d’analyse coût – efficacité (Cf. Chapitre 8).

Méthodes qualitatives

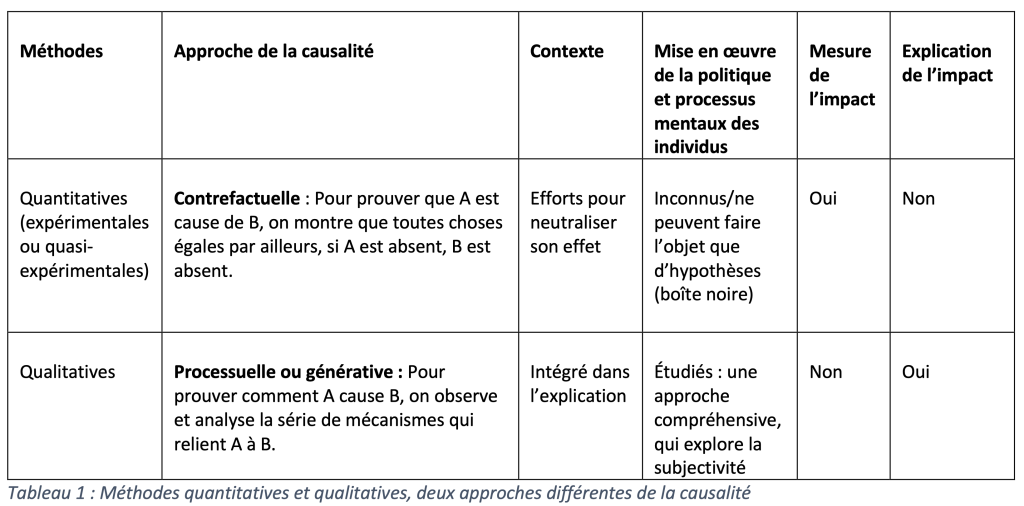

Si elles sont par ailleurs compatibles avec des approches contrefactuelles, les méthodes qualitatives, quant à elles, viennent alimenter de façon privilégiée une conception plus générative ou processuelle de la causalité (Lawrence B. Mohr 2021; Maxwell 2004; 2012; Mohr 1999). Selon cette logique, la causalité est inférée, non plus de relations entre des variables, mais de l’analyse des processus par lesquels la causalité opère. Alors que l’approche contrefactuelle permet d’établir si A cause B, l’approche processuelle montre comment (par quelle série de mécanismes) A cause B, par l’observation des manifestations empiriques de ces mécanismes causaux qui relient A et B. Ce faisant, elle dépasse la logique béhavioriste qui, dans les approches contrefactuelles, conçoit l’intervention selon une logique de stimulus-réponse, l’intervention en elle-même constituant alors une forme de boîte noire. À l’inverse, les approches plus qualitatives permettent de décomposer l’intervention en une série de processus qui contribuent à produire (ou à empêcher) le résultat escompté : c’est le principe général des évaluations basées sur la théorie dont la démarche, également compatible avec des méthodes quantitatives, est présentée dans la troisième partie de l’ouvrage (Cf. Chapitre 20). Cette analyse à une échelle plus fine est rendue possible par la focalisation sur un nombre limité de cas, qui sont alors étudiés de façon plus approfondie à partir de différentes techniques qualitatives. Une attention particulière est prêtée aux contextes, ainsi qu’aux processus mentaux et aux logiques d’action des personnes impliquées dans l’intervention (agent·e·s chargé·e·s de sa mise en œuvre, publics cibles), dans une démarche compréhensive (Revillard 2018). À la différence des méthodes quantitatives, les méthodes qualitatives ne permettent pas de mesurer l’impact d’une politique publique; elles peuvent en revanche l’expliquer (et expliquer ses variations selon les contextes), mais aussi répondre à d’autres questions évaluatives telles que celle de la pertinence des interventions. Le tableau 1 résume ces différences tendancielles entre méthodes quantitatives et qualitatives : il importe de préciser que nous mettons ici en évidence des affinités privilégiées de telle famille de méthodes avec telle approche de la causalité et telle prise en compte des processus et du contexte, mais il s’agit d’une distinction idéaltypique qui est loin d’épuiser les combinaisons possibles quant aux méthodes et conceptions de la recherche.

La technique d’enquête qualitative la plus emblématique est probablement l’observation directe ou ethnographie, héritière de l’anthropologie, qui consiste à observer directement sur le terrain la situation sociale que l’on cherche à étudier (Cf. Chapitre 9). Méthode particulièrement engageante, l’observation directe est très efficace pour mettre au jour tous ces processus intermédiaires de l’action publique qui contribuent à en produire les effets, ainsi que pour mettre à distance les discours officiels par l’observation directe des interactions. L’entretien semi-directif (Cf. Chapitre 10) est une autre technique d’enquête qualitative répandue, qui consiste en une interaction verbale sollicitée par le chercheur ou la chercheuse auprès d’un·e participant·e à la recherche, à partir d’une grille de questions utilisées de façon très souple. L’entretien vise à la fois la collecte d’information et la compréhension de l’expérience et de la vision du monde de la personne interviewée. Cette méthode peut également être déployée dans un cadre plus collectif, sous forme de focus groups (Cf. Chapitre 11) ou d’entretiens de groupe (Cf. Chapitre 12). Comme le souligne Ana Manzano dans son chapitre sur les focus groups, les terminologies pour désigner ces pratiques d’entretiens collectifs sont variables. Notre objectif en publiant deux chapitres sur ces questions n’est pas de rigidifier la distinction mais d’apporter deux regards complémentaires sur ces méthodes qui sont très fréquemment utilisées en évaluation.

Bien que pouvant mobiliser une diversité de méthodes qualitatives, quantitatives et mixtes, les études de cas (Cf. Chapitre 13) s’inscrivent classiquement dans une tradition de recherche qualitative du fait de leur filiation avec l’anthropologie. Elles permettent d’étudier les interventions dans leur contexte, et elles sont particulièrement adaptés à l’analyse des interventions complexes. Plusieurs études de cas peuvent être combinées dans l’évaluation d’une même politique; les modalités de leur sélection sont alors décisives. Prenant principalement mais non exclusivement appui sur des techniques d’enquête qualitatives, le traçage de processus (process tracing) (Cf. Chapitre 14) se concentre sur le déroulement de l’intervention dans un cas particulier, en cherchant à retracer comment certaines actions en ont entraîné d’autres. L’évaluatrice ou l’évaluateur se comporte alors comme un·e détective recherchant les « empreintes digitales » laissées par les mécanismes de changement. La démarche permet d’établir dans quelles conditions, comment et pourquoi une intervention fonctionne dans un cas particulier. Enfin, l’analyse historique comparée combine les deux outils méthodologiques fondamentaux des sciences sociales que sont la comparaison et l’histoire pour aider à expliquer les phénomènes sociaux à grande échelle (Cf. Chapitre 15). Elle est particulièrement utile pour rendre compte de la définition des politiques publiques.

Méthodes mixtes et approches transversales en évaluation

La troisième et dernière partie de l’ouvrage regroupe une série de chapitres portant sur l’articulation entre méthodes qualitatives et quantitatives ainsi que sur des approches transversales en évaluation (compatibles avec une diversité de méthodes). L’évaluation des politiques publiques a joué un rôle moteur dans la formalisation du recours aux méthodes mixtes, conduisant notamment à la distinction entre différentes stratégies d’articulation entre méthodes qualitatives et quantitatives (devis séquentiel exploratoire, séquentiel explicatif ou convergent) (Cf. Chapitre 16). Même lorsque l’enquête empirique ne mobilise qu’un type de méthode, elle gagne à prendre appui sur une revue de littérature systématique mixte. Alors que la pratique des revues systématiques de littérature s’est initialement développée pour synthétiser les apports des travaux menés par essais contrôlés randomisés, cette pratique s’est diversifié au fil des années pour inclure d’autres types de recherches (Hong et Pluye 2018). Les revues de littérature systématiques mixtes ont ainsi pour particularité d’intégrer des travaux à la fois quantitatifs, qualitatifs et mixtes, permettant de répondre à une plus grande diversité de questions évaluatives (Cf. Chapitre 17).

Une fois posé ce cadre général sur les méthodes et les revues mixtes, les chapitres suivants présentent six approches transversales. Les deux premières, les comparaisons de niveau macro et l’analyse qualitative comparée (ou QCA pour qualitative comparative analysis), sont plutôt issues des pratiques de recherche fondamentale, alors que les quatre autres (évaluation basée sur la théorie, évaluation réaliste, analyse de contribution, récolte d’incidences) sont issues du champ de l’évaluation. Les comparaisons de niveau macro (Cf. Chapitre 18) consistent à exploiter les variations et les similitudes entre de grandes entités d’analyse (par exemple, États ou régions) à des fins explicatives : par exemple, pour expliquer les différences entre de grands modèles de politique sociale, ou l’influence d’une configuration particulière de politique familiale sur le taux d’emploi des femmes. L’analyse qualitative comparée est une méthode mixte qui consiste à traduire des données qualitatives en un format numérique afin d’analyser systématiquement quelles configurations de facteurs produisent un résultat donné (Cf. Chapitre 19). Fondée sur une conception alternative de la causalité de type configurationnel, elle est notamment utile pour comprendre pourquoi une même politique peut entraîner certains changements dans certaines circonstances et non dans d’autres.

Développée en réponse aux limites des approches expérimentales et quasi-expérimentales ne permettant pas de saisir comment une intervention produit ses impacts, l’évaluation basée sur la théorie consiste à ouvrir la « boîte noire » de l’action publique en décomposant les différentes étapes de la chaîne causale liant l’intervention à ses résultats finaux (Cf. Chapitre 20). Les chapitres suivants relèvent globalement de cette famille d’approches en évaluation. L’évaluation réaliste (Cf. Chapitre 21) conçoit les politiques publiques comme des interventions qui produisent leurs effets par le biais de mécanismes qui ne se déclenchent que dans des contextes spécifiques. En mettant au jour des configurations contexte – mécanismes – effets, cette approche permet d’établir pour qui, comment et dans quelles circonstances une intervention fonctionne. Particulièrement adaptée aux interventions complexes, l’analyse de contribution (Cf. Chapitre 22) consiste à formuler progressivement des « hypothèses de contribution », dans un processus impliquant les parties prenantes de la politique, pour ensuite tester ces hypothèses de façon systématique à partir d’une diversité de méthodes. La récolte d’incidence (Cf. Chapitre 23), quant à elle, part d’une appréhension large des « incidences », soit des changements observables, pour ensuite retracer si et comment l’intervention a pu jouer un rôle dans leur production. Enfin, le dernier chapitre est consacré à une démarche innovante en évaluation, prenant appui sur le concept de sécurisation culturelle initialement développé dans les sciences infirmières (Cf. Chapitre 24). La sécurisation culturelle vise à faire en sorte que l’évaluation se déroule d’une façon dite sûre pour les parties prenantes et notamment les communautés minorisées cibles de l’intervention étudiée, c’est-à-dire que le processus d’évaluation évite de reproduire des mécanismes de domination (agression, déni d’identité…) liés à des inégalités structurelles. Pour cela, diverses techniques participatives sont mobilisées à toutes les étapes de l’évaluation. Ce chapitre est ainsi l’occasion d’insister sur l’importance des dynamiques participatives, également soulignée par plusieurs autres contributions.

Une présentation didactique et illustrée

Pour faciliter la lecture et la comparaison entre méthodes et approches, chaque chapitre est organisé selon un plan commun autour de cinq grandes questions :

1) En quoi consiste cette méthode/approche?

2) En quoi est-elle utile pour l’évaluation des politiques publiques?

3) Un exemple de mobilisation de cette méthode/approche;

4) Quels sont les critères permettant de juger de la qualité de la mobilisation de cette méthode/approche?

5) Quels sont les atouts et les limites de cette méthode/approche par rapport à d’autres?

L’ouvrage est directement publié en deux langues (français et anglais) afin de favoriser sa diffusion. Les contributions ont été initialement rédigées dans l’une ou l’autre langue selon la préférence des autrices et auteurs, puis traduites et révisées (lorsque possible) par celles-ci et ceux-ci. Un glossaire bilingue est disponible ci-après pour faciliter le passage d’une langue à l’autre.

Les exemples mobilisés relèvent d’une pluralité de domaines de politiques publiques, étudiés dans une diversité de contexte : retraites en Italie, information météorologique et climatique au Sénégal, salaire minimum dans le New Jersey, accueil dans les services publics en France, développement de l’enfant en Chine, lutte contre le tabagisme chez les jeunes au Royaume-Uni, financement de la santé au Burkina Faso, impact d’une école d’été sur la réussite scolaire aux États-Unis, formation aux compétences non techniques en Belgique, développement de la participation citoyenne pour améliorer les services publics en République Dominicaine, projet de nutrition au Bangladesh, couverture santé universelle dans six pays d’Afrique, etc. Les nombreux exemples présentés au fil des chapitres permettent ainsi d’illustrer la diversité et la vitalité actuelle des pratiques de recherche évaluative.

Loin de prétendre à l’exhaustivité, cette publication constitue une première synthèse de quelques méthodes parmi les plus utilisées. La collection a vocation à être enrichie par le biais de publications au fil de l’eau dans la collection en accès ouvert des fiches méthodologiques du LIEPP[7].

Bibliographie

Baïz, Adam, et Anne Revillard. 2022. Comment articuler les méthodes qualitatives et quantitatives pour évaluer l’impact des politiques publiques ? Paris: France Stratégie. https://www.strategie.gouv.fr/publications/articuler-methodes-qualitatives-quantitatives-evaluer-limpact-politiques-publiques.

Belaid, Loubna, et Valéry Ridde. 2020. « Une cartographie de quelques méthodes de revues systématiques ». Working Paper CEPED n°44.

Brisolara, Sharon. 1998. « The history of participatory evaluation and current debates in the field ». New Directions for Evaluation 1998 (80): 25‑41. https://doi.org/10.1002/ev.1115.

Burch, Patricia, et Carolyn J. Heinrich. 2016. Mixed Methods for Policy Research and Program Evaluation. Los Angeles: Sage.

Campbell, Donald T., et Julian C. Stanley. 1963. « Experimental and quasi-experimental designs for research ». In Handbook of research on teaching. Houghton Mifflin Company.

Cousins, J. Bradley, et Elizabeth Whitmore. 1998. « Framing participatory evaluation ». New Directions for Evaluation, no 80: 5‑23.

Cox, Gary B. 2021. « La malédiction de l’évaluation au sein des universités ». In Evaluation. Fondements, controverses, perspectives, par Delahais, Thomas, Devaux-Spatarakis, Agathe, Revillard, Anne, et Ridde, Valéry, 409‑15. Québec: Éditions science et bien commun. https://scienceetbiencommun.pressbooks.pub/evaluationanthologie/chapter/la-malediction-de-levaluation-au-sein-des-universites/.

Delahais, Thomas. 2022. « Le choix des approches évaluatives ». In L’évaluation en contexte de développement: Enjeux, approches et pratiques, par Linda Rey, Jean Serge Quesnel, et Vénétia Sauvain, 155‑80. Montréal: JFP/ENAP.

Delahais, Thomas, Devaux-Spatarakis, Agathe, Revillard, Anne, et Ridde, Valéry, éd. 2021. Evaluation: Fondements, controverses, perspectives. Québec: Éditions science et bien commun. https://scienceetbiencommun.pressbooks.pub/evaluationanthologie/.

Desplatz, Rozenn, et Marc Ferracci. 2017. Comment évaluer l’impact des politiques publiques ? Un guide à l’usage des décideurs et praticiens. Paris: France Stratégie.

Devaux-Spatarakis, Agathe. 2014. « L’expérimentation « telle qu’elle se fait » : leçons de trois expérimentations par assignation aléatoire ». Formation emploi, no 126: 17‑38.

Duran, Patrice, Christine Erhel, et Jérôme Gautié. 2018. « L’évaluation des politiques publiques ». Idées économiques et sociales 193 (3): 4‑5.

Duran, Patrice, Eric Monnier, et Andy Smith. 1995. « Evaluation à La Française: Towards a New Relationship between Social Science and Public Action ». Evaluation 1 (1): 45‑63. https://doi.org/10.1177/135638909500100104.

Fougère, Denis, et Nicolas Jacquemet. 2019. « Causal inference and impact evaluation ». Economie et Statistique, no 510-511‑512: 181‑200. https://doi.org/10.24187/ecostat.2019.510t.1996.

Greene, Jennifer C., Lehn Benjamin, et Leslie Goodyear. 2001. « The merits of mixing methods in evaluation ». Evaluation 7 (1): 25‑44.

Hong, Quan Nha, et Pierre Pluye. 2018. « Systematic reviews: A brief historical overview ». Education for information, no 34: 261‑76.

Jacob, Steve, Alkin, Marvin, et Christina Christie. 2012. « An Evaluation Theory Tree ». In Evaluation Roots, édité par Marvin Alkin et Christina Christie. London: Sage. https://doi.org/10.4135/9781412984157.n2.

Jacob, Steve. 2021. « L’hybridation disciplinaire, nouveau talisman de l’évaluation? » In Evaluation. Fondements, controverses, perspectives, par Delahais, Thomas, Devaux-Spatarakis, Agathe, Revillard, Anne, et Ridde, Valéry, 422‑41. Québec: Éditions science et bien commun. https://scienceetbiencommun.pressbooks.pub/evaluationanthologie/chapter/lhybridation-disciplinaire-nouveau-talisman-de-levaluation/.

Mathison, Sandra. 2005. Encyclopedia of evaluation. London: Sage.

Maxwell, Joseph A. 2004. « Using Qualitative Methods for Causal Explanation ». Field Methods 16 (3): 243‑64. https://doi.org/10.1177/1525822X04266831.

———. 2012. A Realist Approach for Qualitative Research. London: Sage.

Mayne, John. 2012. « Contribution analysis: Coming of age? » Evaluation 18 (3): 270‑80. https://doi.org/10.1177/1356389012451663.

Mertens, Donna M. 2017. Mixed Methods Design in Evaluation. Vol. 1. Evaluation in Practice Series. Thousand Oaks: SAGE Publications, Incorporated. https://doi.org/10.4135/9781506330631.

Mohr, Lawrence B. 1999. « The Qualitative Method of Impact Analysis ». American Journal of Evaluation 20 (1): 69‑84. https://doi.org/10.1177/109821409902000106.

———. 2021. « La méthode qualitative d’analyse d’impact ». In Evaluation. Fondements, controverses, perspectives, par Delahais, Thomas, Devaux-Spatarakis, Agathe, Revillard, Anne, et Ridde, Valéry, 500‑507. Québec: Éditions science et bien commun. https://scienceetbiencommun.pressbooks.pub/evaluationanthologie/chapter/la-methode-qualitative-danalyse-dimpact/.

Newcomer, Kathryn E., Harry P. Hatry, et Joseph S. Wholey. 2015. Handbook of Practical Program Evaluation. Hoboken: Wiley.

Patton, Michael Q. 1997. Utilization-focused evaluation. 3e éd. Thousand Oaks: Sage Publications.

———. 2015. Qualitative research and evaluation methods: integrating theory and practice. London: Sage.

———. 2018. Utilization-focused evaluation. London: Sage.

Pawson, Ray, et Nicholas Tilley. 1997. Realistic evaluation. London: Sage.

Revillard, Anne. 2018. Quelle place pour les méthodes qualitatives dans l’évaluation des politiques publiques ? Paris: LIEPP Working Paper n°81.

Ridde, Valéry, et Christian Dagenais. 2009. Approches et pratiques en évaluation de programme. Montréal: Presses de l’Université de Montréal.

———. 2020. Évaluation des interventions de santé mondiale : méthodes avancées. Québec: Éditions science et bien commun.

Rogers, Patricia J., et Carol H. Weiss. 2007. « Theory-Based Evaluation: Reflections Ten Years on: Theory-Based Evaluation: Past, Present, and Future ». New Directions for Evaluation 2007 (114): 63‑81. https://doi.org/10.1002/ev.225.

Rossi, Peter H., Mark W. Lipsey, et Howard E. Freeman. 2004. Evaluation: a systematic approach. London: Sage.

Scriven, Michael. 2021. « De quelques leçons durement acquises en évaluation de programme ». In Evaluation. Fondements, controverses, perspectives, par Delahais, Thomas, Devaux-Spatarakis, Agathe, Revillard, Anne, et Ridde, Valéry, 416‑21. Québec: Éditions science et bien commun. https://scienceetbiencommun.pressbooks.pub/evaluationanthologie/chapter/de-quelques-lecons-durement-acquises-en-evaluation-de-programme/.

Suchman, Edward A. 2021. « La recherche évaluative : principes et pratiques applicables aux services publics et aux programmes sociaux ». In Evaluation. Fondements, controverses, perspectives, par Delahais, Thomas, Devaux-Spatarakis, Agathe, Revillard, Anne, et Ridde, Valéry, 388‑95. Québec: Éditions science et bien commun. https://scienceetbiencommun.pressbooks.pub/evaluationanthologie/chapter/la-recherche-evaluative-principes-et-pratiques-applicables-aux-services-publics-et-aux-programmes-sociaux/.

Wanzer, Dana. 2021. « Qu’est-ce que l’évaluation? En quoi diffère-t-elle (ou non) de la recherche? » In Evaluation. Fondements, controverses, perspectives, par Delahais, Thomas, Devaux-Spatarakis, Agathe, Revillard, Anne, et Ridde, Valéry, 442‑47. Québec: Éditions science et bien commun. https://scienceetbiencommun.pressbooks.pub/evaluationanthologie/chapter/quest-ce-que-levaluation-en-quoi-differe-t-elle-ou-non-de-la-recherche/.

Wasmer, Etienne, et Christine Musselin. 2013. Évaluation des politiques publiques : faut-il de l’interdisciplinarité? Paris: LIEPP Methodological discussion paper n°2.

Weiss, Carol H. 1997. « Theory-Based Evaluation: Past, Present, and Future ». New Directions for Evaluation 1997 (76): 41‑55. https://doi.org/10.1002/ev.1086.

———. 1998. Evaluation: Methods for Studying Programs and Policies. Upper Saddle River, NJ: Prentice-Hall.

Wilson-Grau, Ricardo. 2018. Outcome Harvesting: Principles, Steps, and Evaluation Applications. IAP.

Woodward, James. 2003. Making things happen a theory of causal explanation. Oxford studies in philosophy of science. New York: Oxford University Press.

- Citons par exemple la définition proposée par Michaël Patton, caractérisant l’évaluation comme « la collecte systématique d’informations sur les activités, caractéristiques et effets des programmes, dans le but de développer des jugements sur ceux-ci, d’améliorer leur efficacité, et d’informer les décisions futures relatives à ce programme » (“the systematic collection of information about the activities, characteristics, and outcomes of programs to make judgements about the program, improve program effectiveness, and/or inform decisions about future programming”) (Patton 1997, 23). ↵

- Par distinction avec les méthodes au sens d'outils méthodologiques, les approches se situent dans « une sorte d'entre-deux entre la théorie et la pratique » (Delahais 2022), en incarnant certains paradigmes. En évaluation, certaines peuvent être très orientées sur la dimension méthodologique, mais d'autres plus concernées par les valeurs, par l'utilisation des résultats, ou encore par la justice sociale (ibid.). ↵

- Le programme ainsi que des ressources issues des séances précédentes de ce séminaire sont disponibles en ligne : https://www.sciencespo.fr/liepp/fr/content/cycle-de-seminaires-methodes-et-approches-en-evaluation-metheval.html ↵

- Ce faisant, il vient compléter d'autres ressources méthodologiques disponibles sous forme d'ouvrages (Ridde et Dagenais 2009; Ridde et al. 2020; Newcomer, Hatry, et Wholey 2015; Mathison 2005; Weiss 1998; Patton 2015), ou encore en ligne : citons par exemple le Methods excellence network (https://www.methodsnet.org/), ou encore en évaluation, les ressources compilées par l’OCDE (https://www.oecd.org/fr/cad/evaluation/keydocuments.htm), le réseau Evalpartners de l’ONU (https://evalpartners.org/), ou encore en France les guides méthodologiques de l'Institut des politiques publiques (https://www.ipp.eu/publications/guides-methodologiques-ipp/) et de la Société coopérative et participative (SCOP) Quadrant Conseil (https://www.quadrant-conseil.fr/ressources/evaluation-impact.php#/). ↵

- L'évaluation s'interroge aussi, par exemple, sur la pertinence, la cohérence, l'efficacité, l'efficience ou encore la soutenabilité des interventions. Voir OECD DAC Network on Development Evaluation (EvalNet) https://www.oecd.org/dac/evaluation/daccriteriaforevaluatingdevelopmentassistance.htm ↵

- Ces initiatives des pouvoirs publics sont malheureusement loin de faire systématiquement l'objet d'évaluations rigoureuses. ↵

- Fiches méthodologiques LIEPP : https://www.sciencespo.fr/liepp/fr/publications.html#Fiches%20m%C3%A9thodologiques%20LIEPP ↵