I. À quoi sert l’évaluation?

4. Repenser l’utilisation de l’évaluation. Une théorie intégrée de l’influence

Karen E. Kirkhart

[Traduit de : Kirkhart, Karen E. 2000. « Reconceptualizing evaluation use: An integrated theory of influence ». New Directions for Evaluation, 2000(88) : 5–23 (Extraits). Traduction par Carine Gazier et Agathe Devaux-Spatarakis; traduction et reproduction du texte avec l’autorisation de John Wiley and Sons.]

Une théorie intégrée de l’influence

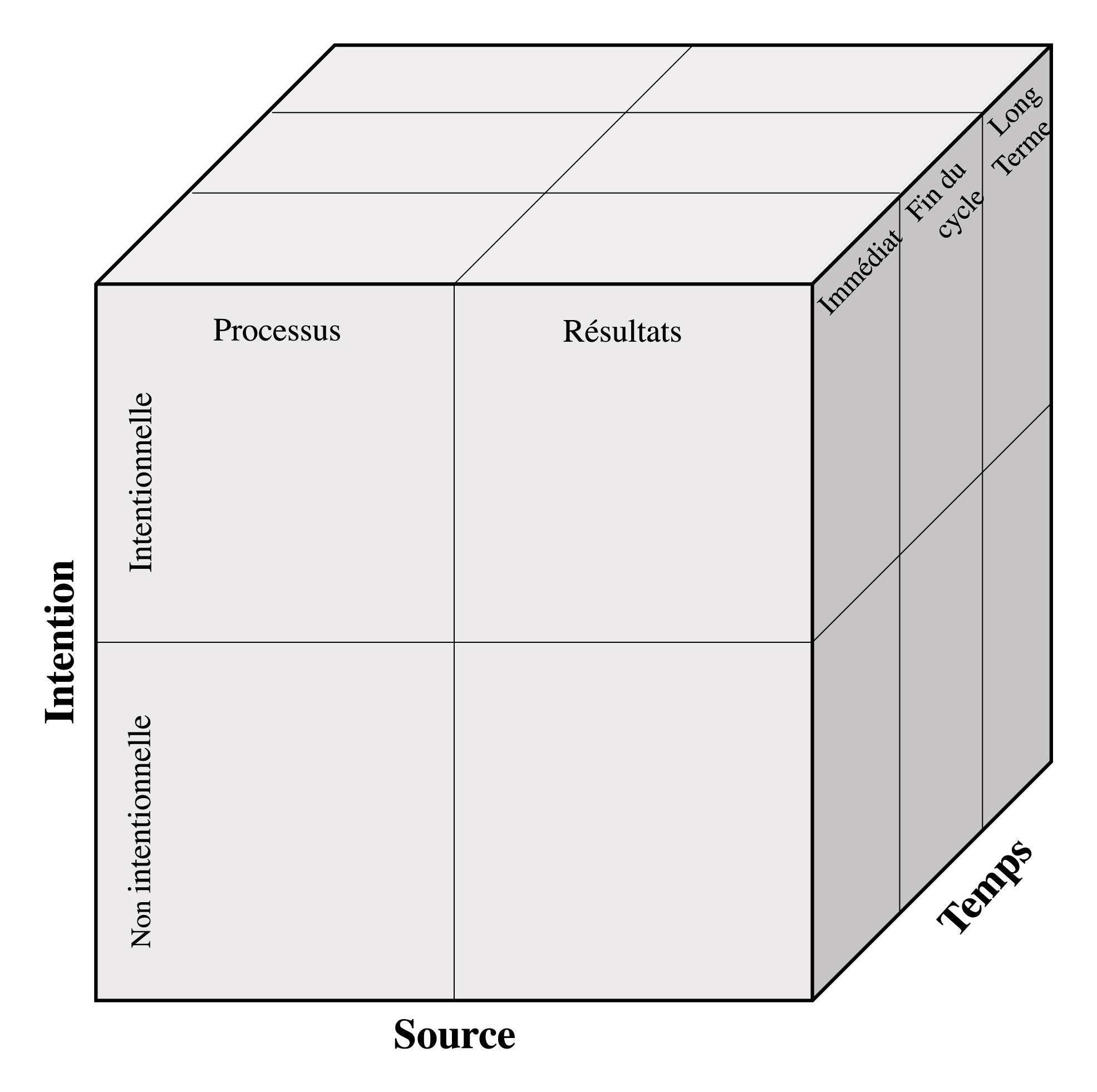

Une théorie intégrée de l’influence comprend trois dimensions : la source d’influence, l’intention et le temps. Chaque dimension est subdivisée en niveaux (voir Figure 1). Ces subdivisions sont certes quelque peu arbitraires. La source, l’intention et le temps peuvent être caractérisés de façon plus précise comme un continuum, reflétant les zones grises qui se situent entre les niveaux.

La source d’influence désigne l’agent actif du changement ou le point de départ d’un processus générant du changement (Henry et Rog, 1998). La source d’influence se distingue en deux niveaux, les influences associées au processus d’évaluation et des influences associées aux résultats de l’évaluation. L’intention se rapporte à la mesure dans laquelle il existe une orientation intentionnelle visant à exercer un type particulier d’influence dans le cadre du processus d’évaluation ou des résultats d’évaluation. Elle reflète l’importance de tenir compte à la fois de l’influence escomptée et non intentionnelle de l’évaluation. La division de la troisième dimension, celle du temps, en influence immédiate, en fin de cycle et à long terme reflète la nécessité de reconnaître l’influence pendant et immédiatement après le cycle d’évaluation ainsi que les effets visibles à l’avenir. Ces trois dimensions et leurs antécédents historiques sont résumés dans les sections suivantes.

Figure 1 : Théorie intégrée de l’influence

Source d’influence

La première dimension porte sur la dimension de l’évaluation qui est présumée exercer un pouvoir ou une influence sur des individus, des organisations ou des collectivités décisionnelles plus larges. Historiquement, l’influence de l’évaluation était définie en fonction de l’utilisation des résultats (Johnson, 1998; Shulha et Cousins, 1997). Il y avait une littérature parallèle qui s’intéressait à l’influence interpersonnelle du processus d’évaluation, mais ces deux volets n’étaient pas réunis avant la « découverte » de l’utilisation du processus (Patton, 1998). L’utilisation du processus d’évaluation est apparue d’abord comme un moyen de faciliter l’utilisation axée sur les résultats, puis a été considérée comme une source d’influence en soi. Toutefois, les vestiges de cette évolution subsistent, sont reflétés dans le langage d’utilisation, et créent des confusions conceptuelles. L’utilisation du processus est souvent liée à tort à la typologie reconnue de l’utilisation axée sur les résultats plutôt que d’être considérée comme une autre typologie à part entière. Le passage de l’utilisation à l’influence crée un cadre pour un traitement parallèle des deux dimensions, reflété dans ce modèle.

L’influence basée sur les résultats. L’attention accordée dès le début à l’utilisation de l’évaluation découlait d’un désir de maximiser l’impact social positif de l’évaluation, en lien avec des préoccupations quant à la non-utilisation des résultats de l’évaluation (Ciarlo, 1981). Que la question soit examinée du point de vue des acteurs et actrices impliqué-e-s dans l’élaboration des politiques publiques (Cronbach, 1982; Cronbach et al., 1980), des utilisateurs et utilisatrices individuel-le-s, des décisions prises, de l’organisation à évaluer ou des rapports publiés (Weiss 1981), les points de référence pour juger de l’utilisation de l’évaluation étaient l’information produite par l’évaluation et les conclusions fondées sur des données. Dans leur synthèse des travaux empiriques sur l’utilisation de l’évaluation, Cousins et Leithwood (1986) définissent les résultats de l’évaluation comme « toute information liée aux résultats de l’évaluation; par exemple, données, interprétations, recommandations; ces informations pourraient être communiquées à l’issue de l’évaluation ou au fur et à mesure que celle-ci se poursuit » (p. 332). Bien que cette définition distingue clairement des utilisations formative ou sommative, les premiers travaux empiriques se sont concentrés sur l’utilisation sommative. L’utilisation basée sur les résultats a d’abord été considérée sous l’angle de l’utilisation instrumentale, c’est-à-dire à partir des mesures directes et visibles adoptées sur la base des résultats de l’évaluation (Rich, 1977). Cette conceptualisation étroite s’est rapidement élargie pour inclure les utilisations conceptuelles des résultats, comme l’apport d’un éclairage nouveau (illumination) et la démystification. A ainsi été intégré un impact cognitif sur les appréciations ou les compréhensions qui ne se traduisait pas nécessairement par un changement de comportement manifeste (Rich, 1977; Weiss et Bucuvalas, 1980). Un troisième type d’utilisation, axée sur les résultats, a porté sur le rôle des conclusions de l’évaluation dans le plaidoyer, l’argumentation et le débat politique (Greene, 1988a; Knorr, 1977; Leviton et Hughes, 1981; McClintock et Colosi, 1998; Johnson, 1998; Shadish, Cook, et Leviton, 1991). Que ce soit l’utilisation légitimatrice, l’usage symbolique, l’usage politique ou l’usage persuasif, cette application se concentrait explicitement sur l’utilisation de l’information évaluative pour convaincre les autres de promouvoir une position ou de défendre contre des attaques une option déjà adoptée. Ensemble, ces trois vecteurs d’utilisation ont délimité le paysage conceptuel de l’influence fondée sur les résultats.

L’influence basée sur le processus. L’influence de l’évaluation ne découle pas entièrement de la présentation formative ou sommative des résultats. Parfois, l’influence principale se joue dans le processus de réalisation de l’évaluation en tant que tel. Bien que le terme « processus » n’ait pas été utilisé dans la littérature sur l’évaluation avant la fin des années 1980, l’attention portée à l’impact du processus d’évaluation peut être identifiée dès les premiers travaux portant sur les rôles d’agent-e de changement de l’évaluateur ou de l’évaluatrice, dans la recherche-action et dans des approches telles que l’évaluation transactionnelle, qui ont mis l’accent sur les interactions entre les évaluateurs/-trices et des systèmes ouverts (Anderson et Ball, 1978; Argyris, Putnam, et Smith, 1985; Caro, 1980; Rippey, 1973; Rodman et Kolodny, 1972; Tornatzky, 1979). Les racines et l’évolution de l’influence basée sur le processus sont particulièrement visibles dans l’histoire des approches d’évaluations participatives (Brisolara, 1998).

L’utilisation qui découle du processus a d’abord été théorisée, dans la littérature sur l’utilisation, comme un moyen de faciliter l’utilisation basée sur les résultats. L’objectif de Greene (Greene, 1988b) par exemple, était de créer des conditions propices à une utilisation basée sur les résultats plutôt que sur les effets intrinsèques du processus d’évaluation lui-même. Par la suite, les réflexions sur l’utilisation qui découle du processus ont mis l’accent sur sa valeur indépendamment de l’utilisation basée sur les résultats (Whitmore, 1991). Patton (1997) la décrit comme « des façons par lesquelles la participation au processus d’évaluation peut être utile indépendamment des résultats qui peuvent découler de ces processus » (p. 88, mention en italique de l’autrice).

Greene (1988b) distingue trois dimensions de l’influence basée sur le processus : cognitive, affective et politique. La dimension cognitive fait référence à des changements dans la compréhension des choses, stimulés par la discussion, la réflexion et l’analyse des problèmes enchâssées dans le processus d’évaluation. Bien que l’utilisation dérivée du processus puisse comporter une composante instrumentale (comme lorsque la réflexion mène à une décision ou à une action), la dimension cognitive met l’accent sur une meilleure compréhension de la politique publique parmi les participant-e-s au processus d’évaluation. La dimension affective est plus personnellement liée aux participant-e-s eux-mêmes. Cette dimension porte sur les sentiments individuels et collectifs de valeur qui découlent du processus d’évaluation. Bien que les interprétations de Greene (1988b) identifient des sentiments relatifs à l’estime de soi, d’autres mécanismes psychologiques sont également possibles (par exemple, les sentiments à l’égard de l’évaluation, les sentiments à l’égard du programme lui-même). La dimension politique porte sur l’utilisation du processus d’évaluation lui-même pour générer de nouvelles discussions, attirer l’attention sur des problèmes sociaux ou influencer la dynamique du pouvoir et des privilèges inhérents à l’évaluation et à son contexte. Les modèles récents qui définissent l’évaluation comme une intervention visant explicitement à modifier la mise en œuvre ou à rendre compte des résultats d’une politique publique soulignent l’importance de la dimension politique de l’influence qui découle du processus (Fetterman, 1994; Patton, 1998). Ces trois types d’influence basée sur le processus peuvent opérer ensemble. La discussion de Shulha (dans ce volume[1]) sur ce que les évaluateurs et évaluatrices eux/elles-mêmes ont appris en participant au travail d’évaluation qu’elle comporte des aspects cognitifs, affectifs et politiques.

Résumé. La première dimension d’une théorie intégrée de l’influence, c’est-à-dire la source d’influence, s’intéresse à l’élément de l’évaluation qui est présumé générer des changements. Au sens large, les deux sources d’influence sont le processus d’évaluation et les résultats qui sont générés par l’évaluation. Des démarches d’évaluation particulières peuvent très bien recouvrir les deux types d’influence; toutefois, de nombreuses démarches accordent une importance différente aux deux sources d’influence, et certaines se concentrent presque exclusivement sur une seule source. Bien que les typologies d’utilisation se soient développées pour chaque source d’influence, ces distinctions ne devraient pas éclipser les liens entre l’influence basée sur le processus et l’influence basée sur les résultats. Non seulement les deux types d’influence peuvent être combinés dans un modèle logique unique (voir, par exemple, Greene, 1988b), mais les sous-catégories de chaque source d’influence peuvent être interdépendantes. Anderson, Ciarlo et Brodie (1981), par exemple, discutent des dimensions affectives de l’utilisation basée sur les résultats, tandis que Greene (1988b) fait allusion à l’impact instrumental de l’utilisation du processus. Dans ce volume, la structure de l’argument de Henry illustre un lien implicite entre l’utilisation basée sur les résultats et l’utilisation basée sur le processus. L’objet principal de son chapitre est l’influence basée sur les résultats, mais il est intéressant de noter que selon lui seule une utilisation dérivée du processus de l’évaluation peut amener à la mise à l’agenda de nouveaux problèmes publics.

L’intention

L’intention est la deuxième dimension d’une théorie intégrée de l’influence de l’évaluation (Kirkhart, 1999). Elle désigne dans quelle mesure l’influence de l’évaluation est intentionnellement dirigée, reconnue consciemment et planifiée. Les plus visibles sont les influences prévues qui sont explicites dans le but de l’évaluation, dans la théorie utilisée et dans le contrat évaluateur-commanditaire. Les objectifs latents et les agendas d’évaluation cachés peuvent aussi relever de l’intention, mais ces intentions peuvent être plus difficiles à cerner. Les influences imprévues s’intéressent aux répercussions non intentionnelles de l’évaluation sur les individus et les systèmes, souvent par des voies inattendues. Une évaluation donnée peut n’avoir qu’une influence intentionnelle, une influence non intentionnelle ou un mélange des deux. La cartographie des influences tant prévues qu’inattendues est essentielle à l’appréciation complète de l’impact de l’évaluation.

L’intention d’influencer (diversement appelée intention et intentionnalité) a joué un rôle important dans la conceptualisation de l’utilisation de l’évaluation. C’est l’une des premières dimensions identifiées dans l’élaboration d’une théorie intégrée de l’influence (Kirkhart, 1995). Selon d’autres théories d’utilisation, elle marque la frontière entre l’utilisation et les mésusages (misuse) de l’évaluation (Alkin, 1990; Alkin, Daillak, et White, 1979; Christie et Alkin, 1999). La question qui définit cette deuxième dimension de l’influence est : Quelles sont les intentions de l’équipe d’évaluation, du/de la commanditaire et d’autres intervenant-e-s clés concernant l’influence de l’évaluation? L’intention peut être encore décomposée en trois aspects : le type d’influence souhaité ou prévu; qui doit être influencé; ainsi que les personnes, le processus et les résultats qui sont censés exercer une influence. Bien que les deux premiers soient souvent confondus, une réflexion distinguant les deux facilite l’identification des influences involontaires.

L’influence intentionnelle. L’évaluation peut avoir pour but d’exercer une influence soit par le processus lui-même, soit par les résultats obtenus. La notion « d’utilisation primaire » de Patton (1997), utilisation escomptée par les utilisateurs ciblés, marque un chemin direct entre l’intention et l’influence. Historiquement, le scénario le plus souvent envisagé est basé sur l’utilisation des résultats. Les utilisateurs et utilisatrices potentiel-le-s des connaissances produites par l’évaluation sont identifié-e-s dès le début du processus d’évaluation, et leurs besoins de connaissance déterminent l’évaluation, depuis les questions posées jusqu’aux données recueillies et à la façon dont les résultats sont communiqués. Toutefois, il peut y avoir une intention tout aussi explicite d’influencer les organisations et les systèmes sociaux par le biais du processus d’évaluation lui-même, comme l’illustre l’évaluation participative. Cousins et Whitmore (1998) distinguent deux courants d’influence basés sur le processus dans l’évaluation participative, chacun ayant sa propre idéologie et sa propre intention. Dans le cadre de l’évaluation participative transformatrice, l’objectif est l’autonomisation, l’action sociale et le changement, tandis que l’évaluation participative pratique vise à aider à la résolution de problèmes au niveau des programmes ou de l’organisation. De même, Patton (1998) décrit « l’évaluation comme une intervention intentionnelle en vue d’améliorer les résultats du programme » (p. 229), qui est une sorte d’utilisation de processus, conceptualisant la réactivité naturelle du processus de collecte de données comme une intervention qui renforce ce que le programme essaie de faire.

Une mise en garde importante concernant l’influence visée est que toutes les intentions ne sont pas explicitement communiquées ou rendues visibles. Les objectifs déclarés d’une évaluation correspondent à ses fonctions manifestes, évidentes; par exemple, une évaluation formative peut être entreprise dans le but d’améliorer l’intervention publique, tandis qu’une évaluation sommative peut être entreprise pour aider un promoteur à mieux réaffecter les fonds. Toutefois, les influences prévues pourraient aussi inclure des fonctions cachées et latentes (Scriven, 1991). Par exemple, une évaluation ayant pour fonction manifeste d’améliorer l’efficacité du programme pourrait aussi avoir pour fonction latente d’accroître la visibilité du programme auprès de la collectivité. Une évaluation ayant manifestement pour fonction de démontrer la responsabilité et l’efficacité des commanditaires pourrait entraîner une réaffectation des fonds et une réduction des effectifs en tant qu’objectifs latents. Pour saisir toute la gamme d’influences prévues, il faut prêter attention aux fonctions manifestes et latentes. Ici, la pluralité des utilisations prévues et des utilisateurs et utilisatrices devient critique. Il faut tenir compte de la compréhension et des agendas des commanditaires de l’évaluation, des évaluateurs/-trices et des parties prenantes.

L’influence non intentionnelle. L’évaluation peut influencer les programmes et les systèmes d’une manière non intentionnelle, par des voies imprévues. L’attention portée à l’influence involontaire de l’évaluation reconnaît à la fois le pouvoir des effets d’entraînement et notre incapacité à anticiper toutes les ramifications de notre travail. Dans le cadre de l’évaluation, comme dans les programmes eux-mêmes, l’influence non intentionnelle peut avoir plus d’impact que l’influence prévue. En outre, le territoire défini par une influence involontaire est plus large. Alors que l’utilisation primaire attire plutôt l’attention sur les utilisations prévues et les utilisateurs, l’influence involontaire prend la forme d’une série de permutations.

Trois variantes illustrent ce point. Premièrement, les utilisateurs et utilisatrices ciblé-e-s peuvent exercer une influence de manière non intentionnelle ou affecter des personnes ou des systèmes autres que ceux prévus. Prenons un exemple d’utilisation basé sur les résultats. Un groupe consultatif est l’un des utilisateurs ciblés par les conclusions de l’évaluation. Bien que l’utilisation attendue de leur part consistât à apporter des changements internes au programme, les données ont eu des répercussions inattendues sur le personnel politique qui a formé une coalition communautaire pour plaider en faveur d’un changement législatif. Cette influence plus large n’était pas intentionnelle, bien qu’elle ait été initiée par les utilisateurs et utilisatrices ciblé-e-s. Deuxièmement, des utilisateurs et utilisatrices non prévu-e-s peuvent être impliqué-e-s dans l’exercice de l’influence, bien que la nature de l’influence et que d’autres personnes et systèmes concernés soient ciblés. Prenons un exemple de processus dans lequel une évaluation des besoins est effectuée sur le problème de la violence dans les écoles publiques. L’intention était de faire participer les parents et les enseignant-e-s avec les membres des conseils d’écoles à l’identification des préoccupations et à la formulation de solutions en vue d’un environnement scolaire sécurisé; toutefois, les élèves ont affirmé leur intérêt pour l’évaluation, et leur participation à l’évaluation des besoins a modifié le climat de l’école. L’influence va dans le sens intentionnel (vers la sécurité) et sur le système prévu, mais elle est passée par un chemin d’utilisation non prévu. Troisièmement, les utilisateurs et utilisatrices, la nature de l’influence et les systèmes influencés peuvent tous être involontaires. Prenons par exemple l’évaluation interne d’un organisme local d’accompagnement des publics visant à appuyer une demande de prolongation du financement par l’organisation communautaire qui le soutient. Au fil de l’évaluation, les bénéficiaires ont joué un rôle inattendu dans le processus, ce qui a suscité une publicité positive involontaire pour l’organisme. Le processus d’évaluation inclusive a été cité comme modèle, et un groupe de défense des bénéficiaires à l’échelle de l’État a mis les promoteurs publics au défi de repenser les paramètres de l’évaluation dont ils avaient besoin pour obtenir un financement. Il est à noter que cette influence non intentionnelle peut s’ajouter à l’utilisation prévue des données pour appuyer la pérennité du financement.

Résumé. L’intention est la deuxième dimension clé d’une théorie intégrée de l’influence exercée par l’évaluation. Les influences prévues peuvent être basées sur les résultats ou sur le processus, manifeste ou latent. Les influences non intentionnelles peuvent aussi être liées au processus ou aux résultats; cependant, la nature de l’influence, les personnes ou les systèmes influencés et les personnes qui exercent l’influence sont autres que celles escomptées ou prévues. Les influences intentionnelles et non intentionnelles peuvent se produire individuellement ou se combiner et, comme l’indiquent les exemples cités précédemment, elles peuvent s’exercer à différents moments. Bien que les exemples présentés illustrent des influences positives, l’intention ne présage pas de la valeur positive de l’influence. De toute évidence, l’évaluation peut avoir des influences négatives involontaires sur les personnes ou les systèmes; certaines des influences prévues peuvent aussi avoir des répercussions négatives sur certaines parties du système. Prises ensemble, les trois dimensions de l’influence offrent un cadre permettant d’examiner à la fois les effets positifs et négatifs de l’évaluation.

Le temps

La troisième dimension, le temps, se rapporte à la chronologie cours de laquelle l’influence de l’évaluation apparaît, existe, ou se poursuit. Cette dimension met en évidence la nature dynamique de l’influence et la possibilité que différentes dimensions de l’influence se produisent à différents moments, dans l’immédiat, à la fin du cycle de l’évaluation et à long terme. Étant donné que le temps est un continuum, cette subdivision en trois périodes est arbitraire, mais les catégories attirent l’attention sur l’influence à trois étapes différentes qui vont de pair avec l’opinion selon laquelle les résultats du programme sont immédiats, apparaissent à la fin de l’intervention ou à long terme (Scriven, 1991). Tout comme ces distinctions ont été utiles pour orienter l’attention des évaluateurs sur les résultats du programme, une convention semblable peut guider la conceptualisation de l’influence de l’évaluation.

Comme les deux dimensions précédentes, il y a des antécédents au traitement actuel du temps dans la littérature sur l’évaluation. Shadish, Cook et Leviton (1991) décrivent l’historique de l’utilisation comme étant passé d’une utilisation à court terme à la reconnaissance de l’utilisation à long terme. Cette dichotomie a été couramment utilisée pour décrire la dimension temporelle. Parmi les six dimensions clés qu’elle identifie pour conceptualiser l’utilisation de l’évaluation, Weiss (1981) inclut : « Dans quelle mesure l’utilisation est-elle immédiate? » (en opposant l’utilisation immédiate et l’utilisation à long terme) était l’une des six dimensions clés de la conceptualisation de l’utilisation. De même, Smith (1988) mentionne l’utilisation immédiate ou à long terme comme l’une des quatre dimensions caractérisant l’utilisation, bien que son analogie comparant l’utilisation de l’évaluation à l’emprunt de livres dans une bibliothèque repose exclusivement sur l’utilisation axée sur les résultats. Tou-te-s les auteurs et autrices n’ont pas traité le temps comme une dichotomie entre le court terme et le long terme. Wollenberg (1986, cité dans Johnson, 1998), dans une étude sur l’utilisation qui s’étendait sur une année scolaire complète, a conceptualisé la dimension temporelle selon trois périodes ou cycles caractérisant la mise en œuvre ou le développement du programme – stade conceptuel, stade de développement et stade institutionnel. Cronbach (1982) a décrit quatre périodes d’influence, faisant remarquer : « Une évaluation alimente la pensée sociale telle qu’elle est planifiée, puisqu’elle apporte des données, au moment où elle touche à sa fin, et, on peut l’espérer, pendant plusieurs années par la suite » (p. 318).

Historiquement, les trois dimensions d’une théorie intégrée de l’influence – la source, l’intention et le temps – sont liées. La dimension temporelle a été attachée à d’autres distinctions d’utilisation d’une manière qui a brouillé toute la gamme d’influences chronologiques. La recension de Leviton et Hughes (1981) illustre comment la dimension temporelle a souvent été intégrée dans les premières discussions sur l’utilisation instrumentale par rapport à l’utilisation conceptuelle basée sur les résultats. Ils citent Rein et White (1975) pour marquer la reconnaissance précoce du fait que « les problèmes du gouvernement sont définis graduellement au fil du temps et que les décisions sont finalement prises sur la base d’un ensemble intégré d’information provenant de nombreuses sources » (Leviton et Hughes, 1981 : 531). Le fait que cette citation soit mobilisée pour illustrer l’utilisation instrumentale par rapport à l’utilisation conceptuelle témoigne de la confusion historique des dimensions – en l’occurrence, le temps avec la source. De même, dans leur recension des théories d’utilisation des principaux théoriciens de l’évaluation, Shadish, Cook et Leviton (1991) se réfèrent à maintes reprises à l’utilisation instrumentale à court terme et à l’utilisation conceptuelle à long terme. Bien qu’il s’agisse là de combinaisons claires et peut-être communes d’utilisation dans un cadre d’utilisation basée sur les résultats, la dimension temporelle devrait être examinée séparément de la nature de l’influence pour une clarté maximale.

Un point clé qui est pertinent pour la conceptualisation de la dimension temporelle est de savoir si l’utilisation est considérée comme un événement ponctuel ou comme un processus plus ouvert. Les premières définitions ont parlé de l’utilisation comme d’un événement. Par exemple, Alkin, Daillak et White (1979) ont demandé : « Comment savoir identifier une utilisation? » et « Comment définissons-nous une utilisation? » (p. 226)? Leur modèle d’utilisation a culminé dans la description de « cas d’utilisations » (p. 232). Leviton et Hughes (1981) ont utilisé ce même langage, en se demandant : « Qu’est-ce qu’un cas d’utilisation? » (p. 533), le cas correspondant à l’unité d’analyse dans leur méthode d’étude de l’utilisation. Ailleurs, une évolution se faisait jour, d’une conception de l’utilisation comme un événement distinct à son appréhension comme un processus ouvert. En remplaçant le terme utilisation par usages, Weiss (1981) a souligné la nécessité de s’éloigner d’une conception de l’utilisation comme événement, notant que l’utilisation de l’évaluation différait de celle d’un marteau. Cronbach (1982) considère l’utilisation comme un processus, et non comme un moment dans le temps. Selon lui, les évaluations « font partie de l’accumulation continue des connaissances sociales » (p. 318). Heureusement, distinguer des périodes temporelles n’impose pas de considérer l’utilisation comme événement, pas plus qu’elle n’exige de trancher le débat entre l’utilisation comme moment distinct ou comme processus. La dimension temporelle attire l’attention sur toute influence visible au cours d’une période donnée, qu’il s’agisse d’un événement qui ne se produise qu’au cours de cette période ou d’un processus qui la dépasse.

L’influence immédiate. L’influence immédiate désigne l’influence qui se produit ou qui est visible en même temps que le processus d’évaluation. Une influence immédiate peut survenir au cours du processus d’anticipation, de planification et de mise en œuvre de l’évaluation. Elle comprend les influences précoces qui sèment les graines d’effets à long terme ou qui peuvent avoir un impact cumulatif au fil du temps, ainsi que les effets à court terme qui peuvent ne pas avoir de ramifications à long terme. Bien que ce soient les promoteurs et promotrices de démarches participatives, collaboratives et d’autonomisation qui ont, chacun-e à sa manière, attiré notre attention sur cette question, l’influence immédiate n’est pas liée exclusivement à ces démarches.

Il suffit de voir, par exemple, l’influence de l’accréditation existante sur les préparatifs et le déroulement d’une visite d’évaluation sur site, avant même qu’une décision ait été prise quant à son renouvellement. Dans un premier temps, l’influence immédiate peut être considérée comme exclusivement fondée sur le processus; toutefois, une réflexion approfondie sur la diversité des données qui constituent des résultats donne à penser que l’utilisation basée sur les résultats peut également se produire en même temps que le processus d’évaluation. L’étude d’évaluabilité, par exemple, indique clairement l’ordre du jour de la préparation des systèmes à évaluer (Wholey, 1994). Les ajustements apportés par un système en réponse aux données sur l’évaluabilité au cours du processus d’évaluation représentent une influence immédiate, intentionnelle et basée sur les résultats.

Deux clarifications s’imposent ici. Premièrement, l’influence immédiate ne se produit pas nécessairement sur un temps réduit. Étant donné qu’elle est liée au calendrier de l’évaluation, une mission d’évaluation qui s’étend sur une période de plusieurs mois ou même plusieurs années pourrait avoir une période prolongée au cours de laquelle l’influence immédiate pourrait être examinée. Deuxièmement, la caractérisation d’immédiate ne correspond pas à la durée de l’influence. On peut avoir une influence immédiate de courte durée ou une influence qui se prolongerait au-delà du cycle d’évaluation et qui demeurait visible au cours de périodes ultérieures.

L’influence en fin de cycle. La notion d’influence de fin de cycle met l’accent sur l’influence environnant la conclusion d’une étude d’évaluation sommative ou d’un cycle dans une évaluation plus formative. Elle comprend l’influence qui émane à la fois des produits de l’évaluation (par exemple, rapports, résumés et autres documents) et du processus de diffusion des résultats. Elle comprend également le processus qui met fin à un cycle d’évaluation particulier en l’absence d’un rapport écrit officiel et dans le contexte d’une utilisation plus poussée (Patton, 1994, 1997). L’influence de fin de cycle est parallèle à la notion d’effets de fin d’intervention dans l’évaluation des résultats, en attirant l’attention sur la conclusion d’une étude d’évaluation ou d’un cycle donné dans le cadre d’un effort d’évaluation continu. Ces démarcations cycliques peuvent représenter des phases de développement de l’évaluation elle-même ou découler d’exigences du programme comme des cycles de financement. Comme l’a fait remarquer Patton (1997), la clôture d’un cycle peut inclure ou non un rapport d’évaluation, même si les marqueurs pour la fin d’un cycle peuvent être moins clairs en l’absence d’un tel produit.

Brett, Hill-Mead et Wu (dans le présent volume) fournissent des exemples particulièrement clairs de cycles dans un contexte plus large d’évaluation continue. Bien que l’on s’intéresse traditionnellement dans ce calendrier à l’examen de l’utilisation basée sur les résultats, il est aussi possible de s’intéresser à l’influence basée sur le processus. L’influence basée sur le processus au cours de cette période comprendrait les effets des interactions de réseautage entourant la finalisation, la clôture ou la liquidation d’une évaluation. Brett, Hill-Mead et Wu décrivent une influence de fin de cycle qui relie le processus et les résultats lorsqu’ils constatent que la réflexion structurée et basée sur les données du processus de synthèse trimestriel a appris au personnel à encadrer les membres du personnel lors de l’élaboration des objectifs pour l’année suivante. Une théorie intégrée de l’influence élargit également la focale pour observer des influences imprévues en fin de cycle qui peuvent découler soit du processus, soit des résultats.

L’influence à long terme. La notion d’influence à long terme permet de saisir des effets qui peuvent ne pas être ressentis pendant une période donnée ou qui évoluent au fil du temps en effets prolongés. L’inclusion explicite d’une utilisation future est utile pour rappeler aux évaluateurs et évaluatrices de ne pas s’arrêter à court terme dans leur examen de l’influence de leur travail. Bien que l’influence au cours du processus d’évaluation et de communication des résultats soit importante, l’impact le plus puissant du travail n’est peut-être pas encore apparu ou n’est pas visible dans ce délai, et il se situe plutôt dans un contexte futur. La conception de l’utilisation par Preskill et Torres comme apprentissage transformateur (dans le présent volume) souligne l’importance d’une perspective à long terme, considérant l’apprentissage comme un processus continu de dialogue et de réflexion qui se produit progressivement au fil du temps. La première étape vers le suivi et l’étude empirique de l’impact futur est la reconnaissance de sa pertinence conceptuelle par rapport à une théorie intégrée de l’influence.

L’importance de comprendre l’influence à long terme a été soulignée sous l’angle théorique, éthique et pragmatique (Alkin, 1990; Shulha et Cousins, 1997). Bien que l’importance de l’influence à long terme soit bien reconnue (Huberman et Cox, 1990; Patton, 1986; Weiss, 1980), Shulha et Cousins (1997) ont trouvé qu’il était absent d’études empiriques sur l’utilisation.

Bien que les études de recherche aient rapporté – habituellement au moyen de méthodes relativement immédiates et rétrospectives – les conséquences instrumentales, cognitives, affectives et politiques de l’évaluation, elles ne suivent généralement pas ces dimensions à long terme. Par conséquent, elles ne permettent pas de dresser un tableau complet des changements personnels et professionnels chez les participant-e-s et des changements culturels dans les organisations (p. 204).

La notion d’influence à long terme reconnaît que l’influence peut être visible bien au-delà de la fin d’un cycle d’évaluation particulier. Elle invite les évaluateurs et évaluatrices à surveiller l’émergence d’impacts qui sont chronologiquement plus éloignés de l’évaluation et à identifier a posteriori des impacts antérieurs au fil du temps. L’influence à long terme peut être retardée, prolongée, ou les deux. En cas d’influence retardée, par exemple, les résultats de l’évaluation d’une étude sur la satisfaction des usagers et usagères peuvent au départ ne pas être utilisés en raison d’autres exigences du programme. Toutefois, quelques années plus tard, dans le cadre de la refonte du programme pour le prochain cycle de déploiement le personnel du programme peut reconnaître la pertinence des données déjà recueillies et les intégrer au bilan pour orienter la nouvelle programmation. Dans le cas d’une influence durable, les résultats peuvent exercer une influence continue qui date du processus d’évaluation lui-même. Les données des focus group ont d’abord été utilisées pour fournir des retours du terrain aux opérateurs et opératrices du programme, puis incorporées dans le rapport annuel qui accompagne le cycle de financement du programme. La reddition de comptes est maintenue et le financement futur des programmes est assuré ou peut-être élargi. Dans cet exemple d’influence basée sur les résultats, les mêmes données qui exercent une influence à long terme ont déjà eu des effets immédiats et en fin de cycle. Dans un modèle combiné, une certaine influence à long terme se poursuit à partir de périodes antérieures et certaines émergent pour la première fois. Si, dans l’exemple précédent, les données des focus group étaient également utilisées dans les efforts de sensibilisation auprès des parties prenantes entrepris quelque temps après l’évaluation, cette influence retardée s’ajouterait à l’influence durable décrite précédemment.

Résumé. L’attention accordée à la temporalité de l’utilisation de l’évaluation n’est pas nouvelle, bien qu’historiquement les discussions sur le temps aient souvent été confondues avec d’autres dimensions plutôt qu’explicitement abordées. Les premiers travaux sur la dimension temporelle ont porté sur l’utilisation immédiate, et ce n’est que plus récemment que l’importance de l’utilisation à long terme a été soulignée. De même, les premières conceptualisations ont parlé de l’utilisation comme d’un événement, alors que les discussions plus récentes conçoivent l’évaluation comme un processus. La division de la dimension temporelle en termes immédiats, de fin de cycle et de long terme élargit la dichotomie commune entre court terme et long terme et s’inscrit en parallèle à la description chronologique conventionnelle des résultats du programme. Toutefois, la nature progressive de l’influence ne devrait pas être occultée par la démarcation de trois périodes. Il s’agit de tenir compte d’une gamme complète d’influences au fil du temps plutôt que de limiter la réflexion à une période étroite. C’est pourquoi la dimension temporelle permet de prendre en compte à la fois le rythme du changement et les périodes chronologiques dans lesquelles il est mis en évidence. […]

Bibliographie

Alkin, Marvin C. 1990. Debates on Evaluation. Thousand Oaks: Sage Publications.

Alkin, Marvin C., Richard Daillak et Peter White. 1979. Using Evaluations: Does It Make a Difference? Thousand Oaks: Sage Publications.

Anderson, Christopher D., James A. Ciarlo et S. F. Brodie. 1981. « Measuring Evaluation-Induced Change in Mental Health Programs ». in Utilizing Evaluation : Concepts and Measurement Techniques, édité par J. A. Ciarlo. Thousand Oaks : Sage Publications, p. 97‑123.

Anderson, Scarvia B., et Samuel Ball. 1978. The Profession and Practice of Program Evaluation. San Francisco: Jossey-Bass.

Argyris, Chris, Robert D. Putnam, et Diana McLain Smith. 1985. Action Science. San Francisco: Jossey-Bass.

Brisolara, Sharon. 1998. « The History of Participatory Evaluation and Current Debates in the Field ». in Understanding and Practicing Participatory Evaluation. Vol. New Directions for Evaluation, édité par E. Whitmore. San Francisco: Jossey-Bass, p. 25‑41.

Caro, Francis G. 1980. « Leveage and Evaluation Effectiveness ». Evaluation and Program Planning 3(2) : 83‑89.

Christie, Christina A., et Marvin C. Alkin. 1999. « Further Reflections on Evaluation Misutulization ». Studies in Educationnal Evaluation 25 : 1‑10.

Ciarlo, James A. 1981. « Editor’s Introduction ». in Utilizing Evaluation: Concepts and Measurement Techniques, édité par J. A. Ciarlo. Thousand Oaks: Sage Publications.

Cousins, J. Bradley, et Kenneth A. Leithwood. 1986. « Current Empirical Research on Evaluation Utilization ». Review of Educational Research 56(3) : 331‑64.

Cousins, J. Bradley, et Elizabeth Whitmore. 1998. « Framing Participatory Evaluation ». New Directions for Evaluation, (80) : 5‑23. doi : https://doi.org/10.1002/ev.1114

Cronbach, Lee J. 1982. Designing Evaluations of Educational and Social Programs. San Francisco: Jossey-Bass.

Cronbach, Lee J., Sueann R. Ambron, Sanford M. Dornbusch, Robert D. Hess, Robert C. Hornik, Denis Charles Phillips, Decker F. Walker, et Stephen S. Weiner. 1980. Toward Reform of Program Evaluation: Aims, Methods, and Institutional Arrangements. San Francisco: Jossey-Bass.

Fetterman, David M. 1994. « Empowerment evaluation ». Evaluation Practice 15(1) : 1‑15. doi : https://doi.org/10.1177%2F109821409401500101

Greene, Jennifer C. 1988. « Communication of Resultas and Utilization in Participatory Program Evaluation ». Evaluation and Program Planning 11(4) : 341‑51.

Greene, Jennifer C. 1988b. « Stakeholder Participation and Utilization in Program Evaluation ». Evaluation Review 12(2) : 91‑116.

Henry, Gary T., et Debra J. Rog. 1998. « A Realist Theory and Analysis of Use ». in Realist Evaluation: An Emerging Theory in Support of Practice., édité par G. T. Henry, G. Julnes, et M. M. Mark. San Francisco: Jossey-Bass.

Huberman, Michael, et Pat Cox. 1990. « Evaluation Use: Building Links Between Action and Reflection ». Studies in Educational Evaluation 16 : 157‑79.

Johnson, R. Burke. 1998. « Toward a Theoretical Model of Evaluation Utilization ». Evaluation and Program Planning 21(1) : 93‑110. doi: https://doi.org/10.1016/S0149-7189(97)00048-7

Kirkhart, Karen E. 1995. « Consequential Validity and an Integrated Theory of Use ».

Kirkhart, Karen E. 1999. « Multifaceted Dimensions of Use: Intended and Unintended Influences ».

Knorr, Karin D. 1977. « Policymakers’ Use of Social Science Knowledge: Symbolic or Instrumental ? » in Using Social Research in Public Policy Making. Lexington Mass: Heath.

Leviton, Laura C., et Edward F. X. Hughes. 1981. « Research on the Utilization of Evaluations : A Review and Synthesis ». Evaluation Review 5(4) : 525‑48. doi : https://doi.org/10.1177%2F0193841X8100500405

McClintock, Charles, et Laura A. Colosi. 1998. « Evaluation of Welfare Reform: A Framework for Addressing the Urgent and the Important ». Evaluation Review 22(5) : 668‑94. doi : https://doi.org/10.1177/0193841×9802200505

Patton, Michael Q. 1986. Utilization-Focused Evaluation. 2e éd. Beverly Hills: Sage Publications.

Patton, Michael Q. 1994. « Developmental Evaluation ». Evaluation Practice 15(3) : 311‑19.

Patton, Michael Q. 1997. Utilization-focused evaluation: The new century text. 3e éd. Thousand Oaks: Sage Publications.

Patton, Michael Q. 1998. « Discovering Process Use ». Evaluation 4(2) : 225‑33.

Rein, Martin, et Sheldon H. White. 1975. « Can Policy Research Help Policy? » Public Interest 49 : 119‑36.

Rich, Robert F. 1977. « Use of Social Sciences Information by Federal bureaucrats: Knowledge for Action Versus Knowledge for Understanding ». in Using Social Research in Public Policy Making, édité par C. H. Weiss. Lexington, Mass: Heath.

Rippey, Robert M. 1973. Studies in Transactional Evaluation. Berkeley: McCutchan.

Rodman, Hyman, et Ralph Kolodny. 1972. « Organizational Strains in the Researcher-Practitioner Relationship ». in Evaluating Action Programs: Readings in Social Action and Education, édité par C. H. Weiss. Needham Heights: Allyn & Bacon.

Scriven, Michael. 1991. Evaluation Thesaurus. 4e éd. Thousand Oaks: Sage Publications.

Shadish, William R., Thomas D. Cook et Laura C. Leviton. 1991. Foundations of program evaluation: Theories of practice. Newberry Park: Sage Publications.

Shulha, Lyn M., et J. Bradley Cousins. 1997. « Evaluation use: Theory, research, and practice since 1986 ». Evaluation Practice 18(3) : 195‑208. doi: https://doi.org/10.1177%2F109821409701800302

Smith, M. F. 1988. « Evaluation Use Revisited ». J. A. McLaughlin, L. J. Weber, R. W. Covert et R. B. Ingle, dir. Evaluation Utilization. San Francisco: Jossey-Bass, p. 7-19.

Tornatzky, Louis G. 1979. « The Triple-Threat Evaluator ». Evaluation and Program Planning 2(2) : 111‑15.

Weiss, Carol H. 1980. « Knowledge creep and decision accretion ». Diffusion 1(3) : 381‑404.

Weiss, Carol H. 1981. « Measuring the Use of Evaluation ». in Utilizing Evaluation: Concepts and Measurement Techniques. Thousand Oaks: Sage Publications.

Weiss, Carol H., et Michael J. Bucuvalas. 1980. « Truth Tests and Utility Tests: Decision-Makers’ Frames of Reference for Social Sciences Research ». American Sociological Review 45 : 302‑13.

Whitmore, Elizabeth. 1991. « Evaluation and Empowerment: it’s the Process That Counts ». Empowerment and Family Support Networking Bulletin (Cornell University Empowerment Project) 2(2) : 1‑17.

Wholey, Joseph S. 1994. « Assessing the Feasibility and Likely Usefulness of Evaluation ». in Handbook of Practical Program Evaluation, édité par J. S. Wholey, H. P. Hatry, et K. E. Newcomer. San Francisco: Jossey-Bass.

- Special Issue: The Expanding Scope of Evaluation Use. New Directions for Evaluation, Volume 2000, Issue 88, Winter 2000. ↵