V. La diversité des approches paradigmatiques

Introduction : la pluralité des approches paradigmatiques

Valéry Ridde, Thomas Delahais, Agathe Devaux-Spatarakis et Anne Revillard

À l’instar de la santé publique ou de la médecine par exemple, l’évaluation ne relève pas seulement de la recherche (partie Sciences), mais aussi et surtout de la pratique, de la réalisation d’activités qui visent à porter un jugement (partie Valeurs) ou à comprendre une intervention ou une politique, quel que soit le domaine concerné (éducation, justice, politique, transport, etc.). Or, comme nous l’a appris Pierre Bourdieu, un tel champ est nécessairement un lieu de conflits et d’enjeux de pouvoir (Bourdieu, 2001). La pratique de l’évaluation n’en fait pas l’économie, notamment lorsqu’il s’agit d’appréhender des questions complexes comme celle de la causalité, laquelle se trouve au cœur de l’analyse de l’efficacité des interventions. En effet, comment affirmer devant tel-le responsable politique que son projet pilote visant à fournir un revenu minimal à ses concitoyennes et concitoyens, leur a permis de sortir de la pauvreté et de trouver un emploi, et de ce fait rend essentiel son déploiement à une très large échelle? Comment étayer cette démonstration, et apporter la preuve que le revenu minimal a permis un retour à l’emploi? Nous sommes là au centre de la compréhension de la nature de la preuve, de nos schémas de pensée et partant, de nos manières de concevoir le monde.

Les paradigmes

Notre façon d’appréhender le monde est souvent résumée par un terme relativement galvaudé aujourd’hui, car utilisé trop souvent en dehors de son sens premier, celui de paradigme. Il existe de multiples acceptions de ce concept, lequel est utilisé par exemple dans le domaine de l’étude des politiques publiques pour évoquer des ruptures majeures (Hall, 1993), en une reprise des propositions du philosophe des sciences Thomas Kuhn au sujet des révolutions scientifiques (Kuhn, 2016). La notion de paradigme renvoie essentiellement à quatre dimensions interreliées : l’épistémologie (relation que l’on entretient avec les données), la méthode (outils d’évaluation), l’ontologie (nature du monde et manipulation possible des objets de l’évaluation), la téléologie (finalité des évaluations). Nous avons évoqué en détail ces dimensions dans un ouvrage francophone concernant l’évaluation (Dagenais et Ridde, 2012).

Si l’on se réfère au développement historique de l’évaluation, les paradigmes concernés sont pour l’essentiel les paradigmes scientifiques. Sans vouloir simplifier exagérément, il est possible de les résumer en trois catégories : le positivisme, le réalisme et le relativisme. Ces catégories, comprises comme des idéaux types n’épuisant pas la complexité, font appel à des représentations du monde différentes et donc, si l’on reprend l’une des quatre dimensions précédentes, à l’utilisation de méthodes particulières. Mais il ne faut pas s’y méprendre, une évaluation est d’abord organisée pour répondre à des questions concernant une intervention et non pas – ce qui est essentiellement le propos des équipes de recherche – pour mobiliser des méthodes. Il n’existe pas plus de méthode parfaite que d’approche paradigmatique idéale. L’important, dans le domaine de l’évaluation, est de trouver les moyens techniques et intellectuels de disposer des données nécessaires pour répondre aux questions d’évaluation, et pour ainsi étayer les décisions qui seront prises.

Les textes rassemblés dans ce chapitre permettent de mettre en évidence des différences, des subtilités, mais aussi des ressemblances, et de montrer l’évolution des débats sur ces questions. Si l’on s’attarde aux deux extrêmes du continuum, les personnes ancrées dans une approche positiviste auront tendance à choisir une démarche méthodologique préalablement à l’évaluation (en utilisant surtout des données quantitatives), sans la faire évoluer par peur de biaiser ou d’influer sur les résultats, eu égard à leur croyance en l’objectivité. À l’autre extrême, les relativistes vont principalement prendre en compte les données qualitatives, et adapter en permanence leurs outils afin de mieux s’adapter au contexte et aux données – lesquels sont en transformation constante-, abandonnant le rêve de l’objectivité pour s’orienter vers une objectivation assumée de ce qu’ils observent.

D’un capharnaüm de paradigmes au pragmatisme

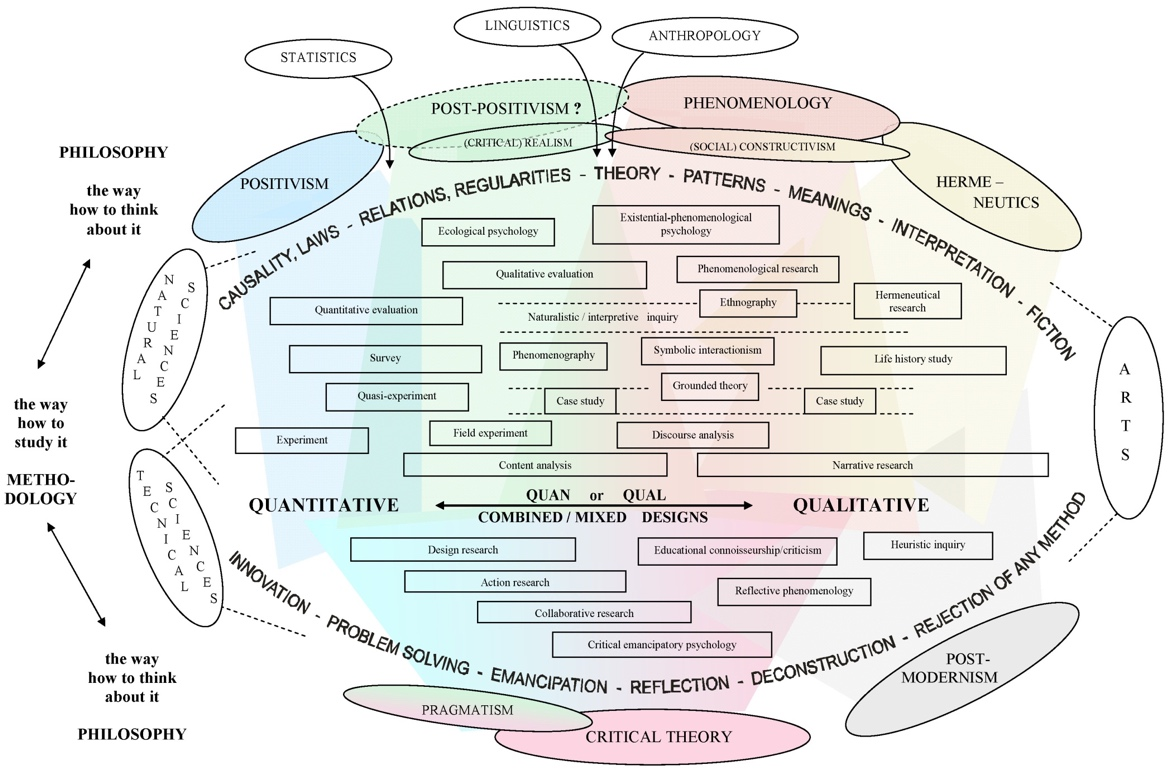

Mais la vie, et surtout la pratique de l’évaluation ne se résument pas à cette dichotomie, surtout si l’on convient qu’il s’agit avant tout de répondre à des questions spécifiques concernant une intervention. Ce sont les questions qui doivent guider les évaluations, non pas les méthodes. Il existe un réel continuum, sinon un capharnaüm (cf. figure ci-dessous), dans les approches paradigmatiques, remises notamment au goût du jour par les tenants du pragmatisme et des méthodes mixtes. Katrin Niglas (2010) a tenté une représentation visuelle de cette complexité impressionnante, qui montre l’imbrication des paradigmes, des méthodes et des disciplines sans pour autant en cloisonner les approches.

Figure 1 : Un modèle multidimensionnel des méthodes et des paradigmes de recherche

Source : Katrin Niglas http://www.tlu.ee/~katrin/mmrm/skeem_handbook.jpg

Reprenant l’appel des Français Daniel Schwartz et Joseph Lellouch (Schwartz et Lellouch, 2009) de la fin des années 1960 à plus de pragmatisme, les tenants de cette perspective dans le domaine de l’évaluation réclament moins de dogmatisme. S’attacher à un paradigme ou à des méthodes en particulier, permet rarement de répondre aux objectifs des évaluations. Cependant, il ne faut pas sous-estimer le poids de ces enjeux dans les débats, lesquels ont fait rage entre les tenants de l’évaluation qualitative ou quantitative dans les années 1980 et 1990. Puis, il semble qu’ils se soient estompés au tournant du siècle, au profit de la vision commune d’un primat des objectifs de l’évaluation sur le choix des méthodes (Mark, 2003). C’était pour mieux renaître, quelques années plus tard, avec l’offensive de partisans et partisanes des méthodes expérimentales par assignation aléatoire (randomistas) tendant à nier la scientificité de toute autre méthode (Donaldson, 2009). Si le bilan du recours à ces méthodes dans les années 2000 n’apparaît pas bien différent de celui établi dans les années 1980 (Heckman, 2020), il aura fallu plus de 10 ans pour que la communauté évaluative fasse apparaître de nouvelles approches causales et les méthodes pour les rendre opérationnelles (Stern et al., 2012).

Les controverses restent donc nombreuses, mais les évolutions sont possibles et intéressantes, comme en témoignent les textes rassemblés dans ce chapitre.

Fondements : de quelle causalité parle-t-on?

Les débats les plus anciens et les plus virulents sur les questions paradigmatiques dans le domaine de l’évaluation concernent surtout la question de l’efficacité des interventions et la nature de la preuve attestant que les objectifs des interventions sont atteints (la causalité). Ces débats ont aussi concerné d’autres sujets, comme celui du rôle de l’évaluateur ou évaluatrice, ou de la manière dont les personnes concernées par l’intervention participent à l’évaluation (partie Evaluatrice). Mais les discussions les plus engagées ont de tout temps, encore aujourd’hui, porté sur la manière dont il est possible d’affirmer qu’une intervention a été efficace. Or, pour ce faire, il faut se mettre d’accord sur la manière dont on comprend la causalité, autrement dit sur le fait que l’intervention Y puisse être tenue responsable des changements X, et sur les processus et les données à mobiliser pour rendre compte des effets X, à la suite de l’organisation de l’activité Y. À l’instar des paradigmes, il existe une myriade de points de vue sur ce sujet.

Pour simplifier, jusqu’à la fin des années 1990, le débat oppose deux camps. D’une part, celui des tenantes et tenants de la causalité par le repérage d’une succession d’événements montrant que l’effet attendu d’une intervention est produit par des actions spécifiques, précises et préalables à cette dernière. La personne qui évalue va alors chercher à contrôler ces processus et ces variables contextuelles, pour estimer les effets de cette relation relativement linéaire entre causes et conséquences. Les approches expérimentales discutées par Donald Campbell et Julian Stanley (texte 1) sont au cœur de cette perspective. Leur texte offre une riche présentation de leurs origines et fondements ainsi que du développement subséquent des approches plus pragmatiques, mais toujours ancrées dans cette même vision du monde, et qualifiées de quasi expérimentales.

D’autre part, et selon une perspective très différente, nous trouvons les tenant-e-s d’une causalité qui est en mesure de prendre en compte les éléments de contexte et d’environnement, pour qui la vision linéaire et immuable d’une relation entre une intervention et ses effets n’existe pas dans le monde réel. Cette vision dite générative (ou explicative) de la causalité postule que les effets des interventions s’expliquent par la volonté et le raisonnement des personnes qui les produisent. Ces débats ont récemment resurgi dans le monde de l’évaluation, mais ils sont très anciens, comme le montre le texte de Lawrence Mohr (texte 2) concernant la mobilisation des approches qualitatives dans l’évaluation de l’impact des interventions. Ce texte est fondamental pour comprendre la notion de causalité et les enjeux paradigmatiques de la compréhension de la comparaison entre, d’un côté, les effets provoqués par une intervention, et de l’autre, ce qui se serait produit sans cette action, le fameux concept de « contrefactuel ». Il est aussi une introduction à l’approche de « modus operandi » proposée par Michael Scriven, qui agit comme un détective à la recherche d’indices et de traces, en éliminant au fur et à mesure de l’évaluation certaines causes possibles des effets constatés de l’intervention (voir aussi la démarche du « process tracing ») (Maillet et Mayaux, 2018). Cette forme de raisonnement est évidemment différente de celle du « contrefactuel » pour juger de l’efficacité d’une intervention, ainsi que l’illustrent ces deux textes.

Controverses : les méthodes expérimentales par assignation aléatoire

« La guerre de la causalité fait toujours rage » : tel est le début de l’article que Scriven écrit en 2008 (texte 3). À ce sujet, les controverses, pour ne pas utiliser un vocabulaire guerrier redevenu à la mode en temps de pandémie, remontent à loin. En France en particulier, le retour de l’approche expérimentale pour l’évaluation de l’efficacité des interventions leur a permis de refaire surface, alors qu’elles sont très anciennes, sinon consubstantielles à la pratique de l’évaluation. Depuis l’expérimentation du revenu de solidarité active, jusqu’à la médiatisation d’un prix Nobel de l’économie du développement, en passant par les débats contemporains sur l’efficacité d’un médicament contre un nouveau virus, il s’agit du même type de démarche dont il est question pour évaluer l’efficacité d’une intervention : les essais contrôlés randomisés (ECR), autrement appelés en français méthodes expérimentales par assignation aléatoire. Même si les controverses sur la question paradigmatique sont multiples dans les démarches d’évaluation, nous avons choisi d’en rendre compte à propos des ECR, car en cette matière, le débat est permanent. Il ne sera certainement jamais terminé, mais il nous paraît important que la lecture de cet ouvrage permette de l’appréhender dans la durée.

Alors que les textes cités précédemment permettent de comprendre les fondements des approches expérimentales, Scriven (texte 3) offre une mise en perspective intéressante des ECR à partir de son analyse… expérimentée. Il présente une dizaine de propositions concernant cette démarche, tant au plan paradigmatique que méthodologique. Pour chacune, il soulève des controverses afin de susciter une discussion ouverte tout en prenant de la distance, et, en conclusion, affirme que loin d’être une querelle habituelle d’universitaires et d’égos, il s’agit là d’un débat essentiel à la pratique de l’évaluation. La compréhension de la nature de la causalité est au centre des réflexions de Scriven, et surtout, de la manière de l’appréhender dans le contexte d’une évaluation crédible, sans tomber dans le dogmatisme des approches méthodologiques. Il ne s’inscrit pas dans une approche paradigmatique particulière et son approche de la causalité est logique et empirique. Dans un texte un peu plus ancien, Joseph Maxwell (texte 4) aborde la controverse concernant l’utilisation de données qualitatives pour l’évaluation de l’efficacité des interventions et partant de la mise en évidence d’une relation causale. Nous aurons compris que les tenants de la causalité « successionniste » souhaitent mesurer des variables dépendantes (les effets) et contrôler les facteurs contextuels. Dans cette perspective, ils remettent évidemment en question la capacité de se servir du discours des acteurs sociaux ou de l’observation de la réalité pour l’analyse causale, ce que réfute Maxwell. Ce dernier revient sur les différentes approches paradigmatiques de la causalité et des controverses à leur sujet, pour introduire une démarche évaluative qui va devenir de plus en plus populaire dans les années 2000: l’approche réaliste. Cette démarche initialement proposée par des sociologues et des criminologues anglais a fait l’objet de nombreuses contributions en français (Robert et Ridde, 2014), nous n’y reviendrons donc pas en détail. Mais l’intérêt du texte de Maxwell est de s’inscrire dans ces débats et de montrer qu’ils ne sont pas nouveaux. La philosophie et la sociologie des sciences sont convoquées pour comprendre la notion de causalité dans une perspective très différente de celle prônée par les tenants des ECR. Il revient aussi sur les fondements de l’approche réaliste en évaluation, comprise comme une autre solution à la dichotomie présentée en introduction de ce chapitre. Ce texte est également très utile pour appréhender les notions de processus et de théorie d’intervention comme dimensions essentielles à la compréhension de l’efficacité des interventions. En effet, la plupart du temps, les évaluations utilisant uniquement des ECR ne donnent pas d’explication quant à la manière dont les effets constatés ont été produits, contrairement à ce que propose White par exemple. C’est la fameuse notion de « boîte noire » des ECR (valable aussi parfois pour d’autres approches), source de multiples controverses depuis toujours et à propos de laquelle les textes cités dans le paragraphe suivant permettent d’entrer en détail. Mais Maxwell tente d’approfondir la réflexion en montrant comment l’analyse des processus n’est pas cantonnée à la description de ce qui se passe dans une intervention, mais peut aussi être utile pour rendre compte d’explications causales. Pour arriver à ces explications, il nous suggère plusieurs méthodes détaillées permettant de conforter la confiance que l’on peut avoir dans les approches qualitatives pour une démarche d’inférence causale.

Perspectives : pragmatisme et réalisme?

On aura compris à la lecture des textes précédents que les débats et controverses au sujet de la manière d’évaluer l’efficacité des interventions sont anciens et nombreux. Nous avons pris l’exemple des discussions sur la causalité, car elle nous semble la plus prégnante et illustrative de la permanence de la réflexion. L’avenir de l’évaluation est certainement du côté de la mise à l’écart de tout dogmatisme disciplinaire ou paradigmatique. Pour lutter contre un virus par exemple, la biologie, l’épidémiologie ou la médecine seule ne suffisent pas. De la même façon, la compréhension d’une intervention et l’évaluation de son efficacité ne peuvent se limiter à l’usage unique d’un ECR ou d’une approche ethnographique. Il aura fallu une bonne dizaine d’années à la communauté évaluative pour s’extraire de cette opposition stérile en revenant aux fondements de la causalité. Le futur s’articule ainsi autour de quatre grandes familles causales : i) le contrefactuel et la régularité, avec le retour en force d’études basées sur des observations de grande qualité; ii) la génération, avec des approches renouvelées telles que l’évaluation réaliste; iii) la reconstitution de processus (process tracing) ou l’analyse de contribution; iv) la configuration, qui s’attache à repérer les conditions nécessaires ou suffisantes associées aux changements attendus (Stern et al., 2012).

À l’image des personnes suggérant un recours accru aux méthodes mixtes dans le domaine de l’évaluation (Bujold et al., 2018), dépassant ainsi les discussions paradigmatiques pour plus de pragmatisme, le futur est peut-être dans une voie du dépassement consistant à mêler les approches.

En effet, nous assistons depuis quelques années à un double renouveau des approches fondées sur les ECR et de l’approche réaliste, au sujet desquelles, comme nous l’avons vu plus haut, les discussions sont récurrentes. Michael Patton aimait à rappeler cette fameuse guerre des paradigmes et son pouvoir sclérosant pour la pratique de l’évaluation. Si le recours concomitant ou séquentiel à des méthodes quantitatives et qualitatives n’est pas nouveau, leur conceptualisation et l’approche réflexive à leur égard est plus récent, permettant notamment de discuter du besoin de dépassement des frontières. C’est dans ce contexte de tentative de réconciliation que les récents développements autour des ECR et de l’approche réaliste peuvent constituer une discussion intéressante sur le futur de l’évaluation.

En effet, depuis quelques années, ce double renouveau dans le champ de l’évaluation n’est pas sans poser de questions concernant les approches paradigmatiques, certains allant jusqu’à proposer, non pas d’insérer une démarche tirée du paradigme réaliste dans les ECR, mais bien de développer des ECR réalistes (texte 5). Comme pour les méthodes mixtes, certain-e-s pensent que les paradigmes sont irréconciliables, tandis que d’autres œuvrent pour le dialogue. Personne ne peut évidemment prédire l’avenir du champ de l’évaluation. Ce dernier sera peut-être construit par des individus qui ne souhaitent pas prendre position et s’inscriront plutôt dans un pragmatisme où les débats sur la vision du monde seront ignorés au profit d’une réponse rigoureuse aux commanditaires des évaluations (les citoyen-ne-s compris-e-s). Toujours est-il qu’il nous a semblé important de donner accès à un débat contemporain et relativement nouveau autour de la conciliation entre les ECR et l’approche réaliste en évaluation. Trois textes permettent d’instaurer un dialogue. Ils traduisent les débats sur la tentative de réconciliation entre les tenants des ECR et ceux de l’évaluation réaliste, dont on peut dire que les approches de la causalité sont très différentes. La lecture de ces textes apporte des éléments-clefs au débat et permettra, notamment de se forger une opinion, sur la question centrale de la causalité. La pratique de l’évaluation ira-t-elle dans le sens des « puristes » de l’approche réaliste (texte 6) en affirmant que l’appréhension de la causalité, des mécanismes sous-jacents et des méthodes mobilisées sont incompatibles avec le paradigme dont ils se défendent? Ou alors sera-t-elle plutôt en accord avec les collègues qui proposent les ECR réalistes (texte 5, texte 7) permettant d’allier la force de la démonstration de la causalité au moyen de l’approche par assignation aléatoire des ECR, avec la compréhension de la « boîte noire » de l’intervention à l’aide de l’approche réaliste? L’une des questions centrales quant au futur de l’évaluation est donc celle – oxymorique? – de l’association entre les approches expérimentales et le réalisme critique.

Bibliographie

Bourdieu, Pierre. 2001. Science de la science et réflexivité. Paris : Raisons d’agir.

Bujold, Mathieu, Nha Hong, Valéry Ridde, Claude Julie Bourque, Maman Joyce Dogba, Isabelle Vedel et Pierre Pluye. 2018. Oser les défis des méthodes mixtes en sciences sociales et sciences de la santé. Montréal : ACFAS.

Dagenais, Christian et Valéry Ridde. 2012. Approches et pratiques en évaluation de programmes. Montréal : Presses de l’Université de Montréal.

Donaldson, Stewart I. 2009. « In Search of the Blueprint for an Evidence-Based Global Society ». in What counts as credible evidence in applied research and evaluation practice, édité par S. I. Donaldson, C. A. Christie et M. M. Mark. Los Angeles: Sage Publications, p. 2‑18.

Hall, Peter A. 1993. « Policy paradigms, social learning and the state: the case of economic Policymaking in Britain ». Comparative Politics 25(3) : 275‑296.

Heckman, James J. 2020. « Epilogue: Randomization and Social Policy Evaluation Revisited ». in RCTs in Development: A Critical Perspective, édité par F. Bédécarrats, I. Guérin et F. Roubaud. Oxford: Oxford University Press, p. 304‑30.

Kuhn, Thomas S. 2016. La structure des révolutions scientifiques. Paris : Flammarion.

Maillet, Antoine et Pierre-Louis Mayaux. 2018. « Le process tracing : Entre narration historique et raisonnement expérimental ». Revue française de science politique 68(6) : 1061. doi : 10.3917/rfsp.686.1061.

Mark, Melvin M. 2003. « Toward a integrative view of the theory and practice of program and policy evaluation ». in S. I. Donaldson & M. Scriven (éds.) Evaluating social programs and problems: Visions for the new millennium. Mahwah, NJ: Erlbaum, p. 183-204.

Niglas, Katrin. 2010. « The multidimensional model of research methodology: An integrated set of continua ». in Mixed methods in social and behavioral research. Los Angeles, p. 215‑36.

Robert, Émilie et Valéry Ridde. 2014. « L’approche réaliste pour l’évaluation de programmes et la revue systématique : de la théorie à la pratique ». Mesure et évaluation en éducation 36(3) : 79‑108.

Schwartz, Daniel, et Joseph Lellouch. 2009. « Explanatory and Pragmatic Attitudes in Therapeutical Trials ». Journal of Clinical Epidemiology 62(5) : 499‑505. doi : 10.1016/j.jclinepi.2009.01.012.

Stern, Elliot, Nicoletta Stame, John Mayne, Kim Forss, Rick Davies, et Barbara Befani. 2012. Broadening the range of designs and methods for impact evaluations. Report of a study commissioned by the Department for International Development. 38. Department for International Development (Dfid).