I. À quoi sert l’évaluation?

Introduction : à quoi sert l’évaluation?

Agathe Devaux-Spatarakis, Thomas Delahais, Anne Revillard et Valéry Ridde

Après un demi-siècle de financement d’évaluations à travers le monde, quel bilan dresse-t-on de leurs impacts sur l’amélioration de l’action publique? Ce questionnement autour de l’utilité de l’évaluation est central, d’une part parce que cette dernière est principalement financée par des fonds publics, et donc soumise à des obligations de redevabilité; d’autre part parce qu’elle est conduite dans le cadre d’une commande visant à améliorer l’action publique. Ainsi, déterminer si l’évaluation a une influence sur la conduite de l’action publique revient à lui appliquer sa propre démarche, et à se demander dans quelle mesure elle atteint ses objectifs.

Force est de constater qu’à ce jour, l’évaluation n’a pas été déterminante pour la transformation de l’action publique (Spenlehauer, 2016; Weiss, 1988). Le personnel politique n’y fait que rarement référence, et elle reste quasiment absente du débat parlementaire et citoyen. Néanmoins, celle-ci continue d’être financée et promue que ce soit au niveau national ou par les organismes internationaux, notamment par l’OCDE, les Nations Unies ou la Banque Mondiale.

Mais alors, que vise l’évaluation? Faut-il chercher des impacts de l’évaluation ailleurs que dans la prise de décision publique? Quelle place peut-elle revendiquer dans la conduite de l’action publique?

Des décennies d’analyse et de débats sur l’utilisation des évaluations nous permettent d’apporter un éclairage sur ces questionnements.

Fournir une réponse tranchée et rigoureuse sur l’utilité ou l’utilisation de l’évaluation est un exercice périlleux. Cela requiert de définir en amont les objectifs de l’évaluation, et d’en préciser les critères de jugement. Or, ceux-ci sont légion. Dès ses prémices, l’évaluation a été présentée par ses promoteurs et promotrices comme un instrument au service de la transformation de l’intervention publique, porteuse soit d’une approche expérimentale (Campbell, 1969), soit d’une logique de rationalisation et d’économie des dépenses publiques (dans le cadre du mouvement de la rationalisation des choix budgétaires), voire d’une démarche favorisant la participation citoyenne au contrôle et à la fabrique des politiques publiques (Viveret, 1989). Dès lors, comment proposer une définition univoque de l’utilisation de l’évaluation?

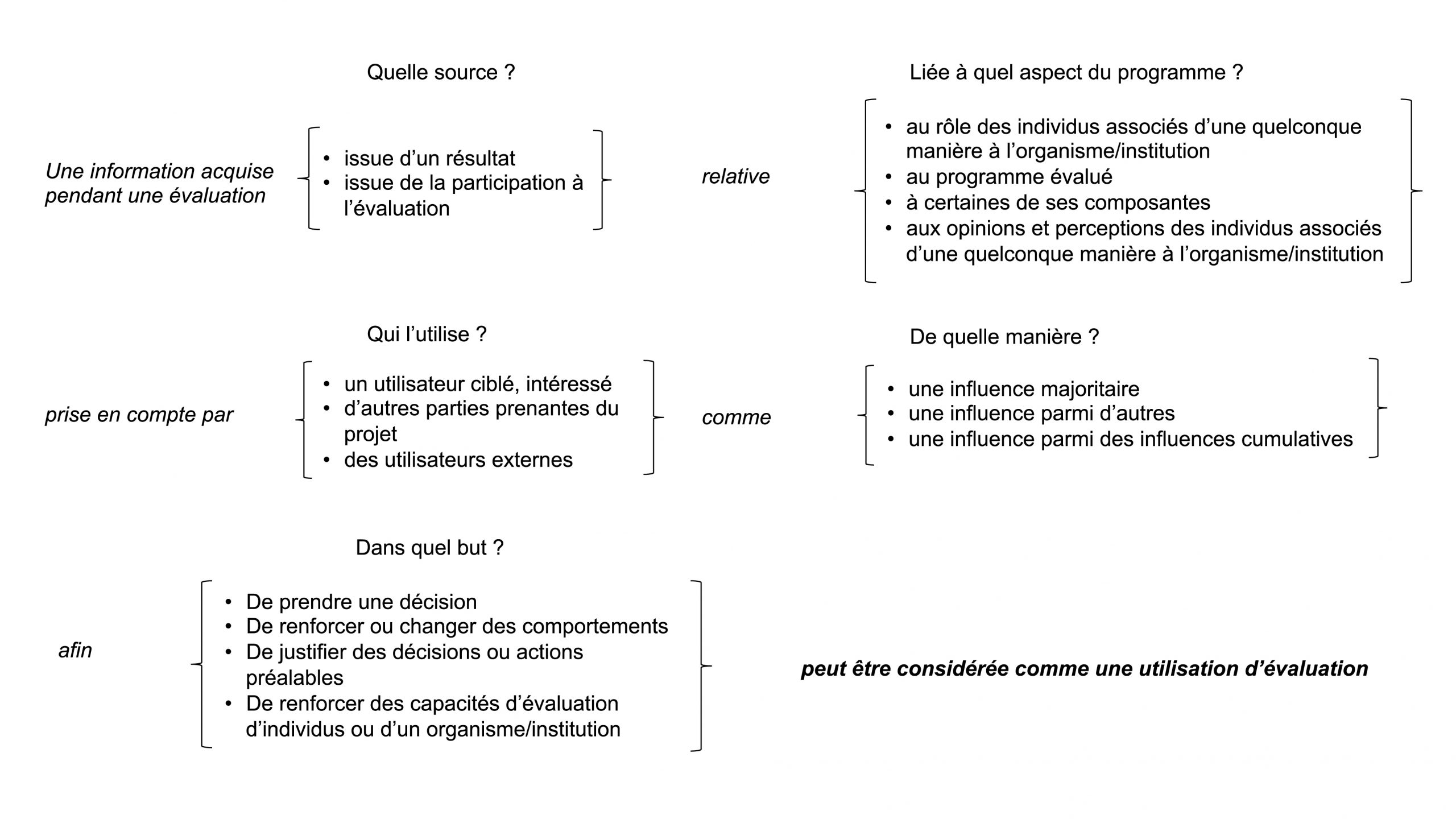

Après une revue extensive des écrits scientifiques à ce sujet, Marvin Alkin et Jean King (Alkin et King, 2017) proposent une définition de l’utilisation de l’évaluation par une phrase composite (notre traduction).

Figure 1 : Définition de l’utilisation de l’évaluation (Alkin et King, 2017)

Ainsi, selon cette définition, « une information acquise pendant une évaluation, [issue d’un résultat], relative [au programme évalué] prise en compte par [un utilisateur ou une utilisatrice ciblé-e, intéressé-e] comme [une influence majoritaire] afin [de prendre une décision] peut être considérée comme une utilisation d’évaluation ». Mais aussi « une information acquise pendant une évaluation, [issue de la participation à l’évaluation], relative [au rôle des individus associé-e-s d’une quelconque manière à l’organisme/institution] prise en compte par [des utilisateurs et utilisatrices externes] comme [une influence parmi d’autres] afin [de justifier des décisions ou actions préalables] peut de la même manière être considérée comme une utilisation d’évaluation ».

En outre, il s’agit de considérer que chaque possibilité proposée dans cette définition recouvre à elle seule une diversité de contextes démultipliant les types d’utilisation pouvant être observés (Patton, 2020). Dès lors, cette diversité de configurations a entraîné la nécessité de caractériser la multiplicité des usages, et remet en question la possibilité même d’élaborer une grille d’indicateurs standards permettant de poser un diagnostic sur l’utilisation d’une d’évaluation.

À cette multiplicité d’utilisations et d’usages de l’évaluation s’ajoutent les « mésusages » (misuse) de l’évaluation. C’est-à-dire l’utilisation intentionnelle de l’évaluation ou de ses résultats à mauvais escient. Cette notion de « mésusages » s’appuie sur une appréciation normative de cet usage, selon la déontologie guidant les pratiques des équipes d’évaluation. L’exemple le plus courant est la sélection des résultats positifs partiels de l’évaluation, et la mise à l’écart de résultats défavorables afin de servir les intérêts politiques (Rajkotia, 2018).

On trouve enfin bien sûr l’absence d’utilisation, laquelle peut être intentionnelle ou pas, suivant que les utilisateurs et utilisatrices ciblé-e-s n’ont pas connaissance de l’évaluation ou que celle-ci n’a pas apporté de démonstration étayée et convaincante (Cousins, 2004).

Les rôles qui incombent à l’équipe d’évaluation dans la promotion de son travail sont multiples, et s’organisent autour de ces débats. Pour certain-e-s, concentrant leurs efforts sur l’utilisation des résultats de l’évaluation, l’équipe d’évaluation peut agir en conduisant une démonstration la plus rigoureuse possible de la causalité, afin de convaincre les décideurs et décideuses (Duflo, 2005). Leur travail se concentre alors sur la scientificité de la méthode. Pour d’autres, visant une multiplicité d’usages et d’influences, l’équipe d’évaluation peut renforcer l’utilité de ses travaux en étudiant et en adaptant son approche et ses méthodes au contexte de la demande et aux besoins de ses commanditaires (Patton, 1988). Ils s’intéressent donc en priorité à l’analyse du contexte, des enjeux de l’évaluation, et des motivations de la prise de décision.

Fondements : de l’utilisation des résultats aux usages de l’évaluation

Cette problématique a été abordée dans un premier temps à partir du diagnostic à établir sur l’utilité des évaluations. En effet, la proximité de l’évaluation avec la science (cf. partie Science) a d’abord conduit les observateurs et les observatrices à étudier son utilisation en fonction des mêmes critères que ceux des travaux scientifiques (Weiss, 1972). L’emploi de ce prisme d’analyse visait principalement l’utilisation des « livrables de l’évaluation », c’est-à-dire les rapports et les connaissances produites par l’évaluation pour éclairer la décision publique. La prise en compte de ces critères a conclu à la faible utilité de l’évaluation.

Peu à peu, cette approche a fait place à une conception élargie des utilisations possibles de l’évaluation. Des recherches ont alors été conduites pour identifier et caractériser les usages de l’évaluation. La communauté de recherche en évaluation s’est accordée sur l’identification de trois principaux types d’usages de l’évaluation, et sur le fait que non seulement les rapports d’évaluation, mais aussi le processus de l’évaluation en tant que tel sont susceptibles d’être sources de changements. Les trois types d’usages sont :

- Le type instrumental : il correspond à la vision classique du rôle de l’évaluation, c’est-à-dire l’utilisation des résultats par les responsables politiques afin de modifier l’intervention publique;

- Le type conceptuel/apport d’un éclairage nouveau (illumination) : il est utilisé lorsque les résultats de l’évaluation contribuent à voir l’intervention publique sous un angle nouveau et à apporter des connaissances sur un phénomène potentiellement transposable à d’autres contextes;

- Le type persuasif : l’évaluation est utilisée pour légitimer une décision dans le cadre d’un argumentaire politique. Elle est parfois symbolique lorsque la conduite même de l’évaluation indépendamment de ses résultats suffit à appuyer une posture politique avant la conduite même de l’évaluation.

Le texte de Marvin Alkin et Sandy Taut (texte 1) synthétise ces travaux et présente ces différentes catégories d’usages de l’évaluation. Pour autant, si la variété des usages fait consensus auprès des évaluatrices et évaluateurs, des désaccords persistent quant à l’impact de l’évaluation sur de potentielles transformations. Ici deux positions s’opposent :

- Celle de Michael Patton, qui estime que l’évaluateur ou l’évaluatrice peut jouer un rôle central et déterminant dans l’utilisation des résultats de l’évaluation et en faire ainsi un outil de transformation majeure de l’action publique (texte 2). Ces éléments sont approfondis en détail dans la partie Utilité du présent livre.

- Celle de Carol H. Weiss, qui, s’appuyant sur sa connaissance du fonctionnement du champ politique, reconnaît que l’évaluation aussi rigoureuse soit elle n’est qu’une source d’information parmi d’autres, et que son impact est limité par le poids des autres facteurs d’influence sur la décision politique (texte 3).

Controverses : l’évaluation, influence parmi d’autres ou base de décision?

À la suite des premiers travaux sur l’identification des différents usages de l’évaluation, un champ de recherche spécifique a été dédié à l’approfondissement des connaissances à ce sujet. Une des premières démarches consiste à contester l’emploi du terme « utilisation/utilité » en tant qu’il ne permet pas d’appréhender les applications de l’évaluation qui ne sont pas basées sur l’utilisation des résultats, sur les effets non intentionnels, ni sur l’émergence graduelle d’impact dans le temps. Karen Kirkhart (texte 4) nous enjoint d’aborder ce questionnement en nous intéressant à « l’influence » de l’évaluation définie comme « la capacité ou pouvoir de choses ou de personnes à produire des effets sur d’autres par des moyens intangibles ou indirects » (Kirkhart, 2000 : 7).

Cette approche replace l’évaluation comme une contribution parmi d’autres dans le processus complexe de décision, et s’écarte d’une vision linéaire de son utilisation. Elle propose alors une catégorisation de l’influence de l’évaluation en trois dimensions :

- Celle de l’intention : l’usage est-il issu d’une démarche volontaire ou involontaire de l’évaluateur?

- Celle de la source : l’usage est-il issu du processus de l’évaluation ou de ses résultats?

- Celle de la temporalité : l’usage prend-il effet pendant l’évaluation, dès la fin de l’évaluation ou se produit-il sur le long terme?

Cette typologie présente l’avantage de proposer une conception intégrée qui permet d’englober l’ensemble des différents types d’influence de l’évaluation.

S’appuyant sur cette conception de l’influence de l’évaluation, Gary Henry et Melvin Mark (texte 5) se sont engagés dans l’investigation des mécanismes qui sous-tendent l’influence de l’évaluation. En d’autres termes, les auteurs se demandent pourquoi, comment, dans quels cas, et auprès de qui l’évaluation peut exercer une influence. En utilisant les mêmes outils d’analyse que ceux déployés par un évaluateur ou une évaluatrice pour l’étude d’un dispositif, ils se sont efforcés d’identifier les leviers, et les étapes du processus expliquant les différents impacts des évaluations, ce qui les a conduits à formuler une « théorie de programme de l’évaluation ». Ainsi, Henry et Mark identifient-ils trois niveaux d’influence : individuel, interpersonnel et collectif, chacun opérant au moyen de mécanismes variés. Les auteurs poursuivent deux objectifs, d’une part contribuer à structurer les recherches sur l’influence de l’évaluation, et d’autre part, amener les évaluateurs et évaluatrices à formuler un plan de maximisation de la portée de leurs évaluations en activant les mécanismes qu’ils ont identifiés (Mark et Henry, 2004).

D’autres courants appellent à une institutionnalisation de l’évaluation comme source principale d’information de la décision publique (evidence-based policy) (voir le texte de H. White dans la partie Valeurs). D’un côté, ce mouvement enjoint les institutions politiques à s’appuyer de manière systématique sur des résultats probants issus de travaux de recherche ou d’évaluation; de l’autre, il pousse les évaluatrices et évaluateurs à avoir un rôle proactif de capitalisation des connaissances par l’identification et la formulation de bonnes pratiques (best practices) ou de leçons apprises (lessons learned) (Milton, 2010). Ce mouvement se retrouve notamment dans le développement des What Works Centres recensant par thématiques ou types de publics les leçons issues de la recherche ou de l’évaluation (Allard et Rickey, 2017).

Perspectives : repenser le rôle et les valeurs de l’évaluation pour la rendre plus utile?

Les réflexions actuelles autour de l’utilité et de l’influence de l’évaluation ont élargi la focale d’analyse pour s’intéresser, plus globalement, au rôle de l’évaluation dans l’état actuel du monde. En effet, s’intéresser à l’impact de l’évaluation dans le cadre d’un programme public, ou à l’échelle d’un projet, ne constitue qu’un effet intermédiaire de l’évaluation. L’objectif final est la conduite effective de meilleures politiques publiques, qui soient à même d’améliorer le bien-être des citoyens et des citoyennes (pour un développement de ce point, voir le texte de Sandra Mathison dans la partie Évaluatrice).

Dès lors, comment conduire une évaluation de sorte qu’elle embrasse le monde dans sa complexité, et qu’elle s’adapte aux différents contextes, enjeux et systèmes? Thomas Schwandt (texte 6) propose de penser une évaluation « post-normale » qui s’organiserait autour de principes-clés permettant d’élargir et d’approfondir le potentiel d’utilisation des évaluations. Il enjoint les équipes d’évaluation à penser les citoyen-ne-s dans une dynamique de coproduction avec les dispositifs publics, et engagé-e-s dans un questionnement éthique sur les limites et les présupposés de l’évaluation. Pour ce faire, il propose des approches posant la résilience comme but de l’action publique, favorisant la participation des citoyen-ne-s à la démocratie, en délaissant le raisonnement scientifique au profit d’un raisonnement pratique orienté vers l’action.

Pour finir, peut-on considérer que dans le contexte politique actuel de post-vérité (post-truth) l’évaluation a toujours un rôle à jouer? Quelle(s) réponse(s) est-elle en mesure d’apporter? Selon Robert Picciotto (texte 7) l’évaluateur ou l’évaluatrice doit impérativement s’engager dans une lutte contre les discours de post-vérité. Il lui est alors nécessaire d’initier une transformation de son métier. Cela requiert d’identifier les nouveaux buts des politiques publiques, leurs nouveaux objets, leurs nouveaux acteurs (fondations, ONG), de s’internationaliser, de se diversifier, de se digitaliser etc. Cette transformation des techniques doit aller de pair avec une promotion explicite des valeurs démocratiques dans l’évaluation, et notamment du triptyque que propose E. House (House et Howe 1999) (voir ce texte dans la partie Évaluatrice) : l’inclusion (travailler avec des groupes sous-représentés), le dialogue (amener les parties prenantes à se comprendre), et la délibération (échanger au sujet des notions de valeur et de résultat).

Bibliographie

Alkin, Marvin C., et Jean A. King. 2017. « Definitions of Evaluation Use and Misuse, Evaluation Influence, and Factors Affecting Use ». American Journal of Evaluation 38(3) : 434‑50. doi : 10.1177/1098214017717015.

Allard, Caroline et Rickey, Ben. 2017. What Works Centres britanniques : quels enseignements pour des politiques fondées sur la preuve en France? Paris : Agence nationale des solidarités actives.

Campbell, Donald T. 1969. « Reforms as Experiments ». American Psychologist 24(4) : 409‑29.

Cousins, J. B. 2004. « Commentary : Minimizing Evaluation Misuse as Principled Practice ». American Journal of Evaluation 25(3) : 391‑97.

Duflo, Esther. 2005. « Évaluer l’impact des programmes d’aide au développement : le rôle des évaluations par assignation aléatoire ». Revue d’économie du développement 19(2) : 185‑226.

House, Ernest R. et Kenneth R. Howe. 1999. Values in Evaluation and Social Research. 1re éd. Thousand Oaks: Sage Publications.

Kirkhart, Karen E. 2000. « Reconceptualizing Evaluation Use: An Integrated Theory of Influence ». New Directions for Evaluation 2000(88) : 5‑23. doi : 10.1002/ev.1188.

Mark, Melvin M., et Gary T. Henry. 2004. « The Mechanisms and Outcomes of Evaluation Influence ». Evaluation 10(1) : 35‑57. doi : 10.1177/1356389004042326.

Milton, N. J. 2010. The lessons learned handbook: practical approaches to learning from experience. Oxford, UK: Chandos Publishing.

Patton, Michael Quinn. 1988. « Reports on Topic Areas: The Evaluator’s Responsibility for Utilization ». American Journal of Evaluation 9(2).

Rajkotia, Yogesh. 2018. « Beware of the Success Cartel: A Plea for Rational Progress in Global Health ». BMJ Global Health 3(6). doi : 10.1136/bmjgh-2018-001197.

Spenlehauer, Vincent. 2016. « La (f)utilité gouvernementale de l’évaluation des politiques publiques, quelques leçons américaines et françaises ». LIEPP Working Paper 49.

Viveret, Patrick. 1989. L’évaluation des politiques et des actions publiques. Propositions en vue de l’évaluation du Revenu minimum d’insertion. Paris : Rapport au Premier Ministre. Commissariat au Plan.

Weiss, Carol. H. 1988. « If Program Decisions Hinged Only on Information: A Response to Patton ». Evaluation Practice/American Journal of Evaluation 9(3) : 15‑28. doi : 10.1177/109821408800900302.

Weiss, Carol H. 1972. « Utilization of evaluation: Toward comparative study ». in Evaluating action programs: Readings in social action and education. Boston: Allyn & Bacon.