III. Comment juger de la valeur des interventions?

1. La société expérimentale du XXIe siècle : les quatre vagues de la révolution de la preuve

Howard White

[Traduit de : White, Howard. 2019. « The twenty-first century experimenting society : The four waves of the evidence revolution ». Palgrave Communications, 5(1) : 1-7 (Extraits). Traduction par Carine Gazier et Thomas Delahais; traduction et reproduction du texte avec l’autorisation de Palgrave Communications.]

Près des deux tiers des écoles d’Angleterre utilisent les données issues de revues systématiques pour décider de l’affectation des ressources scolaires et planifier les activités en classe. L’ONG américaine de développement, International Rescue Committee (IRC), s’est engagée à faire en sorte que tous ses programmes soient fondés sur des données probantes ou produisent des données probantes d’ici 2020. En décembre 2018, le Congrès des États-Unis a adopté la loi sur l’élaboration de politiques fondées sur des données probantes. Au Royaume-Uni et aux États-Unis, le mouvement « What Works » [Qu’est-ce qui marche/Ce qui marche] fournit des éléments de preuve quant à l’efficacité des interventions visant à améliorer l’apprentissage, à réduire la maltraitance des enfants et le nombre de sans-abris, à lutter contre la criminalité et à améliorer le bien-être.

Avons-nous atteint la vision de Donald Campbell d’une société expérimentale[1]? C’est-à-dire une société dans laquelle les choix en matière de politique sociale sont fondés sur des données tirées de recherches de haute qualité – « test par ingénierie sociale au cas par cas » (cité par Campbell, 1988). Alors que ce type d’expérimentation existe depuis les années 1930 – principalement aux États-Unis – un changement radical s’est produit ces dernières années, en partie grâce au mouvement What Works. Il est juste de parler d’une révolution de la preuve. Cette révolution a commencé il y a soixante-dix ans dans le secteur de la santé avec une médecine fondée sur des données probantes (Oliver et Pearce, 2017). Dans d’autres secteurs, tels que le développement international, l’éducation et la protection sociale, la révolution de la preuve a globalement suivi les quatre vagues décrites dans le présent commentaire. Le récit ci-après décrit fidèlement l’expérience dans le développement international. Il est axé sur ce qui a été fait, et peut être fait, pour soutenir l’utilisation des données probantes dans la prise de décision. Bien entendu, de nombreux autres facteurs influencent la prise de décision. En fin de compte, la politique est un processus politique (voir, par exemple, (Cairney, 2016 et Parkhurstm 2017), mais ces questions ne sont pas examinées plus avant ici. […]

Le présent article porte tout autant sur la demande de données probantes que sur l’offre. Il décrit des initiatives prises par les commanditaires d’activités de recherche et les utilisateurs et les utilisatrices, et pas seulement les producteurs et les productrices, ainsi que des façons de soutenir la demande. Il s’intéresse en particulier à l’institutionnalisation de l’utilisation de données probantes.

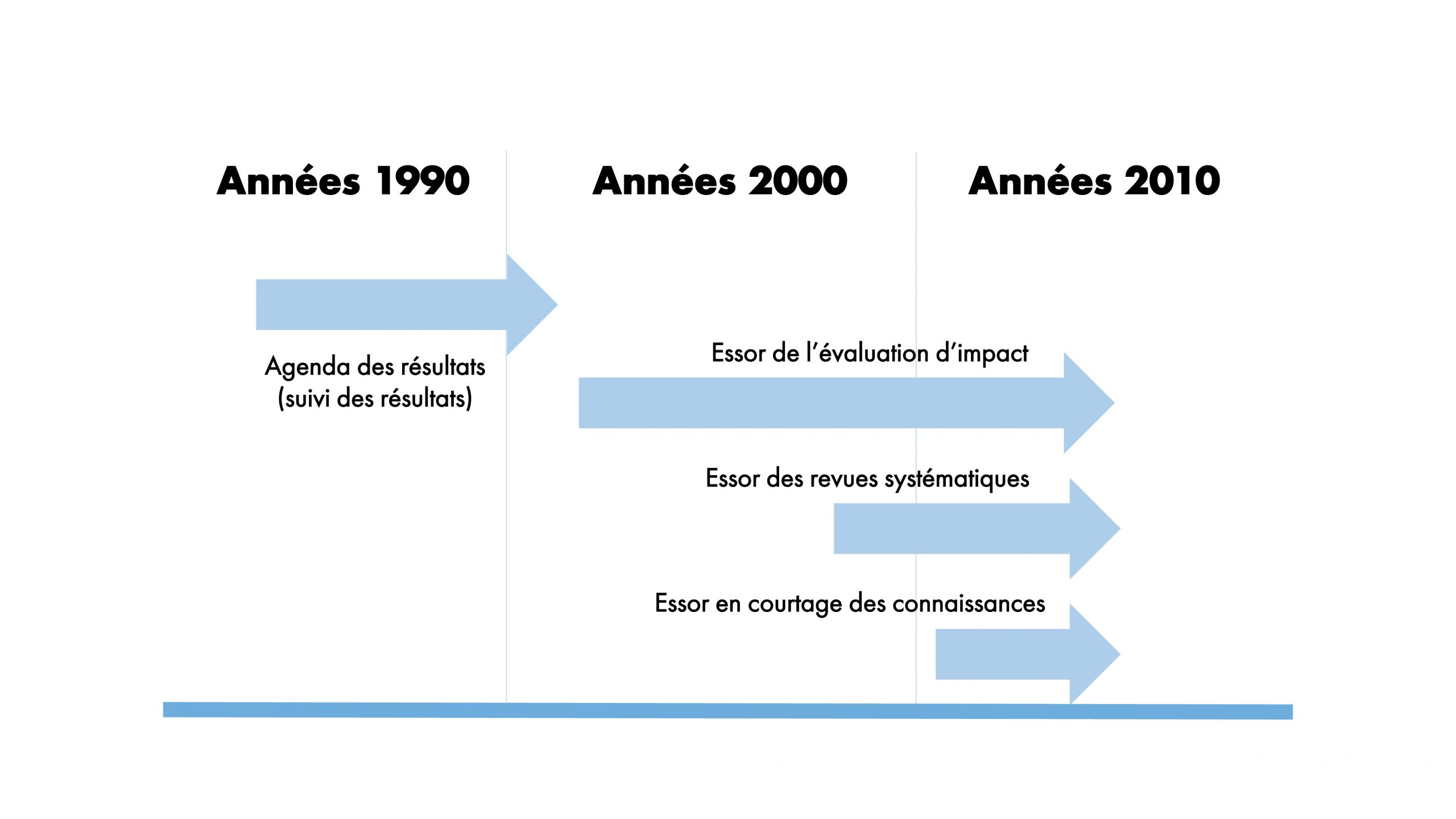

Cette institutionnalisation peut être observée dans les quatre vagues de la révolution de la preuve : (1) l’agenda axé sur les résultats, (2) les évaluations d’impact, (3) les revues systématiques et (4) le courtage en connaissances (voir figure 1). Cet article décrit l’évolution de la révolution à travers ces quatre vagues avec des exemples venant du monde entier, mais surtout de ma propre expérience dans le développement international.

Figure 1 : Les quatre vagues de la révolution de la preuve

La première vague : l’agenda des résultats, 1990

La révolution de la preuve est apparue dans le cadre de la nouvelle gestion publique qui s’est imposée dans les pays anglophones et scandinaves dans les années 1990. Parmi les faits marquants, citons le Government Performance and Results Act (GPRA) [Loi sur la performance et les résultats du gouvernement] de 1993 aux États-Unis et le Livre blanc de 1999 sur la modernisation du gouvernement au Royaume-Uni. La nouvelle gestion publique oblige les organismes gouvernementaux à rendre compte de leurs performances, telles qu’elles ressortent des tendances (résultats) de haut niveau comme le chômage, la pauvreté, etc. Ce passage à une approche axée sur les résultats a été une réalisation importante, car la performance avait été évaluée jusqu’à présent simplement en fonction des intrants tels que les sommes dépensées.

L’une des conséquences de l’accent mis sur les résultats a été une initiative pour établir de meilleurs indicateurs. Pour ne citer que deux exemples pertinents : « Indicators for Monitoring Poverty Reduction » [Indicateurs pour le suivi de la réduction de la pauvreté] (Carvalho et White, 1994) et le « Handbook of Democracy and Governance Program Indicators » [Manuel des indicateurs du programme de démocratie et de gouvernance] (Centre pour la démocratie et la gouvernance, USAID, 1999). Ces initiatives sont louables et devraient être poursuivies car le manque de cohérence des mesures qui persiste dans de nombreux secteurs fait qu’il est difficile de produire des comparaisons pertinentes des résultats obtenus par les programmes.

Plus généralement, dans le domaine du développement international, les « cadres de résultats » sont devenus communs à tous les organismes de développement. […]

Tout cela était très louable. Il n’y avait qu’un inconvénient : les « résultats » ne mesuraient pas les performances des organismes.

Les mesures de performances peuvent être évaluées en fonction des critères du triple A (alignement, agrégation et attribution[2]). Alignement : les mesures sont-elles conformes aux objectifs de l’organisme? Les mesures des résultats répondent bien à ce critère. Agrégation : les mesures peuvent-elles être agrégées à l’échelle de l’organisme pour donner un chiffre unique de sa performance? Là encore, les mesures des résultats sont efficaces. Attribution : les changements apportés à la mesure peuvent-ils être attribués aux initiatives de cet organisme? Ici, les indicateurs de résultats ne sont pas à la hauteur, comme le montre le cas de l’USAID.

En réponse à la GPRA, l’USAID a commencé à publier des rapports annuels de performance montrant les résultats en comparaison de leurs objectifs stratégiques, tels que les taux de croissance des principaux bénéficiaires de l’aide étrangère américaine. Dans son examen du rapport de performance de l’année 2000, le General Accounting Office (GAO) a écrit à l’USAID que les objectifs étaient « si larges et que les progrès étaient affectés par de nombreux facteurs autres que les programmes de l’USAID, [que] les indicateurs ne peuvent pas servir de manière réaliste à mesurer les efforts spécifiques de l’agence » (General Accounting Office, 2000). En réponse, l’USAID a abandonné l’utilisation d’indicateurs liés aux objectifs stratégiques (« résultats ») pour mesurer la performance de l’USAID.

Mon propre engagement à l’égard de ces initiatives est apparu lorsque le UK National Audit Office (NAO) m’a demandé d’entreprendre une évaluation du système de mesure de la performance du Department for Internation Development (DFID) en vue de leur propre rapport (National Audit Office, 2002; White, 2002, respectivement), qui concluait que

l’on peut se demander sur quelles données la direction du DFID fonde ses décisions. Il n’existe pas de système ‘ascendant’ pour indiquer les performances globales. Et les indicateurs liés aux objectifs du développement international incorporés dans le PSA [le cadre de résultats du DFID] n’ont que peu d’utilité opérationnelle.

Un bref résumé intitulé « Road to Nowhere » [La route vers nulle part] avertissait que l’USAID avait emprunté la voie des résultats, mais qu’elle était revenue en disant n’y avoir rien trouvé (White, 2005b). Malheureusement, cet appel n’a pas été entendu, et de nombreux organismes et gouvernements de pays en développement ont adopté des cadres de résultats, et certains continuent de le faire.

Mais il y avait aussi autre chose. Le document que j’ai rédigé pour le NAO préconisait l’utilisation de modèles logiques (ou théorie du changement) pour résoudre le problème de l’attribution. Mais il existe un autre moyen : des évaluations d’impact qui mesurent la différence que peut faire une intervention. Il existait déjà quelques études de ce type, mais le nombre d’évaluations d’impact publiées a commencé à augmenter rapidement au cours de la première décennie de ce siècle. L’utilisation de la méthode expérimentale par assignation aléatoire a été particulièrement importante et controversée. C’était la deuxième vague de la révolution de la preuve : la montée des expérimentations par assignation aléatoire.

La deuxième vague : l’augmentation des expérimentations par assignation aléatoire vers 2003

L’utilisation de la méthode expérimentale par assignation aléatoire pour les programmes sociaux n’est pas nouvelle; elle a été utilisée, principalement aux États-Unis, depuis les années 1930 (Oakley, 1998). Mais, à travers le monde, dans tous les secteurs, on observe une nette tendance à la hausse des expérimentations par assignation aléatoire et d’autres modèles d’évaluation d’impact, publié-e-s depuis le début des années 2000.

Dans le domaine du développement international, il y a eu quelques interventions des expérimentations par assignation aléatoire dans les années 1990 – la plus célèbre étant le programme de transfert monétaire conditionnel Progressa au Mexique. Toutefois, le mouvement a pris son essor au début des années 2000. Deux organisations majeures soutenant la méthode expérimentale par assignation aléatoire dans le développement – J-PAL et IPA – ont été fondées en 2003 et 2005 respectivement. Plus notable encore fut l’institutionnalisation de l’évaluation d’impact dans le cadre du Development Impact Evaluation Program [Programme d’évaluation de l’impact sur le développement] DIME, de la Banque Mondiale, en 2004, qui a fourni un financement de pré-amorçage pour soutenir la conception des interventions financées par la Banque Mondiale. Le Centre for Global Development (CGD), un think tank basé à Washington, a publié une étude influente When Will We Ever Learn? [Quand apprendrons-nous enfin?] qui reprochait à la communauté du développement de dépenser des milliards de dollars dans des programmes pour lesquels il n’existait aucune donnée probante (Levine, Savedoff, et Birdsall, 2006). La campagne du CGD a mobilisé des organismes bilatéraux et des fondations philanthropiques pour appuyer la création de l’International Initiative for Impact Evaluation [l’Initiative internationale pour l’évaluation d’impact] (3ie) en 2008. Ces efforts ont entraîné une augmentation substantielle de la production d’évaluations d’impact des interventions de développement international, une tendance qui s’est reflétée dans d’autres secteurs.

En 2008, j’ai quitté la Banque Mondiale et suis devenu le DG fondateur de 3ie. À la Banque mondiale, j’avais dirigé quatre études, mais au cours de mon séjour à 3ie, nous en avons financées près de 200. L’une de nos premières actions a été la création d’une base de données des évaluations d’impact sur le développement. Elle contient désormais près de 5 000 études d’évaluations d’impact. En 2003, moins de 50 évaluations d’impact étaient publiées chaque année, contre plus de 500 en 2012. […]

Les résultats issus de cette explosion d’évaluations d’impact ont montré l’importance de mener de telles études. Il semble qu’il existe en général une règle de 80 % : 80 % des choses ne fonctionnent pas – c’est-à-dire ont des résultats positifs faibles ou nuls.

Une étude de la Commission européenne a révélé que 85 % des projets financés dans le cadre du Mécanisme de développement propre étaient en réalité peu susceptibles d’entraîner des réductions supplémentaires des émissions de carbone (Cames et al., 2016). L’ONG altruiste basée à Oxford, 80 000 h, a conclu que 80 % était probablement un chiffre généreux – il est plus probable qu’un pourcentage plus élevé de choses ne fonctionnent pas (Todd et The 80,000h team, 2017). Ainsi, en bon-ne-s Bayésiens et Bayésiennes, en l’absence de preuve du contraire provenant d’une évaluation rigoureuse, nous devrions supposer que notre programme ne fonctionne pas.

Les agences de développement les plus axées sur les données probantes – comme le Département du développement international britannique (DFID) et la Fondation Bill et Melinda Gates – exigent une déclaration de preuves issue d’études rigoureuses pour appuyer les nouvelles propositions et, dans le cas du DFID, la façon dont l’activité proposée permettra de recueillir les preuves nécessaires si elles n’existent pas déjà.

Étant donné que tant de choses ne fonctionnent pas, une évaluation rigoureuse constitue un excellent rapport qualité-prix. L’évaluation du programme mexicain de transfert monétaire conditionnel, Progessa, au milieu des années 90, a coûté 2 millions de dollars. L’évaluation a révélé des effets importants sur l’éducation, la santé, la nutrition et la pauvreté, générant un soutien politique pour le programme qui a ainsi survécu aux transitions politiques. En supposant généreusement que sans l’évaluation, les fonds auraient été utilisés pour un programme deux fois moins efficace, l’utilisation des résultats de l’évaluation a permis à 550 000 enfants supplémentaires de passer à l’école secondaire et à 800 000 enfants âgés de 12 à 36 mois de réduire leur retard de croissance entre 2000 et 2006[3].

Avec tant d’études, il devient difficile de rester au fait des dernières avancées de la littérature. De toute façon, il est peu probable que les décideurs et les décideuses lisent des articles universitaires; mais ils et elles peuvent être influencé-e-s par les résultats d’études très médiatisées. Or, la prise de décision devrait se fonder sur une évaluation de l’ensemble des preuves et non sur des études isolées.

Je prends un exemple, certes controversé, pour illustrer ce point : le déparasitage à l’école.

Une étude influente réalisée au Kenya montre les effets importants du déparasitage sur la nutrition, la santé et l’éducation (Miguel et Kremer, 2004). Cette étude en particulier a influencé le mouvement Deworm the World [Déparasitons le monde]. Cependant, comme le rapportent les revues systématiques Cochrane (Taylor-Robinson et al., 2015) et Campbell (Welch et al., 2016), la grande majorité des études ne démontrent pas de tels effets. L’exceptionnalisme africain est une énigme. Similairement, la conception qui aiderait à imaginer et cibler les programmes de manière rentable est un casse-tête. Mais pour la plupart des pays du monde, il semble que le déparasitage ne soit pas « le meilleur achat en matière de développement », comme le prétendent certains – nous ne devrions pas être induits en erreur par une seule étude ou par un petit nombre d’études lorsqu’il y a un plus grand nombre de publications.

La troisième vague : l’essor des revues systématiques, 2008

Cette nécessité de s’appuyer sur des éléments de preuve a alimenté la troisième vague de la révolution de la preuve : l’essor des revues systématiques. Dans la plupart des secteurs, cette vague a eu lieu au cours des dix dernières années. Cette vague est arrivée plus tôt dans le domaine de la santé, posant les bases de la médecine fondée sur des preuves, sous l’impulsion de la Cochrane Collaboration [Coopération Cochrane] et de l’Organisation Mondiale de la Santé (OMS). D’autres secteurs ont suivi plus récemment.

Une fois encore, cette vague concerne tous les pays et tous les secteurs. Dans le domaine de la politique sociale, peu de revues systématiques ont été publiées avant l’année 2000, environ 25 par an dans les années 90, puis le chiffre a augmenté dès 2010 pour atteindre 230 en 2016[4]. 3ie a joué un rôle dans l’essor des revues systématiques dans le domaine du développement international. […]

Certaines revues confirment la vision plutôt pessimiste relative à l’efficacité des programmes. La première étude de Campbell a montré que les programmes Scared Straight accroissent en fait la probabilité que les jeunes deviennent des criminels (Petrosino et al., 2013). Un examen des programmes visant à lutter contre les grossesses adolescentes a révélé qu’aucun n’était efficace pour réduire l’activité sexuelle ou les grossesses (Scher, Maynard, et Stagner, 2006).

J’ai quitté 3ie en 2015 pour prendre la direction de Campbell vers la fin de cette année-là. Soutenir la production de revues est l’activité principale de Campbell. Une première étape a été la mise en place d’une nouvelle stratégie comportant deux objectifs clés : davantage de revues et plus d’utilisation de ces dernières.[…]

La difficulté à promouvoir l’utilisation des revues systématiques est dû au fait qu’il s’agit de documents longs et techniques. Ils peuvent également ne pas être accessibles facilement et difficiles à trouver – ou être payants – ou encore difficiles à comprendre. Une revue sur un thème large peut atteindre plusieurs centaines de pages. Et les implications pour les politiques ne sont peut-être pas toujours claires. L’intégration des conclusions des études dans les politiques et les pratiques a constitué la quatrième vague de la révolution de la preuve : le courtage ou la traduction des connaissances.

La quatrième vague : l’essor du courtage en connaissances, 2010

Les activités de la quatrième vague visent à institutionnaliser l’utilisation des données probantes dans les politiques et les pratiques. Il y a deux façons de le faire : l’interaction directe – que j’appelle le modèle nordique – et la création de produits de connaissance comme les portails de données probantes – tel que le mouvement What Works. Bien que certaines de ces initiatives soient antérieures à la décennie en cours, c’est cette dernière qui a permis à What Works de prendre l’élan nécessaire pour être qualifié de mouvement.

Le Danemark, la Norvège et la Suède disposent chacun de « centres de connaissances » pour l’éducation, la santé et la protection sociale. Il s’agit de centres de recherche financés par le gouvernement. Ce qui est différent dans le modèle nordique, c’est qu’ils disposent d’un personnel dont le travail quotidien consiste à produire des études destinées à éclairer la prise de décision gouvernementale. Il ne s’agit pas de chercheurs et de chercheuses universitaires dont la motivation est de publier. Ce sont plutôt des chercheurs et des chercheuses dont la motivation est de produire des revues systématiques pertinentes pour la politique et la pratique. Les équipes de recherche se réunissent régulièrement avec les organismes gouvernementaux pour convenir des sujets prioritaires et discuter des résultats qui émergent et de la façon dont ils devraient être interprétés à des fins politiques. Ce modèle est également couramment ajusté par des équipes qui fournissent des réponses rapides issues de données probantes plutôt que des revues systématiques complètes dont le nombre augmente.

Le modèle d’interaction directe peut fonctionner lorsque l’on a affaire à un petit nombre de décideurs et de décideuses, par exemple au sein du gouvernement central ou d’un seul organisme. Il est moins adapté lorsque la prise de décision est décentralisée. Le cas échéant, les produits probants doivent pouvoir être utilisés par les décideurs et les décideuses sans nécessiter aucun soutien.

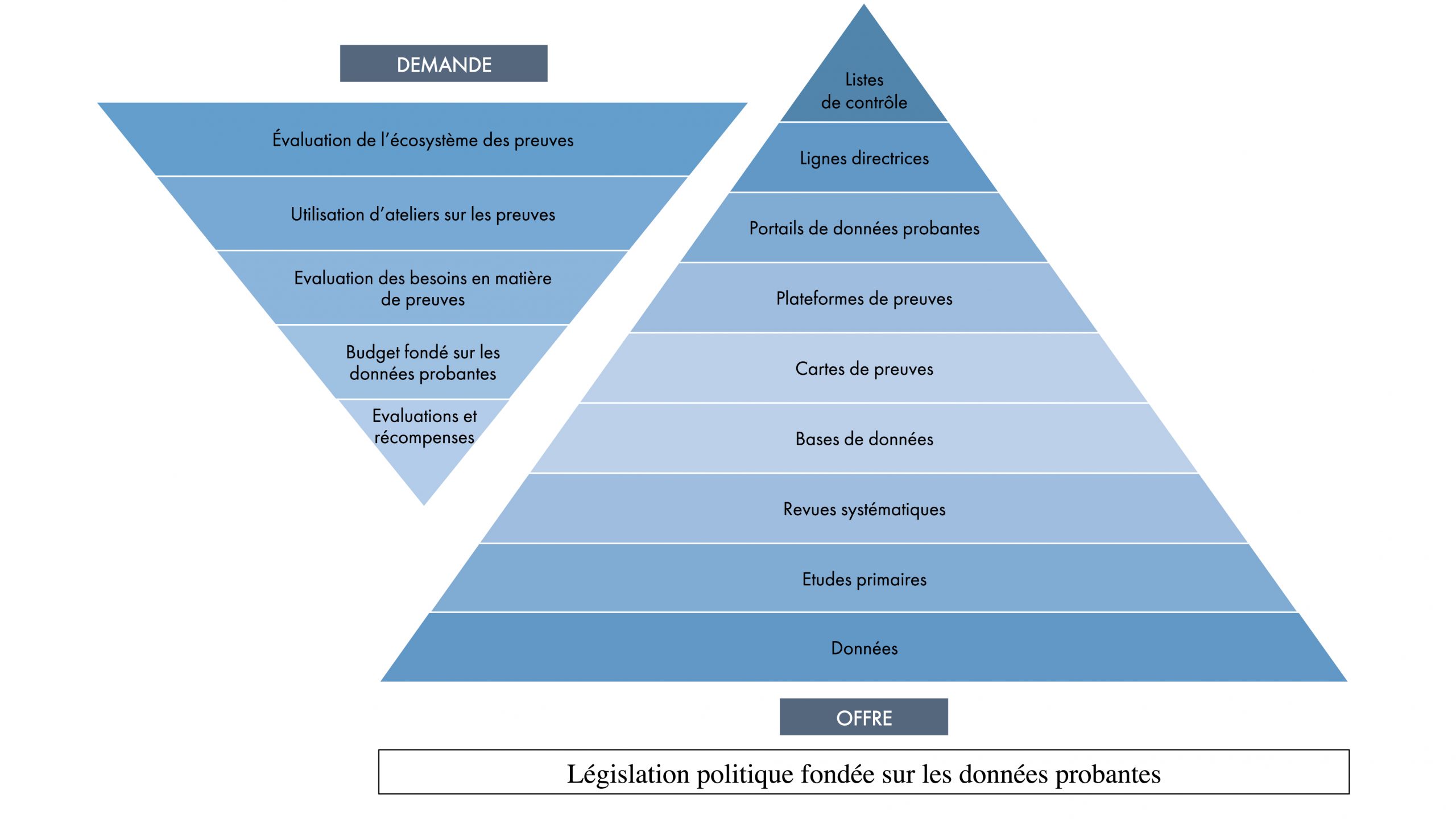

Figure 2 : L’architecture de la preuve

Mais cette approche se répand. J’y vois la véritable manifestation de la quatrième vague : la construction de l’architecture de la preuve afin d’institutionnaliser l’utilisation de cette dernière. Cette architecture est illustrée à la figure 2. L’institutionnalisation peut être étayée par une législation exigeant que la conception de politiques publiques se fonde sur des données probantes, comme celle adoptée aux États-Unis en décembre 2018 ou la loi mexicaine de 2004 sur le développement social, qui exigeait une évaluation externe de tous les programmes sociaux financés par l’État. Une telle législation exige que les organismes financés par l’État produisent et utilisent des évaluations rigoureuses. […]

Au Royaume-Uni, le National Institute of Clinical Excellence and Social Welfare [Institut national de l’excellence clinique et du bien-être social] (NICE) a recours à des revues systématiques tant pour donner des orientations que pour prendre des décisions sur les dépenses éligibles aux dépenses publiques du National Health Service [Service national de santé]. Divers centres britanniques What Works ont commencé à produire des lignes directrices, comme celles sur l’utilisation d’assistants et d’assistantes pédagogiques de l’Education Endowment Foundation (Sharples, Webster, et Blatchford, s. d.) et les lignes directrices de la police de quartier relatives à ce qui marche pour réduire la criminalité (College of Policing, 2018).

Atul Gawande a plaidé avec éloquence en faveur des listes à cocher dans The Checklist Manifesto (Gawande, 2011). Gawande explique comment l’utilisation d’une liste de validation a permis de réduire les « erreurs d’inaptitude » (incapacité à utiliser ce que nous savons) dans tous les domaines, du pilotage des avions à la construction de gratte-ciel. Une telle approche peut-elle fonctionner dans d’autres secteurs? L’expérience des principaux courtiers et courtières en connaissances du mouvement What Works suggère que oui.

Le Teaching and Learning Toolkit [guide d’enseignement et d’apprentissage] présente des données probantes sur 34 interventions différentes, telles que les cours particuliers. La page d’accueil du guide énumère les 34 interventions avec trois paramètres simples : le coût (indiqué sur une échelle d’un à cinq signes £), la force des éléments probants (indiquée sur une échelle d’un à cinq cadenas) et l’impact. L’impact est indiqué comme le nombre de mois de progrès supplémentaires qu’un-e élève fait lorsqu’il est exposé à cette intervention. Il est de + 5 pour les cours particuliers, ce qui signifie qu’un cours particulier a permis, en moyenne, de réaliser des progrès supplémentaires équivalents à cinq mois d’apprentissage. Le meilleur achat consiste à faire aux enfants un retour sur leur travail. Cela coûte très peu et équivaut à 8 mois de progrès supplémentaires. Le « pire achat » consiste à redoubler une année, ce qui coûte très cher, alors que l’enfant a tendance à faire moins de progrès que s’il n’y avait eu aucune intervention.

Les éléments de preuve présentés dans le guide sont basés sur 34 revues systématiques commandées par l’EEF. Une étude réalisée par le NAO en 2015 a révélé que 64 % – soit près des deux tiers – des écoles utilisaient le guide pour prendre des décisions au sujet des ressources scolaires et des pratiques en classe (National Audit Office, 2015 : 9). En d’autres termes, deux tiers des écoles en Angleterre utilisent des données probantes provenant de revues systématiques pour éclairer leur prise de décision. Tel est le pouvoir d’un courtage en connaissances efficace. […]

Une chose que nous avons apprise des évaluations effectuées dans de nombreux secteurs est que la création de l’offre est rarement suffisante par elle-même – il faut également prêter attention à la demande. La loi de Say selon laquelle l’offre crée sa propre demande ne semble pas s’appliquer dans de nombreux cas, et la promotion de l’utilisation des preuves ne fait pas exception. Ainsi, comme le suggère la figure 2, si nous devons construire le côté offre de l’architecture des preuves, nous devons également tenir compte du côté demande. Ceci est d’autant plus important que les incitations académiques soutiennent l’offre de données probantes issues de la recherche, mais ne récompensent généralement pas les initiatives pour que ces données soient utilisées dans les politiques. […]

Le rôle de l’IA, de l’apprentissage automatique et du Big Data : une cinquième vague?

Les nouvelles technologies offrent un grand potentiel pour étendre la production et l’utilisation de preuves rigoureuses. Le Big Data offre des possibilités de collecte de données pour la mesure de l’impact; par exemple en combinant des données satellitaires et des données pluviométriques pour évaluer les interventions agricoles, ou des données provenant d’appareils de fitness portatifs pour évaluer l’impact des interventions sanitaires ou pour mesurer l’effort de travail des travailleurs ruraux et des travailleuses rurales.

Il est également possible d’améliorer la production de revues systématiques. Des programmes, tels que Rayyan et EPPI Reviewer, proposent l’apprentissage automatique pour aider à la sélection d’articles pertinents en vue de leur inclusion dans une revue. Cochrane Crowd et Aidgrade utilisent le crowdsourcing sur le Web pour filtrer et coder des documents avec une méta-analyse automatisée dans le dernier cas. La technologie est déjà disponible pour des revues automatisées toujours à jour, car les algorithmes explorent les bases de données à la recherche d’études pertinentes, mettant à jour les cartes et les revues au fur et à mesure qu’ils les trouvent. L’élément humain peut intervenir lorsque la discrétion ou le jugement d’une experte ou d’un expert est nécessaire, comme dans la production de lignes directrices. Mais le fait que des êtres humains parcourent des articles à la recherche de textes pertinents à inclure est probablement un moyen très inefficace de produire des revues. L’adoption de ces technologies améliorera la rapidité et l’exactitude de la synthèse des preuves.

Il y a aussi des risques. Les machines sont aussi intelligentes que les gens qui sont leur matériau d’apprentissage. Et l’analyse du Big Data doit s’appuyer sur une compréhension technique des relations de causalité. Corrélation n’est pas causalité, quelle que soit la taille des données (Elliot et al., 2015). Mais il s’agit là de risques gérables dont les avantages l’emportent sur les risques.

Dernier mot : la preuve est le meilleur moyen d’accéder au développement

La plupart des interventions ne fonctionnent pas, la plupart des interventions ne sont pas évaluées et la plupart des évaluations ne sont pas utilisées. En conséquence, des milliards de dollars provenant de gouvernements et de dons sont gaspillés dans des programmes inefficaces. Financer la recherche sur ce qui fonctionne est le meilleur investissement que nous puissions faire. Joignez-vous à la révolution de la preuve aujourd’hui.

Bibliographie

Boruch, Robert. 2019. in SAGE research methods foundations, édité par S. Delamont, P. Atkinson, et A. Cernat. London: Sage Publications.

Cairney, Paul. 2016. The politics of evidence-based policy making. London: Palgrave MacMillan.

Cames, Martin et al. 2016. « How additional is the clean development mechanism? Analysis of the application of current tools and proposed alternatives ».

Campbell, Donald T. 1969. « Reforms as experiments ». American Psychologist 24(4) : 409‑29. doi: https://doi.org/10.1037/h0027982.

Campbell, Donald T. 1988. « The experimenting society ». in Methodology and epistemology for the social science, édité par E. S. Overman. Chicago: University of Chicago Press.

Carvalho, Soniya, et Howard White. 1994. « Indicators for poverty reduction. World Bank Discussion Paper 254 ».

College of Policing. 2018. « Neighborhood policing guidelines ».

Elliot, Julian H., Jeremy Grimshaw, Russ Altman, Lisa Bero, Steve N. Goodman, David Henry et al. 2015. « Making sense of health data ». Nature 527(7576) : 31‑32. doi : https://doi.org/10.1038/527031a.

Gawande, Atul. 2011. The checklist manifesto: how to get things right. London: Profile Books.

General Accounting Office. 2000. « Observations on the US Agency for International Development’s Fiscal Year 1999 Performance Report and Fiscal Years 2000 and 2001 Performance Plans ».

Levine, Ruth, William D. Savedoff et Nancy Birdsall. 2006. « When will we ever learn: improving lives through impact evaluation ».

Miguel, Edward, et Michael Kremer. 2004. « Worms: Identifying Impacts on Education and Health in the Presence of Treatment Externalities ». Econometrica 72(1) : 159‑217.

National Audit Office. 2002. « Department for international development performance management—helping to reduce world poverty ».

National Audit Office. 2015. « Funding for disadvantaged pupils ».

Oakley, Ann. 1998. « Experimentation and social interventions: a forgotten but important history ». BMJ 317(7167) : 1239‑42. doi : https://dx.doi.org/10.1136%2Fbmj.317.7167.1239.

Oliver, Kathryn, et Warren Pearce. 2017. « Three lessons from evidence-based medicine and policy : increase transparency, balance inputs and understand power ». Palgrave Commun 3(43). doi : https://doi.org/10.1057/s41599-017-0045-9.

Parkhurst, Justin. 2017. The Politics of Evidence From evidence-based policy to the good governance of evidence. 1re éd. London: Routledge.

Petrosino, Anthony, Carolyn Turpin-Petrosino, Meghan E. Hollis-Peel et Julia G. Lavenberg. 2013. « Scared straight and other juvenile awareness programs for preventing juvenile delinquency: a systematic review ». Cochrane Database of Systematic Reviews 2013(5). doi : 10.1002/14651858.CD002796.pub2.

Scher, Lauren Sue, Rebecca A. Maynard et Matthew Stagner. 2006. « Interventions intended to reduce pregnancy related outcomes among adolescents ». Cochrane Database of Systematic Reviews 2(1) : 1‑70. doi : https://doi.org/10.4073/csr.2006.12.

Sharples, Jonathan, Rob Webster et Peter Blatchford. s. d. « Making best use of teaching assistants: guidance report ».

Taylor-Robinson, David C., Nicola Maayan, Karla Soares-Weiser, Sarah Donegan et Paul Garner. 2015. « Deworming drugs for soil-transmitted intestinal worms in children: effects on nutritional indicators, haemoglobin, and school performance ». Cochrane Database Syst Rev 2015(7). doi : 0.1002/14651858.CD000371.pub6.

Todd, Benjamin et The 80,000h team. 2017. « Is it fair to say that most social programmes don’t work? » Consulté (https://80000h.org/articles/effective-social-program/).

Welch, Vivian A., Elizabeth Ghogomu, Alomgir Hossain, Shally Awasthi, Zulfi Bhutta et al. 2016. « Deworming and adjuvant interventions for improving the developmental health and well-being of children in low and middle-income countries: a systematic review and network metaanalysis ». Cochrane Database of Systematic Reviews 12(1) : 1‑383. doi : https://doi.org/10.4073/csr.2016.7.

White, Howard. 2002. « A drop in the ocean? The International Development Targets as a basis for performance measurement. Appendix 2 in NAO ».

White, Howard. 2005. « The road to nowhere: results-based management in international cooperation ». in Why did the chicken cost the road? And other stories on development evaluation, édité par S. Cummings. Amsterdam: KIT Publishers.

- La vision de Campbell pour la société expérimentale est exposée dans Campbell (1969). La contribution complète de Campbell à un éventail de disciplines peut être lue dans Boruch (2019). ↵

- Les critères du Triple A ont été proposés dans mon examen de la mesure des performances des organismes de développement présenté dans White (2015a). ↵

- Communication personnelle de Bill Savedoff. ↵

- Résultats de la recherche Google Scholar : « revues systématiques » ET sociaux EN Title. Résultats passés au crible jusqu’à cinq pages consécutives sans études éligibles. Recherche effectuée le 12 septembre 2018. ↵