14 L’analyse des processus de mise en œuvre

Une intervention complexe au Burkina Faso : le financement basé sur les résultats

Valéry Ridde et Anne-Marie Turcotte-Tremblay

| Définition de la méthode

L’analyse de la mise en œuvre vise à comprendre comment un ou plusieurs processus organisés dans un contexte particulier participent aux changements souhaités par une intervention au regard des moyens déployés. |

Forces de la méthode

|

Défis de la méthode

|

« Nous savons ce qu’il faut faire, mais nous ne savons pas comment le faire » : voici une phrase qui semble se retrouver de manière récurrente dans les rapports des acteurs et actrices de la santé mondiale depuis longtemps. En 2010 par exemple, les Nations Unies affirmaient que pour s’occuper de la santé des femmes et des enfants « nous savons ce qui fonctionne [1]» (United Nations Secretary-General 2010). Pourtant, si le contenu des interventions théoriquement efficaces est relativement bien connu, leur niveau de couverture reste faible (Peters et al. 2009). De plus, les conditions de leur mise en œuvre sont très peu appréhendées. Une méta-analyse montre que l’efficacité théorique des interventions est réduite de 50 % à cause de multiples facteurs contextuels agissant sur la mise en œuvre (J. A. Durlak et DuPre 2008). Ainsi, il ne suffit pas de savoir si une intervention de santé mondiale est efficace dans un environnement contrôlé (efficacité théorique : efficacy), il faut aussi comprendre pourquoi elle fonctionne, comment, pour qui et dans quels contextes réels (efficacité pratique : effectiveness). C’est ici que la science de la mise en œuvre (implementation science) est d’un secours indéniable. Elle est définie comme un champ de recherche visant à comprendre les « facteurs associés à une mise en œuvre efficace » (Franks et Schroeder 2013). L’efficacité de la mise en œuvre nous renvoie à la capacité de l’intervention à organiser les activités essentielles à l’atteinte de ses objectifs, mais aussi, et peut-être surtout, à sa capacité à s’adapter aux acteurs et actrices et aux contextes tout au long de son histoire (Ridde, Delormier et Gaudreau 2007).

Pour reprendre les termes d’un auteur important de ce champ : « étudier la mise en œuvre des interventions n’est pas facile, mais est essentiel » (Durlak 2015b). Dans une revue des écrits sur le concept, Pfadenhauer et ses collègues (2015) définissent la mise en œuvre comme « un effort initié de manière délibérée et activement planifié dans l’intention de mettre en pratique un objet spécifique ». Dans ce livre sur les méthodes d’évaluation des interventions de santé mondiale et pour ce chapitre, la mise en œuvre est comprise comme un ou plusieurs processus organisés dans un contexte particulier afin de participer aux changements souhaités par une intervention (au sens large du terme : politique, programme, projet) au regard de ses moyens déployés. La mise en œuvre peut se distinguer de l’implantation, que certains considèrent comme un anglicisme, dans le sens où cette dernière est plus normative ou plus « simple » alors que la première est véritablement complexe et dynamique. L’évaluation de l’implantation sera utile pour vérifier que les activités ont été organisées tel que prévu (analyse de la conformité) tandis que l’évaluation des processus permettra d’en comprendre la mise en œuvre, sa complexité, le rôle des acteurs et actrices sociaux et du contexte.

La science de la mise en œuvre vise donc à mobiliser des théories, concepts et méthodes pour mieux « comprendre quoi, qui et comment une intervention fonctionne dans un contexte réel » (Peters et al. 2013). Il n’existe évidemment pas de « contexte irréel », mais nous souhaitons ici plutôt faire référence au contexte naturel de mise en œuvre d’une intervention (Petticrew et al. 2005) comparativement à des contextes où les chercheuses et chercheurs et les intervenant-e-s tentent de contrôler les situations (le contexte et l’action) pour en prouver l’efficacité, usant souvent d’une approche expérimentale et de devis tels que les essais contrôlés randomisés.

On s’éloigne donc dans ce chapitre du concept de « Implementation Research », souvent impossible à traduire[2] et qui concerne surtout l’analyse de la manière dont les interventions tiennent compte et intègrent des données probantes dans la formulation de leur contenu (Nilsen et al. 2013). La revue Implementation Science en est l’étendard, même si, en utilisant ce titre, elle apporte une confusion supplémentaire dans un domaine qui n’en avait pas besoin. De plus, ce champ est aussi proche de celui du transfert des connaissances, lui aussi très peu développé dans les pays du Sud (Siron, Dagenais et Ridde 2015). Cependant, nous sommes d’accord avec le fait que « les recherches dans ces deux champs s’intéressent aux défis de concrétiser des intentions en changements souhaités » (Nilsen et al. 2013).

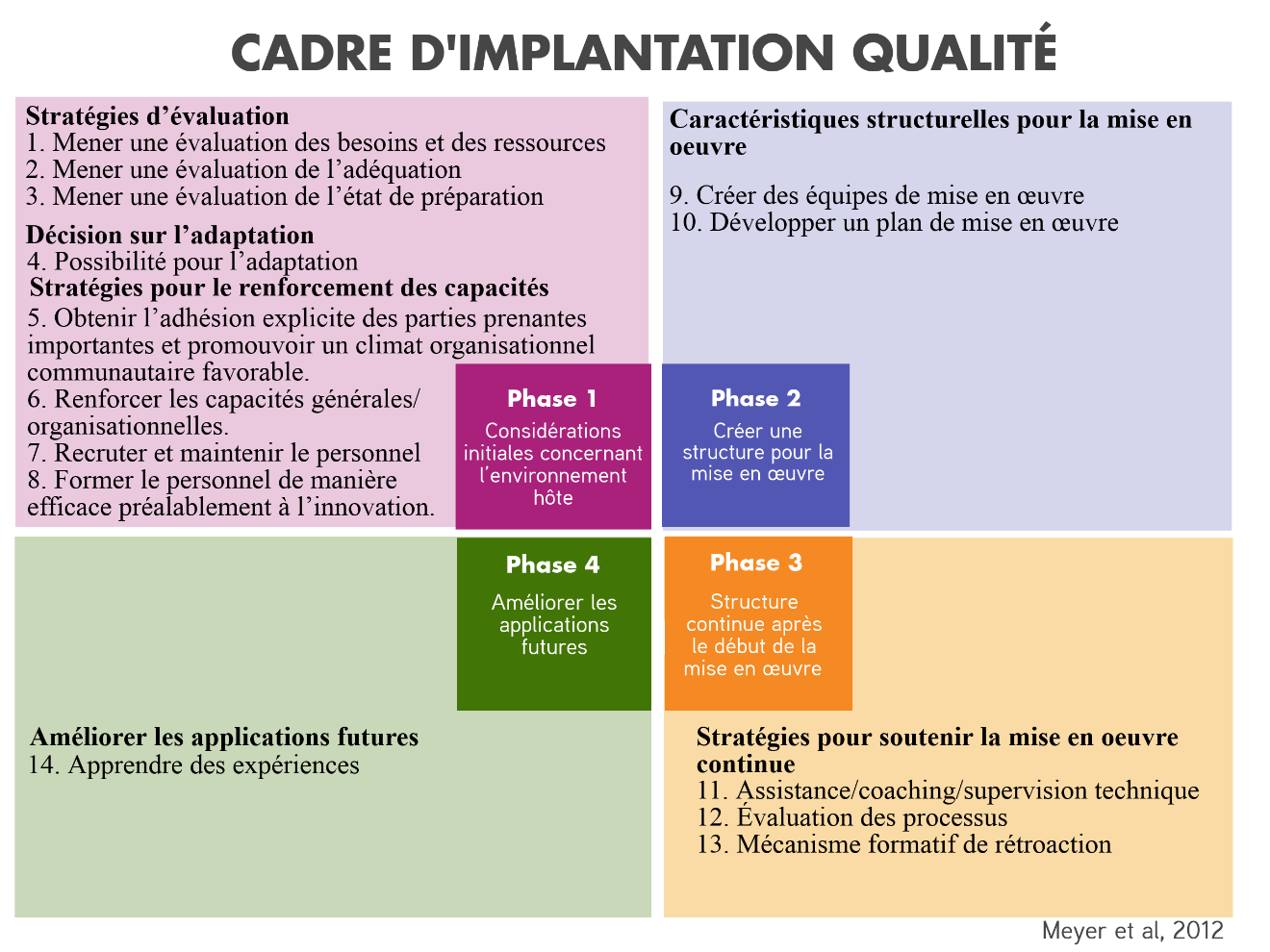

Dans ce chapitre, nous nous intéressons donc aux processus de mise en œuvre des interventions. Cependant, les recherches sur les processus de mise en œuvre en santé mondiale doivent mieux exploiter les théories, les cadres conceptuels et les approches des sciences sociales (Van Belle, van de Pas et Marchal 2017). Par exemple, Durlak propose une synthèse intéressante en suggérant huit domaines d’étude qui reprennent les fameux « implementation outcomes » de Proctor et al. (2011) : acceptabilité, adoption, pertinence, faisabilité, fidélité, coût, couverture, pérennité. Il suggère aussi 23 facteurs influençant la mise en œuvre et 14 étapes dont il faut s’inspirer pour mettre en œuvre une intervention (Joseph A. Durlak 2015a; Figure 1). Si les approches inductives et empiriques sont essentielles pour faire émerger des discours et repérer des pratiques efficaces, le recours aux développements théoriques et conceptuels l’est tout autant (Olivier de Sardan et Ridde 2015), car il permet une approche plus systématique et plus globale ainsi qu’une meilleure organisation des données pour en faciliter l’analyse et la présentation.

Rappelons que parmi les études de promotion de la santé qui analysent les politiques publiques, seules 18 % font référence à un cadre théorique de ce champ (Breton et De Leeuw 2011). Des travaux ont montré, par exemple, que la théorie des courants de Kingdon (Ridde 2009), celle des acteurs et actrices de première ligne de Lipsky (Walt et al. 2008) ou encore celle de l’innovation de Rogers (Perez et al. 2013), toutes développées aux États-Unis, peuvent être adaptées au contexte de certains pays du Sud pour comprendre la mise en œuvre. En outre, le rôle des idées dans la mise en œuvre (contrairement à l’émergence) des interventions dans les pays du Sud n’a encore que très peu été abordé (Béland et Ridde 2016), alors que les écrits à cet égard dans les pays du Nord sont légion (Cox 2001).

La science de la mise en œuvre ne peut évidemment pas se développer seule, sans considérer les effets des interventions (ou les principes d’efficacité, pour reprendre les termes de Patton [2010]), au risque de tomber dans l’erreur de type trois, où l’on évalue une intervention alors qu’elle n’a pas été mise en œuvre tel que prévu (Dobson et Cook 1980). Il est important, par exemple, de mieux décrire le contenu des interventions ainsi que de rendre compte de la (classique pour les épidémiologistes) fidélité et de l’intensité de l’implantation (voir le chapitre de Perez et al.).

Ainsi, il est temps de prendre au sérieux la demande formulée il y a 10 ans en ce qui concerne les pays du Sud : « plus de recherches sur la mise en œuvre et spécialement les défis de la mise en œuvre des interventions qui visent plus d’équité » (Gilson et Raphaely 2008). C’est donc dans ce contexte que nous avons réalisé une analyse de la mise en œuvre d’une intervention complexe au Burkina Faso que nous décrivons dans la prochaine section.

Contexte et programme évalué

Depuis plusieurs années en Afrique, de nombreux pays se sont lancés dans des interventions de financement basé sur les résultats (FBR) pour améliorer la performance des systèmes de santé. Il existe de nombreux modèles de FBR, mais dans ce chapitre nous décrivons celui promu par la Banque Mondiale au Burkina Faso. Dans ce contexte, il s’agit de lier le financement des formations sanitaires et le paiement de primes au personnel de la santé à l’atteinte d’indicateurs de quantité et, souvent, de qualité des soins, préalablement définis. Ces indicateurs sont l’objet d’un processus de contrôle par des acteurs et actrices externes à la formation sanitaire. Les preuves scientifiques de l’efficacité ou de l’efficience du FBR restent limitées au Nord (Milstein et Schreyoegg 2016) comme au Sud (Turcotte-Tremblay et al. 2016 ; Witter et al. 2012). Les recherches sur sa mise en œuvre sont encore très rares en Afrique de l’Ouest francophone (Paul, Sossouhounto, et Eclou 2014). Elles ont des méthodes et des résultats très variables, mais confirment toutes le manque de connaissances à l’égard de la mise en œuvre du FBR en Afrique.

Au Burkina Faso, après un projet pré-pilote dans trois districts, le ministère de la Santé et la Banque Mondiale ont déployé une intervention FBR dans 12 districts supplémentaires en janvier 2014. Le Burkina Faso a décidé d’innover en y associant des stratégies destinées à améliorer l’équité et soutenir l’accès aux soins des plus pauvres. Ainsi, dans 10 districts, un processus de sélection communautaire des indigent-e-s leur permettant d’être exemptés du paiement des soins a été organisé dans certains centres de santé sélectionnés de façon aléatoire. Deux autres districts organisent une assurance maladie à base communautaire associée à l’exemption du paiement des indigents. Tou-te-s les patient-e-s continuent de payer les soins au point de service sauf les indigent-e-s qui en sont exempté-e-s ou les femmes enceintes dont les accouchements sont subventionnés (80 %) par l’État depuis 2006 et gratuits depuis 2016. Rédigé avec le soutien de consultants de la Banque Mondiale, un guide de mise en œuvre de l’intervention de plus de 300 pages est disponible.

Une unité centrale appelée le Service Technique FBR (ST-FBR) a été créée pour appuyer la mise en œuvre du FBR à travers l’élaboration et le suivi des indicateurs, la supervision des vérifications, l’organisation d’ateliers de formation et l’analyse de données de performance. Des agences de contractualisation et de vérification (ACV) ont été mises en place pour vérifier les résultats quantitatifs des formations sanitaires, accompagner les agent-e-s de santé dans l’utilisation des outils du FBR, saisir les données et soumettre les factures des formations sanitaires pour validation. Les ACV effectuent les vérifications quantité mensuellement pour compter le nombre de prestations ciblées effectuées (~23 indicateurs). Les vérifications qualité sont effectuées trimestriellement sur plusieurs dimensions de la qualité des soins telles que les conditions d’accueil des patient-e-s, la disponibilité du matériel, la tenue des supports, la gestion des médicaments et la gestion financière (~104 indicateurs). Cette dernière requiert la collaboration des membres des comités de gestion (COGES) des formations sanitaires en raison de leur implication dans la trésorerie du Centre de Santé et de Promotion Sociale (CSPS). Divers outils (par exemple, un plan d’amélioration de la performance, outil d’indice) sont mis en place pour promouvoir la planification des activités et des finances. Les indicateurs de quantité sont achetés à des prix unitaires fixes et ceux pour la qualité le sont en fonction d’une cible minimale à atteindre.

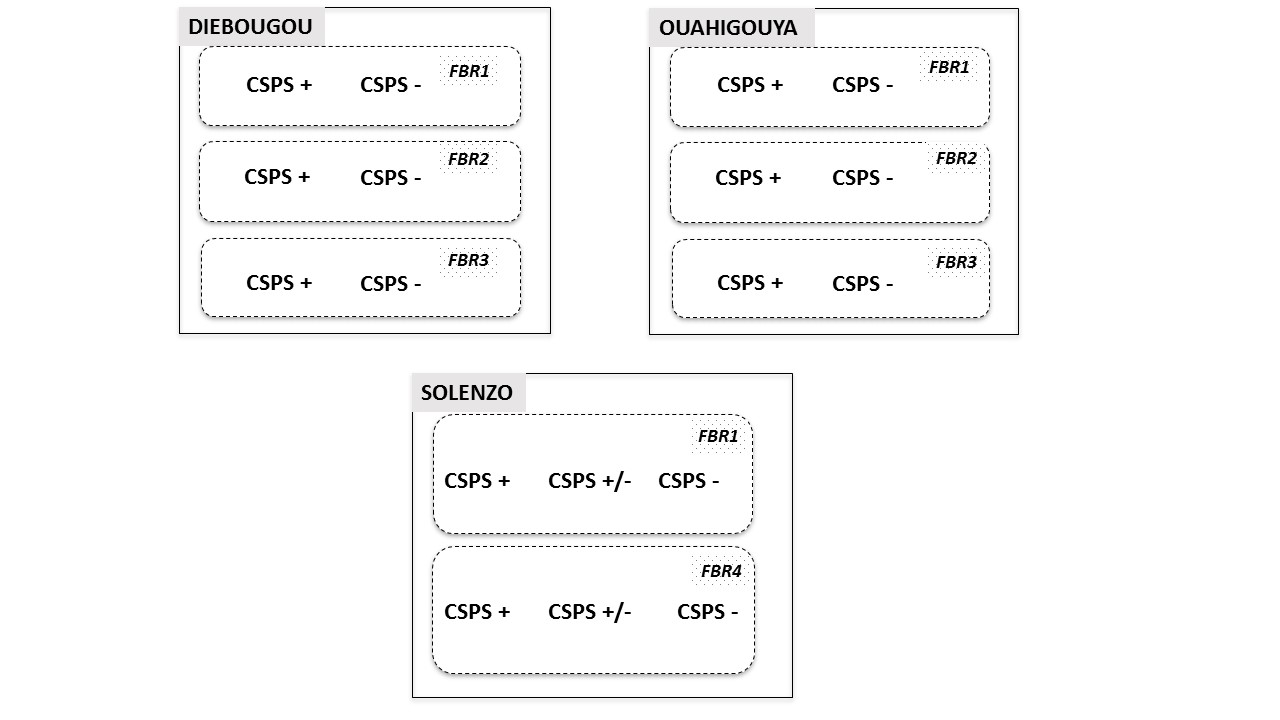

L’organisation du FBR a été conçue pour faciliter son évaluation d’impact financée par la Banque mondiale selon un essai contrôlé randomisé des structures de première ligne, à savoir les CSPS. Quatre catégories de randomisation, comme autant de bras d’intervention, sont définies : (i) FBR 1 : le centre de santé est payé pour les indicateurs d’activités atteints sur la base de prix fixés, mais qui peuvent fluctuer au cours du projet ; (ii) FBR 2 : le FBR 1 couplé à une intervention de sélection communautaire des indigent-e-s exempté-e-s du paiement des soins dont l’achat est effectué à un prix modéré ; (iii) FBR 3 : le FBR 2 à un prix d’achat plus élevé pour les indigent-e-s visant à encourager les initiatives innovantes pour augmenter leur utilisation des services ; (iv) FBR 4 : FBR 1 associé à une assurance maladie à base communautaire couplée à une intervention de sélection communautaire des indigent-e-s. Cette dernière composante du FBR est mise en œuvre uniquement dans une seule région sanitaire.

Pour les quatre modalités, un « bonus équité » a été mis en place entre les districts et les centres de santé. Ainsi, les prix d’achats varient sensiblement pour les centres de santé au sein de ces quatre catégories. Ces prix ont été calculés afin de notamment tenir compte de l’éloignement des centres de santé du chef-lieu du district et les besoins en ressources. Par exemple, une consultation curative d’une personne de plus de cinq ans peut être achetée entre 100 et 180 francs CFA[3] (100 francs CFA = 0,15 euros) selon les CSPS dans un même district.

L’analyse de la fidélité de l’implantation du FBR entreprise 12 mois après son démarrage montre que, globalement, les éléments importants et essentiels de la théorie d’intervention ont été implantés (Belaid et al. 2016). Cependant, nous avons noté des déficits d’implantation et des retards au niveau de la vérification de la performance et des paiements des subsides FBR, compromettant quelque peu l’efficacité théorique de la logique incitative. Bien que cette analyse de la fidélité soit essentielle, elle n’est pas suffisante pour comprendre le fonctionnement de l’intervention dans toutes ses subtilités. Ainsi, nous avons entrepris une analyse qualitative de la mise en œuvre du FBR au Burkina Faso selon un devis explicité dans la prochaine section.

Devis d’évaluation

Cette étude s’inscrit dans le courant des recherches interventionnelles et de l’évaluation fondées sur la théorie de l’intervention (Weiss 1998). La théorie de l’intervention FBR a guidé notre collecte et nos analyses de données. Au plan méthodologique, nous nous inscrivons dans la troisième génération de recherches sur la mise en œuvre des interventions en usant notamment d’études de cas multiples longitudinales (Saetren 2014). Cependant, au moment de la rédaction de ce chapitre, seulement la première de trois phases de collecte de données prévues pour les études de cas a été effectuée et est l’objet de cette présentation.

L’approche méthodologique est celle d’une étude de cas multiples (les CSPS) et contrastés avec plusieurs niveaux d’analyse imbriqués (les groupes d’acteurs et actrices concernés) (Yin et Ridde 2012). La sélection des cas a été explicitée ailleurs (Zombré et al. 2016). La recherche s’est déroulée dans trois districts sanitaires différents afin de représenter la diversité des processus de mise en œuvre du FBR. La collecte s’est déroulée dans un hôpital régional, deux hôpitaux de districts et 18 formations sanitaires de première ligne (CSPS). L’analyse pour les hôpitaux fait l’objet d’un autre rapport, car le contexte est différent. Une discussion de groupe avec les membres des trois équipes-cadres de district (ECD), soutenue par une analyse statistique des données de routine, a permis de classer les CSPS selon leur niveau de performance préalable au démarrage du FBR. La performance était ici comprise au regard des indicateurs d’utilisation des services disponibles dans ces données de routine dont la qualité a été vérifiée. Dans les deux districts qui organisent les FBR1, FBR2 et FBR3, un CSPS performant et un non performant ont été sélectionnés (n= 3 x 2 x 2). Dans le district organisant le FBR 1 et le FBR4, un CSPS performant, un CSPS moyennement performant et un CSPS non performant ont été sélectionnés (n= 3 x 2) (Figure 2). Dans chacun des districts, la recherche était sous la responsabilité d’un chercheur expérimenté du pays, socio-anthropologue, qui coordonnait la collecte des données réalisée par quatre assistant-e-s de recherche, responsables de la collecte des données dans deux ou trois CSPS du même type de FBR, sauf pour les hôpitaux où un seul assistant a réalisé la collecte de données. Ils et elles ont tous vécu 10 à 15 jours dans chaque village/ville où les formations sanitaires sont situées. Les trois collectes de données ont débuté à l’automne 2014, 2015 et 2016, respectivement. Un atelier de trois jours a réuni tous les chercheuses et chercheurs et assistants au démarrage de la recherche afin de coordonner la démarche, avec quelques séances de discussion avec des décideuses et décideurs et organisations mettant en œuvre l’intervention.

Quatre instruments de collecte de données qualitatives ont été utilisés.

1- Des observations (participantes et non participantes) ont été effectuées dans les villages (marchés, réunions communautaires, etc.) pour rédiger une monographie du contexte local et dans les formations sanitaires pour étudier les interactions entre les acteurs et actrices lors des consultations, les visites de contrôle et de supervision, etc. Les résultats des observations ont été consignés dans un journal de bord de chaque assistant.

2- Des entrevues formelles individuelles ont été effectuées à l’aide d’un guide préalablement testé, commun à tous les cas et concernant les dimensions de la théorie de l’intervention. Les personnes ont été sélectionnées après plusieurs jours de présence de terrain en fonction de leur capacité et disponibilité à apporter un éclairage utile sur le FBR et selon le principe d’un échantillonnage qui met l’accent sur la variation et l’intensité au sein d’un même groupe d’acteurs et actrices stratégiques (Palinkas et al. 2013) : agent-e-s de santé, agent-e-s de santé communautaires, membres du comité de gestion (COGES), élu-e-s et représentant-e-s associatifs locaux, usagers et populations. Le tableau 1 présente la répartition des 459 entrevues individuelles formelles selon les districts pour ce premier passage (rappelons que trois sont prévus au total afin de réaliser des études de cas longitudinales). En moyenne, nous avons réalisé 22 entrevues par aire de santé d’une formation sanitaire. La photo 1 illustre une entrevue formelle avec le président d’un COGES.

3- Des entrevues informelles ont été réalisées : contrairement aux précédentes, il s’agit d’entrevues non planifiées, effectuées sans enregistrement, mais essentielles à la compréhension du FBR dans un contexte d’aide au développement. Les personnes ont été sélectionnées au gré des opportunités (Palinkas et al. 2013) et de leur apport pour comprendre la situation étudiée. Des notes ont été prises par la suite afin de conserver les éléments les plus importants de la discussion. La dernière ligne du tableau 1 présente la répartition des 224 entrevues individuelles informelles selon les districts. Les défis liés à cette somme importante d’entrevues sont discutés à la fin du chapitre.

4- De nombreux documents ont été analysés : rapports d’activités et de formation, documents de formations, guide de mise en œuvre, registres de consultations, etc. Des synthèses des éléments importants ont été notées dans le journal de bord des assistant-e-s et chercheuses et chercheurs.

|

|

District 1 |

District 2 |

District 3 |

|

Membres de l’équipe-cadre du district |

8 |

2 |

5 |

|

Professionnel-le de santé |

36 |

46 |

52 |

|

Agent-e-s de santé communautaire |

8 |

12 |

22 |

|

Membres des COGES |

14 |

27 |

25 |

|

Élu-e-s, ONG et leaders locaux |

28 |

20 |

52 |

|

Utilisateurs et utilisatrices des services |

17 |

23 |

59 |

|

TOTAL ENTREVUES FORMELLES |

114 |

130 |

215 |

|

TOTAL ENTREVUES INFORMELLES |

168 |

30 |

26 |

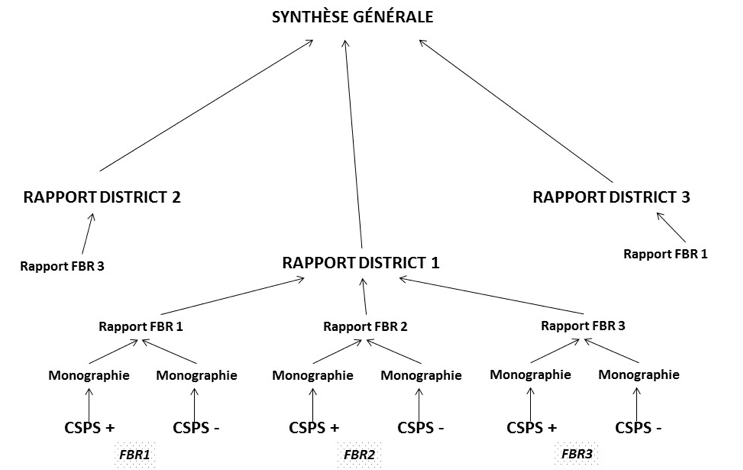

Toutes les entrevues ont été intégralement transcrites. Nous avons utilisé le logiciel QDA Miner Lite 4 pour assigner des thèmes aux segments de textes pertinents afin d’organiser et d’extraire les données. La deuxième autrice de ce chapitre a offert une formation sur le logiciel aux membres de l’équipe de recherche, notamment pour tester et adapter les codes ainsi que pour développer une compréhension commune du processus d’analyse. L’analyse a suivi une démarche déductive-inductive en assignant aux données des thèmes prédéfinis sur la base de notre cadre d’analyse (Ritchie et Spenzer 1994), soit la théorie de l’intervention, et en élaborant de nouveaux thèmes en lisant les transcriptions. Les assistant-e-s ont écrit une monographie et un rapport de recherche pour synthétiser les résultats de leurs études de cas (n= 4 assistant-e-s dans les 3 districts). Par la suite, les trois chercheuses et chercheurs responsables des districts ont effectué une analyse transversale intra district (n = 3 rapports). Enfin, le premier auteur a réalisé l’analyse transversale inter districts qui a été validée par les cochercheuses et chercheurs. La figure 3 présente ce processus analytique pour cette première analyse transversale. Le budget global d’une collecte de données (sur les trois prévues) est de l’ordre de 35 000 € comprenant les frais de collecte de données pour les assistants et leurs déplacements, les frais de transcriptions des entrevues, le paiement de leur temps pour les analyses, ainsi que le paiement d’honoraires pour les trois chercheuses et chercheurs séniors du Burkina Faso.

Quelques résultats

Nous résumons en quelques lignes les principaux résultats de cette recherche qualitative.

Fidèles à une méthode de « formation en cascade » organisée à très grande échelle (y compris par des formations à l’extérieur du pays pour certains cadres), toutes les personnes qui y ont participé sont les mieux informées sur les principes généraux et le mode de fonctionnement du FBR. Toutes les FS ont nommé un point focal FBR (c’est-à-dire une personne référente de l’intervention qui a été formée et qui est censée partager les informations. Mais au-delà de ce cercle, le niveau de connaissance décline pour devenir inexistant pour la population ou les leaders communautaires. Dans certains CSPS, l’octroi des primes au personnel n’a volontairement pas été annoncé aux populations et aux responsables communautaires. La vision globale des personnes rencontrées qui connaissent le FBR reste celle de la présence d’un « projet », comme tant d’autres avant et après ce dernier. Ainsi, les répondant-e-s savent qu’il est temporaire, financé et dirigé par l’aide internationale et qu’il peut provoquer de nombreuses logiques d’accaparement, notamment de ressources financières.

La mise en place des agences de contrôle et de vérification et des contrats de performance a pris beaucoup de retard, notamment dans le paiement des subsides et des primes. Ces retards dus à la lourdeur des procédures administratives s’accumulent (recrutement des ACV, signature des contrats, etc.) faisant en sorte que les acteurs et actrices locaux ne savent pas vraiment comment fonctionnent les contrats, les indicateurs ou les plans d’amélioration de la performance (servant à planifier les investissements tirés des subsides du FBR et des autres recettes pour améliorer les services). Les premières vérifications ont partout donné lieu à des discussions d’équipe et à des réajustements rapides des agent-e-s de santé afin que les suivantes soient meilleures pour recevoir le maximum de subsides possibles, car « quand FBR va venir pour l’évaluation, ils sont trop rigoureux, petite erreur, il n’y a pas de pardon dans FBR ! ». Mais la vérification quantitative est souvent source de polémiques (entre vérificateurs et agent-e-s de santé, entre le personnel soignant et le personnel de soutien, et au sein du personnel soignant). En outre, dans quelques CSPS de plusieurs districts, nous avons constaté la préparation d’une mise en scène préalable au contrôle. Ce dernier est toujours annoncé ou simplement connu, car les informations circulent vite dans ces milieux où le niveau d’interconnaissance est important. De même, certaines données sont inscrites dans les registres, car elles font partie des vérifications, alors que nos observations montrent qu’elles ne sont pas réelles. C’est le cas, par exemple, des prises de constantes des patient-e-s (température, tension, poids) ou du remplissage des partogrammes, que certains agent-e-s de santé nomment des « postogrammes » en privé (c’est-à-dire remplis après coup), tel que cela nous a été rapporté lors des entrevues informelles.

La distribution des primes individuelles est variable entre les centres de santé. Elle dépend du leadership local et des enjeux de pouvoir. Dans certains cas, un manque absolu de transparence est constaté. Ailleurs, mais cela semble être une exception, dans un CSPS performant, le responsable a décidé d’associer tous les agent-e-s de son équipe pour effectuer les calculs des primes en toute transparence.

Dans son design, le FBR n’a pas prévu que des primes soient données aux membres des COGES qui gèrent pourtant le budget, le compte bancaire du CSPS et la mobilisation communautaire. La plupart des formations sanitaires ont respecté cette règle, mais d’autres s’y sont opposées, car elles la trouvaient injuste compte tenu du travail important réalisé par ces membres de la communauté locale. De plus, ce sont eux et elles qui réceptionnent les importantes subventions provenant de l’achat des services par le FBR. Un président de COGES disait à cet égard : « il faut que le FBR songe à motiver aussi les membres du COGES. Comment quelqu’un va aller retirer plus de 400 000 F CFA [600 euros] pour venir donner aux agents qui vont se partager! ».

En somme, les résultats démontrent combien l’adaptation et l’évolution sont la norme et non pas l’exception dans la mise en œuvre des interventions de santé publique, ce qui pose évidemment des défis d’évaluation (Perez et al. 2013 ; Ridde et Robert 2014). L’intervention de FBR était très centralisée, son contenu planifié et défini en détail, mais sa rencontre du contexte, des acteurs et actrices et des événements a conduit à ce que tout ne se passe pas comme prévu. Les retards importants des paiements et les enjeux majeurs autour de la distribution des primes sont inquiétants. La faible appropriation locale et le financement externe posent des défis de pérennité, car tant que les responsables gouvernementaux ne se seront pas engagés dans ce type d’intervention et n’auront pas prévu des ressources financières étatiques, la continuité de l’approche est compromise.

Analyse réflexive

La force de notre analyse est qu’elle repose sur une triangulation empirique d’un échantillon très important de données et de cas contrastés, ainsi que sur une collaboration interdisciplinaire assurant la qualité des données. Tous les assistant-e-s ont été formé-e-s et suivi-e-s pour s’assurer de la rigueur de leur travail et la fine connaissance du contexte et des politiques de santé au Burkina Faso par les chercheuses et chercheurs rend leurs interprétations solides. Ce type de processus est relativement rare en Afrique, car on demande souvent aux assistant-e-s de « simplement » collecter les données qui sont ensuite analysées par les chercheuses et chercheurs du pays, voire pire uniquement par les chercheuses et chercheurs du Nord (Ouattara et Ridde 2013). Cela n’a évidemment pas été facile et le contexte du Burkina s’y prête peut être mieux qu’ailleurs, car nous y travaillons depuis longtemps, disposant ainsi d’un réseau de chercheuses et chercheurs de longue date, en général rattaché-e-s à des institutions. Ils ont ainsi un large réseau d’étudiant-e-s au sein duquel nous avons été en mesure de trouver des personnes compétentes. Au Mali où nous tentons d’organiser le même processus, la situation est plus complexe, les ressources humaines semblant plus rares et nos collègues chercheuses et chercheurs moins associés à des programmes de formation pour disposer d’un réseau d’étudiant-e-s.

Les résultats ont été largement partagés et validés auprès de nombreuses parties prenantes du FBR dans le pays. Ainsi, nous pensons qu’ils peuvent être transférables à l’ensemble des districts du pays impliqués dans la mise en œuvre du FBR.

De plus, les résultats seront certainement utiles pour mieux comprendre l’évaluation d’impact. Depuis le début de cette recherche sur la mise en œuvre, nous entretenons des liens étroits avec les chercheuses et chercheurs de l’équipe de l’évaluation d’impact. Notre expertise sur la mise en œuvre s’est avérée utile pour aider cette équipe à mieux comprendre le déroulement réel de l’intervention (au-delà des manuels d’intervention initiaux) et à adapter une partie de leurs questionnaires standardisés de fin afin d’améliorer leur pertinence dans le contexte local. Cette collaboration représente une valeur ajoutée pour nos recherches respectives et le développement de connaissances en faisant le pont entre les approches qualitatives et quantitatives.

Dans le cas de cette étude de mise en œuvre, le défi majeur reste la quantité très (trop ?) importante de données qualitatives et donc son corollaire qui a été la durée de l’analyse. Il a fallu plus d’un an pour disposer des premiers rapports d’analyse des cas permettant de démarrer une analyse collective et transversale des 459 entrevues formelles et 224 entrevues informelles provenant des 21 formations sanitaires. L’utilisation d’un processus pyramidal par lequel chaque membre de l’équipe a analysé et synthétisé des données à un niveau différent (CSPS, district et général) a facilité la gestion des données en répartissant la charge de travail. En ayant recours à une telle quantité de données collectées à travers différents sites, nous espérons que les résultats pourront expliquer l’hétérogénéité de la mise en œuvre, en plus de convaincre un large public cible de la validité des résultats, incluant des décideuses et décideurs et certains chercheuses et chercheurs pour qui la taille de l’échantillon demeure essentielle. En effet, notre expérience dans la région montre que, bien souvent, les décideuses et décideurs discréditent les recherches qualitatives à cause de la faible taille des échantillons, ne maitrisant pas les notions de saturation empirique ou n’ayant pas de connaissances des critères de scientificité en qualitatif (Laperrière 1997). Dans ce contexte, comment trouver un bon équilibre entre le besoin de données suffisantes pour répondre à une question de recherche complexe autour d’une intervention de grande ampleur et disposant de multiples composantes (bras), les défis éthiques de rencontrer autant de personnes et de mobiliser une équipe aussi importante, et les demandes des décideuses et décideurs d’une plus grande validité externe des évaluations de programmes ? La présente analyse de la mise en œuvre est une tentative de réconciliation de ces mondes sans pour autant avoir la prétention de clore la discussion.

Un autre défi dans le contexte de cette collaboration internationale a été de maintenir une communication dynamique entre les différents membres de l’équipe, dispersés dans différentes régions au Burkina Faso et à travers le monde. Nous avons eu écho de malentendus, notamment en lien avec les rôles de chacun des membres de l’équipe, les méthodes de collecte de données, les délais de l’étude et les modalités de rémunération des assistant-e-s de recherche. La distance, la taille de l’équipe et les problèmes de réseaux de communication, ainsi que les coûts associés, ont certainement contribué à l’ampleur du défi. En outre, dans le contexte d’une collaboration internationale, les retards dans les analyses et les partages des rapports ne sont jamais simples à gérer, car il faut à la fois être un chercheur ou chercheuse (du Nord qui plus est !) et travailler avec des collègues, mais en même temps régler les questions financières et de délais pour disposer de produits suffisamment solides. Ces défis sont bien connus (Ouattara et Ridde 2013).

Une des forces de notre démarche a été l’organisation d’une formation sur l’utilisation d’un logiciel d’analyse qualitative gratuit (QDA miner lite) pour les membres de l’équipe (voir Photo 2). Peu commune au Burkina Faso, cette formation a permis de renforcer les capacités des assistant-e-s pour cette recherche ainsi que pour leur future carrière dans le domaine. Il s’agissait aussi d’une occasion de les intégrer dans l’ensemble du processus et de ne pas en faire de simple collecteurs de données, comme c’est bien souvent le cas, ce qui pose des problèmes importants pour les recherches qualitatives. Plusieurs participant-e-s ont exprimé leurs intérêts et gratitude à cet égard.

Une difficulté principale lors de la formation a été de gérer les différents niveaux de compétence en informatique des participant-e-s. Nous avons dû trouver un rythme convenant à l’ensemble du groupe. Une autre des difficultés rencontrées lors de la formation a été de se mettre d’accord sur les définitions et la pertinence de certains codes d’analyse. Par exemple, nous avons eu un débat sur la création de codes distinct pour « utilité du FBR » et « pertinence du FBR ». Ces discussions sont importantes pour développer une compréhension commune du processus d’analyse, mais peuvent être laborieuses lorsqu’il y a une centaine de codes à élaborer. Par ailleurs, l’utilisation d’un logiciel d’analyse qualitative pour organiser les données a facilité la réalisation d’analyses secondaires pour étudier des thématiques spécifiques (par exemple, la qualité des soins, la motivation des acteurs et actrices) subséquemment.

Malgré les efforts de certains membres de l’équipe, la centralisation des nombreux documents de la recherche (enregistrements des entrevues, notes d’observations, transcriptions des entrevues, données codifiées) a constitué un défi majeur pour cette étude. La centralisation des documents est importante afin d’éviter la perte de données, de vérifier des données brutes et de permettre des analyses secondaires. Toutefois, la centralisation s’est avérée difficile tout au long de la recherche, notamment en raison de la dispersion géographique des assistant-e-s de recherche et de la mauvaise connexion internet qui nuit au partage rapide de fichiers lourds. Plus de trois ans après le début de cette recherche, nous continuons de solliciter la centralisation de tous les documents.

Cette étude s’est inscrite dans le courant de l’évaluation fondée sur la théorie de l’intervention. Ainsi, c’est plus la théorie de l’intervention qui a guidé la collecte et l’analyse des données que les cadres ou théories de la science de la mise en œuvre. Cela étant dit, les concepts de ce champ ont largement été utilisés lors de nos réflexions et analyses, par exemple la notion de contexte, le rôle des acteurs et actrices et des enjeux de pouvoir, les déficits de mise en œuvre, le rôle central des acteurs et actrices de première ligne compris comme les véritables « faiseurs » de politique (Lipsky 2010; Pfadenhauer et al. 2015; Pressman et Wildavsky 1984 ; Shoveller et al. 2015), etc. Au Mali cependant, nous nous sommes largement inspirés d’un cadre conceptuel spécifique pour l’analyse de la mise en œuvre afin d’étudier l’intervention de FBR dans une région du pays (Damschroder et al. 2009). Nous serons en mesure d’en tirer prochainement des leçons, notamment dans les défis de son usage par des anthropologues qui sont peu habitués, et c’est normal, à trop encadrer les dimensions qu’ils et elles étudient. Mais face à la complexité des interventions, au besoin d’études de cas multiples pour augmenter la validité externe des résultats demandée par les décideuses et décideurs plus habitués aux données quantitatives et à la quantité phénoménale de données qualitatives nécessaires, le passage par ce type de cadre conceptuel et d’analyse assistée par ordinateur est peut-être incontournable. Il devient essentiel de tenter d’innover dans ce domaine (Belaid et al. 2016).

Le chapitre présente des résultats d’une collecte de données transversale, traduisant la situation à un moment donné et non son évolution (bien que, même au cours des 12 mois de l’étude, des adaptations aient été largement constatées). Mais nous souhaitions partager les résultats sans attendre les autres phases tant les recherches sur le sujet sont rares en Afrique de l’Ouest francophone. Les prochaines phases de notre programme de recherche permettront de mieux comprendre les changements dans l’intervention, son adaptation, et la manière dont le contexte et les acteurs et actrices agissent dans le temps. Les études de cas longitudinales sont en effet essentielles à la compréhension des politiques, mais difficiles à organiser (Saetren 2014; Ridde et al. 2014; Hill et Hupe 2014).

L’évaluation des processus de mise en œuvre des interventions est essentielle, non seulement car elle permet de comprendre les effets (ou leur absence) des actions entreprises, mais surtout, car elle rend compte de la complexité des processus, du rôle des acteurs et actrices et du contexte. Ce chapitre présente un exemple de la manière dont la théorie de l’intervention, et plus largement des cadres conceptuels de la science de la mise en œuvre, peuvent être mobilisés à cet égard. Assurément, nous avons collectivement besoin de plus d’évaluations de la mise en œuvre des interventions en santé mondiale, mais aussi de meilleures évaluations, notamment avec l’utilisation de cadres conceptuels et de données qualitatives.

Références clés

Patton, M. Q. (2008). Implementation Evaluation: What happened in the program? Utilization-focused Evaluation. 4th Edition. Saint-Paul: SAGE Publications.

Patton livre un plaidoyer convaincant sur l’importance d’étudier la mise en œuvre d’interventions. L’auteur raconte l’histoire farfelue d’un groupe d’évaluateurs et évaluatrices qui a évalué les effets d’une intervention qui n’avait jamais réellement été implantée, tirant de mauvaises conclusions sur son inefficacité. L’auteur présente cinq types d’évaluation : l’évaluation des efforts, le monitorage, l’évaluation des processus, l’évaluation des composantes et la spécification du traitement. Le chapitre termine avec une liste d’exemples de questions d’évaluation en lien avec la mise en œuvre.

Damschroder, L. et al., (2009). Fostering implementation of health services research findings into practice: A consolidated framework for advancing implementation science. Implementation Science, 4(50).

Cet article présente un modèle conceptuel, le Consolidated Framework For Implementation Research, issu de différentes théories. Le modèle est composé de cinq domaines : les caractéristiques de l’intervention, le milieu externe, le milieu interne, les caractéristiques des individus et le processus d’implantation. Les auteurs présentent des définitions utiles pour les différents concepts et leurs construits. Plusieurs autres ressources sont disponibles sur le site internet suivant : https://cfirguide.org/

Olivier de Sardan, J.-P. (2008). La rigueur du qualitatif. Les contraintes empiriques de l’interprétation socioanthropologique. Louvain-La-Neuve: Bruylant.

C’est un livre à lire absolument! Il permet de saisir l’importance de s’insérer de façon prolongée dans un milieu pour comprendre la mise en œuvre d’une intervention. Il permet aussi de s’outiller pour faire face aux enjeux de l’observation participative. Le livre aborde plusieurs questions importantes: Sur quelles procédures repose l’observation? Quelles sont les conditions de la rigueur dans les approches qualitatives? Quelle place accorder à la subjectivité du chercheur ou de la chercheuse? Peut-on minimiser les pièges de la surinterprétation ou les biais des idéologies scientifiques?

Ridde, V., Yaogo, M., Somé, P.-A., Turcotte-Tremblay, A.-M., (2017). Twelve months of implementation of health care performance-based financing in Burkina Faso: A qualitative multiple case study. The International Journal of Health Planning and Management. 33 (1), e153-e167.

Cet article présente notre étude sur la mise en œuvre du financement basé sur les résultats au Burkina Faso. Il permettra de voir un exemple concret du type d’article scientifique que l’on peut publier en étudiant la mise en œuvre d’une intervention complexe en santé mondiale. L’article contient une référence à notre protocole complet qui pourra vous servir d’exemple pour développer un protocole visant à comprendre comment une intervention fonctionne, pour qui et dans quels contextes réels.

Références

Belaid, L., Bodson, O., Ridde, V., Samb, O. et Turcotte-Tremblay, A.-M. (2016). Innovations qualitatives dans l’évaluation des interventions en santé. Dans J. Kivits, F. Balard, C. Fournier et M. Winance (dir.), Les recherches qualitatives en santé (p. 260-276). Malakoff : Armand Colin.

Béland, D. et Ridde, V. (2016). Ideas and policy implementation: Understanding the resistance against free health care in Africa. Global Health Governance, 10(3), 9-23.

Breton, E. et De Leeuw, E. (2011). Theories of the policy process in health promotion research: a review. Health Promotion International, 26(1), 82-90.

Cox, R. H. (2001). The social construction of an imperative: Why welfare reform happened in Denmark and the Netherlands but not in Germany. World Politics, 53(3), 463-498.

Damschroder, L. J., Aron, D. C., Keith, R. E., Kirsh, S. R., Alexander, J. A. et Lowery, J. C. (2009). Fostering implementation of health services research findings into practice: A consolidated framework for advancing implementation ccience. Implementation Science, 4, 50-64.

https://doi.org/10.1186/1748-5908-4-50

Dobson, D. et Cook, T. D. (1980). Avoiding type III error in program evaluation : Results from a field experiment. Evaluation and Program Planning, 3(4), 269-276.

Durlak, J. A. et DuPre, E. P. (2008). Implementation matters: A review of research on the influence of implementation on program outcomes and the factors affecting implementation. American Journal of Community Psychology, 41(34), 327-350.

https://doi.org/10.1007/s10464-008-9165-0

Durlak, J. A. (2015a). What everyone should know about implementation. Dans J. A. Durlak, C. E. Domitrovich, R. Weissberg et T. Gullotta (dir.), Handbook of social and emotional learning: research and practice (p. 395-405). New York: The Guilford Press.

Durlak, J. A. (2015b). Studying program implementation is not easy but it is essential. Prevention Science, 16(8), 1123-1127.

https://doi.org/10.1007/s11121-015-0606-3

Franks, B. et Schroeder, J. (2013). Implementation science : What do we know and where do we go from here?. Dans A. Metz et I. Martinez-Beck (dir.), Applying implementation science in early childhood programs and systems (p. 5–21). Baltimore: Paul H. Brookes Publishing Company.

Gilson, L. et Raphaely, N. (2008). The terrain of health policy analysis in low and middle income countries: a review of published literature 1994–2007. Health Policy and Planning, 23(5), 294-307.

Hill, M. J. et Hupe, P. L. (2014). Implementing public policy: an introduction to the study of operational governance (3e éd.). Thousand Oaks, CA: Sage Publications.

Laperrière, A. (1997). Les critères de scientificité des méthodes qualitatives. Dans J. Poupart, J-P. Deslauriers, L-H. Groulx, A. Laperrière, R. Mayer et A.P. Pires (dir.), La recherche qualitative : enjeux épistémologiques et méthodologiques (p. 365-389). Montréal : Gaëtan Morin.

Lipsky, M. (2010). Street-level bureaucracy: Dilemmas of the individual in public services. New York : Russel Sage Foundation.

Milstein, R. et Schreyoegg, J. (2016). Pay for performance in the inpatient sector: A review of 34 P4P programs in 14 OECD countries. Health Policy, 120(10), 1125-1140.

https://doi.org/10.1016/j.healthpol.2016.08.009

Nilsen, P., Ståhl, C., Roback, K. et Cairney, P. (2013). Never the twain shall meet? – a comparison of implementation science and policy implementation research. Implementation Science, 8, 63.

https://doi.org/10.1186/1748-5908-8-63

Olivier de Sardan, J.-P et Ridde, V. (2015). Public policies and health systems in Sahelian Africa: Theoretical context and empirical specificity. BMC Health Services Research, 15(Suppl. 3), S3.

https://doi.org/10.1186/1472-6963-15-S3-S3

Ouattara, F. et Ridde, V. (2013). Expériences connues, vécues… mais rarement écrites : à propos des relations de partenariat Nord-Sud. Nouvelles Pratiques Sociales, 25(2), 231-246.

Palinkas, L. A., Horwitz, S. M., Green, C. A., Wisdom, J. P., Duan, N. et Hoagwood, K. (2013). Purposeful sampling for qualitative data collection and analysis in mixed method implementation research. Administration and Policy in Mental Health and Mental Health Services Research, 42(5), 533-544.

https://doi.org/10.1007/s10488-013-0528-y

Patton, M. Q. (2010). Developmental evaluation : Applying complexity concepts to enhance innovation and use. Lieu d’édition: The Guilford Press.

Paul, E., Sossouhounto, N. et Eclou, D. S. (2014). Local stakeholders’ perceptions about the introduction of performance-based financing in Benin: A case study in two health districts. International Journal of Health Policy and Management, 3(4), 207-214.

https://doi.org/10.15171/ijhpm.2014.93

Perez, D., Lefevre, P., Castro, M., Toledo, M. E., Zamora, G., Bonet, M. et Van der Stuyft, P. (2013). Diffusion of community empowerment strategies for Aedes aegypti control in Cuba: A muddling throughexperience. Social Science and Medicine, 84, 44-52.

https://doi.org/10.1016/j.socscimed.2013.02.003

Peters, D. H., Adam, T., Alonge, O., Agyepong, I. A. et Tran, N. (2013). Implementation research: what it is and how to do it. British Medical Journal, 347, f67-53.

https://doi.org/10.1136/bmj.f6753

Peters, D. H., El-Saharty, S., Siadat, B., Janovsky, K. et Vujicic, M. (dir.). (2009). Improving health service delivery in developing countries: from evidence to action. Washington: World Bank.

Petticrew, M., Cummins, S., Ferrell, C., Findlay, A., Higgins, C., Hoy, C., … et Sparks, L. (2005). Natural experiments: an underused tool for public health?. Public Health, 119(9), 751-757.

Pfadenhauer, L. M., Mozygemba, K., Gerhardus, A., Hofmann, B., Booth, A., Bakke, K. B., … et Rehfuess, E. A. (2015). Context and implementation: A concept analysis towards conceptual maturity. Zeitschrift Für Evidenz, Fortbildung Und Qualität Im Gesundheitswesen, 109(2), 103-114.

https://doi.org/10.1016/j.zefq.2015.01.004

Pressman, J. L. et Wildavsky, A. (1984). Implementation: How great expectations in Washington are dashed in Oakland (3e éd.). Berkeley, Los Angeles, London : University of California Press.

Proctor, E., Silmere, H., Raghavan, R., Hovmand, P., Aarons, G., Bunger, A., … et Hensley, M. (2011). Outcomes for implementation research: Conceptual distinctions, measurement challenges, and research agenda. Administration and Policy in Mental Health, 38(2), 65-76.

https://doi.org/10.1007/s10488-010-0319-7

Ridde, V. (2009). Policy implementation in an African state : an extension of the Kingdon’s multiple-streams approach. Public Administration, 87(4), 938-954.

Ridde, V., Delormier, T. et Gaudreau, L. (2007). Evaluation of empowerment and effectiveness: Universal concepts ?. Dans D. V. McQueen et C. M. Jones (dir.), Global Perspectives on Health Promotion Effectiveness (vol. 1, p. 389-403). New York: Springer Science et Business Media.

Ridde, V. et Robert, É. (2014). Real World Evaluation Strategies. Oxford University Press.

http://www.oxfordbibliographies.com/display/id/obo-9780199756797-0140

Ridde, V., Turcotte-Tremblay, A.-M., Souares, A., Lohmann, J., Zombré, D., Koulidiati, J., … et De Allegri, M. (2014). Protocol for the process evaluation of interventions combining performance-based financing with health equity in Burkina Faso. Implementation Science, 9(1), 149-160.

https://doi.org/10.1186/s13012-014-0149-1

Ritchie, J. et Spenzer, L. (1994). Qualitative data analysis for applied policy research. Dans A. Bryman et R. G. Burgess (dir.), Analyzing qualitative data (p. 173-194). Londres and New York: Routledge.

Saetren, H. (2014). Implementing the third generation research paradigm in policy implementation research: An empirical assessment. Public Policy and Administration, 29(2), 84-105.

https://doi.org/10.1177/0952076713513487

Shoveller, J., Viehbeck, S., Di Ruggiero, E., Greyson, D., Thomson, K. et Knight, R. (2015). A critical examination of representations of context within research on population health interventions. Critical Public Health, volume(numéro), 114.

https://doi.org/10.1080/09581596.2015.1117577

Siron, S., Dagenais, C. et Ridde, V. (2015). What research tells us about knowledge transfer strategies to improve public health in low-income countries: A scoping review. International Journal of Public Health, 60(7), 115.

https://doi.org/10.1007/s00038-015-0716-5

Turcotte-Tremblay, A.-M., Spagnolo, J., De Allegri, M. et Ridde, V. (2016). Does performance-based financing increase value for money in low- and middle- income countries?: A systematic review. Health Economics Review, 6(1).

https://doi.org/10.1186/s13561-016-0103-9

United Nations Secretary-General. (2010). Global Strategy for Women’s and Children’s health. Geneva : World Health Organization.

http://www.who.int/pmnch/knowledge/publications/fulldocument_globalstrategy/en/.

Van Belle, S., van de Pas, R. et Marchal, B. (2017). Towards an agenda for implementation science in global health: there is nothing more practical than good (social science) theories. BMJ Global Health, 2(2), e000181.

https://doi.org/10.1136/bmjgh-2016-000181

Walt, G., Shiffman, J., Schneider, H., Murray, S. F., Brugha, R. et Gilson, L. (2008). “Doing” health policy analysis: Methodological and conceptual reflections and challenges. Health Policy and Planning, 23(5), 308-317.

Weiss, C. H. (1998). Evaluation : methods for studying programs and policies (2e éd.). Upper Saddle River, NJ : Prentice Hall.

Witter, S., Fretheim, A., Kessy, FL. et Lindahl, AK. (2012). Paying for performance to improve the delivery of health interventions in low- and middle-income countries. Cochrane Database of Systematic Review, 2, CD007899.

Yin, R.K., et Ridde, V. (2012). Théorie et pratiques des études de cas en évaluation. Dans V. Ridde et C. Dagenais (dir.), Approches et pratiques en évaluation de programme (2e éd., p. 177-193). Montréal : Presses de l’Université de Montréal.

Zombré, D., Turcotte-Tremblay, A.-M., Sangaré, A., Zongo, S., Somé, P.-A., Coulibaly, A., … et Ridde, V. (2016). Méthode mixte et participative de sélection d’études de cas multiples pour l’évaluation d’intervention de santé au Burkina Faso et au Mali : De l’éthique à l’émique. Communication présentée au Congrès de l’Association francophone pour le savoir, Montréal.

https://docs.google.com/viewerng/viewer?url=http://www.equitesante.org/wp-content/uploads/2016/05/Poster.David_.ACFAS_.pdfethl=fr.

Résumé / Abstract / Résumé en moore / Résumé en dioula

Plus de recherches sur la mise en œuvre sont nécessaires pour comprendre comment les interventions fonctionnent dans leur contexte réel et comment elles évoluent dans le temps. L’objectif de ce chapitre est de présenter l’analyse de la mise en œuvre d’une intervention complexe, intitulée le financement basé sur les résultats, au Burkina Faso. Nous avons effectué une étude de cas multiples (18 formations sanitaires) et contrastés avec plusieurs niveaux d’analyse imbriqués. Les données empiriques proviennent d’observations, d’entrevues informelles et formelles et de documents. Pour faciliter l’analyse d’une quantité importante de données, nous avons utilisé un processus pyramidal par lequel chaque membre de l’équipe a analysé et synthétisé des données à un niveau différent (centre de santé, district et général). Ainsi, les assistants de recherche ont participé à l’ensemble du processus d’analyse. L’organisation d’un atelier sur l’utilisation d’un logiciel d’analyse qualitative accessible gratuitement a permis de développer une compréhension commune du processus d’analyse. Les résultats de la recherche montrent l’importance d’ouvrir la « boite noire » pour comprendre la mise en œuvre des interventions de santé publique en Afrique et mettre au jour leurs adaptations selon les contextes et les acteurs et actrices sociaux.

***

More research on implementation is needed to understand how interventions work in their real context and how they evolve over time. The objective of this chapter is to present the process of analyzing the implementation of a complex intervention, called performance-based financing, in Burkina Faso. We conducted a multiple and contrasted case study (18 healthcare facilities) with several levels of analysis. The empirical evidence comes from observations, informal and formal interviews and documents. To facilitate the analysis of a large amount of data, we used a pyramid process whereby each team member analyzed and synthesized data at a different level (healthcare facility, district, general). Thus, the research assistants participated in the whole process of analysis. The organization of a workshop on the utilization of a free qualitative analysis software allowed the development of a common understanding of the analysis process. The results of the study highlight the importance of opening the “black box” to understand the implementation of interventions in global health and to shed light on their adaptations according to the contexts and the social actors.

***

Sen na yɩle ti d wʋm sõngrã na-kendr ã võor la a sen teesde, tʋʋmdã siglgl toga ne vaεεsg tɩ seke. Zãms- kãnga yegre yaa sen na yɩl n wilg bumb ning sen be sõng-kaseng sen sigend tʋʋm- biis zug Burkina faaso ka wã . Tõnd talla bʋgsg sen keed ne yεl buud toor-toor logtoy-yi ziis piig la nii(18) n tɩ yek ne vaεεsg bεd a taaba.

Vaεεs kãng biisã tuuda ne ziig pʋge gesgo, sõsg ne neb la sεb wʋsg me karengo. Sen na yɩl tɩ veenem zind vaεεs kaseng kãnga zugu faag-faaga tõnd kɩtam ti tʋm- tʋmdb sen be yingr n tãag tengr kõ b tagsgo (logto-yi la bεd la boonese). Rend bãngdba taoor dãmba zĩnda tʋʋmda sɩngre n tɩ tãag a baasgo.

Tigsg sen n kõ zãmsg tʋʋma-teed zug zaalem sõngam tɩ bãng sõng paam vaεεsgã zugu. Tʋʋmda biis wilgam tɩ yaa tɩlae ti b pak koglg buud sen na n sõng ninsables zamaana laafɩ wa koglgo, la b le wilg sen tokd ne tʋm-tʋmdba fãa raabo.

***

Fɛɛrɛ yaala ka taga lçnni fanfɛ min be na ni kow famuyali basigili ye, ka kan ka sira damanin ta min sababura famuyali kɛrɛn kɛrɛn be dafali sçrç. Nin baara nin kunsiyçrç ye, ka se ka sɛgɛsɛgɛli kɛ ka taga kow gwɛlɛma fɛrɛ fanfɛ a be fç min ma ko harajigɛ jaga bç n’o basigira tçnç sçrçli kan Burukin Faso yan.

An ye sɛgɛsɛgɛli kɛ koo caaman le kan dçgçtçrçso tan ani segi(18) le kan minw bçlen tɛ yçngçn ma.ɛɛgɛsɛgɛli baara kɛra ka taga baro ani sɛbɛn damani kçnç ka se ka lççni sçrç o senkçrç.Ka se ka famuyali sçrç o sɛgɛsɛgɛli kan nin kan, an ye tagamasiyɛn jçnjçn ta minw sabababura baarakɛla minw bɛɛ tun be jɛnkulu nin kçnç ka se k’o lçyçrç baara kɛ.(Dçgçtçrçsodennin, a n’afabaw). ka tugu minw tun be lççnikɛlagana nunu dɛmɛ ka baara sɛgɛsɛgɛli nin kɛ, o fana ye tali kɛ baara mumɛ bɛɛ ra.

Yçngçnyebaara dç sigi ra ka se ka lçnni sɛgɛsɛgɛli nin baarakɛminanw labila gwansan min senkçrç bɛɛ ka se ka famuyali kelen sçrç a ra ani o hakilinata ka kɛ kelen ye. Baara nin ka fɛrɛ kɛra sababu ye ka gondon damani famuyali nçgçya ka taga jamakulu ka hɛrɛ kow lasigili kan farafina jamana kçnç.Baarakɛminaw min bilara lçnnikɛla bolo dira o ma gwansan. A ti san ni wari ye.ɛɛgɛsɛgɛli nin tçnç, lçnnikɛlaw ka min basigi ka taga hɛrɛko fanfɛ farafina bolo kçnç ka se bɛn jamakulu ka hakilinata ye ,ani k’o fɛrɛw kɛrɛnkɛrɛn ta ka k’o ka sininyasigi jagabç wala lçnnikɛlaw ya yira cogomina.

Nous remercions Alain Ouédraogo, Ahmed Sie Barro, Mme Namoano Solange et Abbe Anselme Yanogo pour les traductions en langue moore et dioula.

***

Valéry Ridde est directeur de recherche au CEPED[4], une Unité Mixte de Recherche associant l’Université Paris Descartes et l’Institut de Recherche pour le Développement (IRD). Il est chercheur régulier de l’Institut de recherche en santé publique de l’Université de Montréal (IRSPUM) et chercheur associé au Centre interdisciplinaire de recherche en développement international et société (CIRDIS) de Montréal. Il est rédacteur adjoint des revues BMJ Global Health et Global Health Promotion, membre du comité de rédaction de la Revue Canadienne d’Évaluation de Programme et de Qualitatif! Revue africaine de sciences sociales. Ses travaux de recherche portent sur la couverture universelle en santé, le financement des services de santé, l’évaluation de programme, les politiques publiques de santé et la promotion de la santé.

Anne-Marie Turcotte-Tremblay est candidate au doctorat en santé publique avec une spécialisation en organisation des soins à l’École de santé publique de l’Université de Montréal (ESPUM). Elle est également affiliée à l’Institut de recherche en santé publique de l’Université de Montréal (IRSPUM). Sa thèse de doctorat porte sur les conséquences non intentionnelles du financement basé sur les résultats combinés à des mesures de protection sociale au Burkina Faso. Anne-Marie est boursière des Instituts de recherche en santé du Canada (IRSC). Elle a coordonné plusieurs recherches internationales en santé des populations. Anne-Marie s’intéresse à l’évaluation d’interventions visant à réduire les inégalités sociales de santé.

Citation

Valéry Ridde et Anne-Marie Turcotte-Tremblay. (2019). L’analyse des processus de mise en œuvre. Une intervention complexe au Burkina Faso : le financement basé sur les résultats. In Évaluation des interventions de santé mondiale. Méthodes avancées. Sous la direction de Valéry Ridde et Christian Dagenais, pp. 355-381. Québec : Éditions science et bien commun et Marseille : IRD Éditions.

- Toutes les traductions des citations en anglais sont des traductions libres des auteurs de ce chapitre ↵

- Tout comme le terme « implementation » qui est traduit de manière très différente en français par implantation, implémentation (Suisse, Belgique), mise en œuvre, etc. Dans ce livre, le terme anglais « implementation » est traduit par « implantation » quand on évoque une analyse de la conformité ou de la fidélité (voir le chapitre de Perez et al.) et « processus de mise en œuvre » dans le présent chapitre quand il s’agit de comprendre le fonctionnement de l’intervention. ↵

- Communauté Financière Africaine. ↵

- http://www.ceped.org ↵